生成式人工智能存在两个巨大的问题,但有一个解决方法。

由史蒂文·J·谢马里尼 (Steven J. Sermarini) ,MSE软件工程撰写

[Dall-e利用生成式人工智能技术创建的图像]

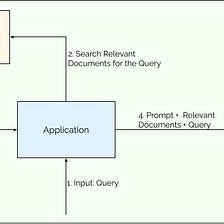

无论是 ChatGPT,Google Bard 还是任何其他基于 LLM 的生成式人工智能工具(简称 GenAI),它们未来都面临着一些同样的挑战。本文讨论了两个基本的挑战,并提供了一个潜在的解决方案,不仅解决了这些问题,而且还为消费者和科技公司提供了一些额外的好处。

这两个问题是相互关联的:

- 幻觉——为了增加创造性价值并尝试模仿人类生成内容的模式,这些工具有时可能会构造非事实的数据,甚至不是直接来源。它通常向用户呈现这些数据,它们被视为事实,尽管它们可能完全是虚构的。对于这些工具的用户来说,数据是否真实并不清楚,可能需要事实核查以确保数据的使用是适当的。

- 自我监督学习——这是一种递归的训练方法,机器学习模型在其自身数据产品的输出上进行训练。考虑到媒体产品生成工具的大规模加速——再加上将数据错误地表述为事实的幻觉效果。所有这些都成为AI进行训练的源数据——在一个不断循环的过程中。

这基本意味着,由AI创建的虚假内容的一些百分比将被吸收回LLM培训数据中,并由AI用于创建新内容。 在大多数情况下,GenAI工具无法区分事实和非事实。很容易看出这如何加剧数据失真的问题,导致整体模型熵增加。 随着时间的推移,GenAI对事实数据的腐败将变得更加明显,输出质量将受到影响。