我们需要像GPT4这样的LLMs来进行离线使用:以下是阻碍我们的问题

我喜欢ChatGPT和Bing搜索,但我希望我可以在我的本地电脑上(笔记本电脑)拥有类似的功能进行离线使用。这样做的原因有两个:

1. 即使我没有连接到互联网,我也想要一个助手。

2. 我想要与一个能够意识到我正在电脑上做什么以及我之前所做的工作的聊天界面进行交互。

目前这是不可能的,这意味着我必须为聊天界面提供大量的上下文信息,实质上向一家可能正在记录我的信息的公司提供有关我的信息。从隐私和用户体验的角度来看,我希望看到聊天基于人工智能与互联网分离,并更改为一种形式,其中LLM只收到更新,而永远不会发送信息。

然而,这里有一些需要克服的挑战,在这个故事中,我会讨论这些挑战是什么。

计算资源

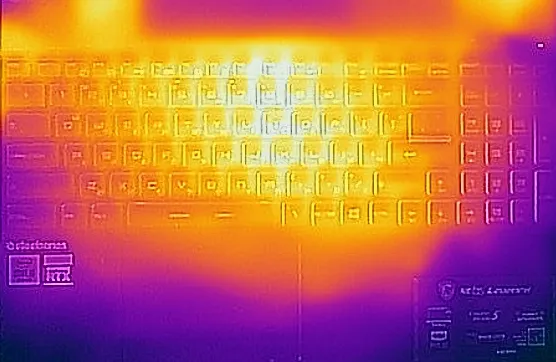

语言模型如ChatGPT需要大量计算资源才能有效运行,其中包括处理能力、内存和存储需求。这些模型的处理能力,内存和存储需求通常超出普通笔记本电脑的能力范围。训练和运行这些模型通常需要专业硬件,例如高性能GPU或专用硬件加速器。

这意味着要么改进模型以便可以在笔记本电脑上运行,要么改进硬件。这意味着我们需要TPU、GPU、数百吉字节的内存和数千兆字节的存储空间,如果想训练或修改预训练模型的话。如果你想运行现有的模型,你需要一台带有大量VRAM的GPU,这是大多数笔记本电脑目前没有的。虽然如此,还是有一些开源模型可以在本地运行,但代价是参数较少或响应较慢,所以并不是不可能做到。我认为GPT4All项目有潜力,并尝试过它。在质量和响应时间方面,它不如ChatGPT(甚至不如ChatGPT 3.5),但可能可以调整以提供更好的答案,适用于特定的用例,这可能就是你所需要的,你可以选择使用的模型,以平衡硬件要求和答案质量。

模型尺寸

高级语言模型,比如ChatGPT,有许多参数,往往达到数十亿个。这些模型需要占用大量磁盘空间,使得在存储和部署时面对个人计算机的存储容量限制非常困难。考虑到大多数消费电子产品都有数十GB的操作系统空间,甚至一TB(假设不升级硬件或添加另一个固态硬盘),您肯定会看到大部分的磁盘空间被语言模型占用,留给其他资源的空间就不多了。

推理速度

使用ChatGPT等语言模型生成响应可能非常耗时。尽管强大的硬件可以加速处理过程,但仍可能比实时交互慢。这可能会导致用户体验迟缓且不适用于交互应用程序。

当然,我们可以将组件升级为更强大的,但这将意味着与功率效率和热效率之间的权衡,这在下一节中进行讨论。

功率效率

大型语言模型需要大量的能源才能运转。笔记本电脑通常有限的电池寿命,而在离线情况下运行资源密集型模型会迅速耗尽电池。还记得我提到的GPU VRAM吗?嗯,如果你想要更快的响应速度,就需要使用更高功率的硬件,这意味着可携带性减弱,同时需要更强大的散热系统来处理增加的热量输出。

更新和维护

语言模型通常需要频繁更新和维护以纳入新知识、修复漏洞或增强性能。运行离线语言模型将需要一种机制来将模型与最新的改进保持同步,而没有可靠的互联网连接可能会带来挑战。

记得这些模型有多大吗?那么,您的网络必须有足够的带宽来获取更新,如果您有数据限制,那么您就倒霉了。

手机?

在现阶段,移动设备的处理能力仅有限,因为它们需要更高的能效比笔记本电脑更高。这些设备最多可以运行作为ChatGPT客户端的应用程序,但实际运行像GPT4这样的模型可能会很困难。那GPT4All呢?好吧,你至少需要8 GB的RAM,这对许多手机可能很困难。响应时间会如何呢?说实话,我不太乐观。

话虽如此,如果您想使用ChatGPT客户端,且您拥有一部iPhone手机,那么OpenAI发布的IOS应用程序可以供您使用。

结束思考

我的观点是电脑硬件的改进速度太慢了,在接下来的五年内,基于变压器的LLM(如GPT4)无法在个人电脑上本地运行。如果我们想改善这种情况,就需要使用不同的存储和运行模型的技术,这意味着可能要远离变压器,转向其他技术。我认为离线功能的需求已经被认识到了,所以这可能只是时间问题。尽管如此,我们需要数倍的改进才能使任何移动计算设备运行并产生高质量答案,而不需要大量能量的利用。