渴望权力:制造知识资本

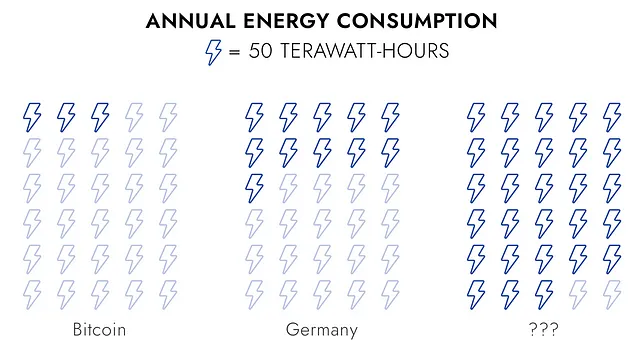

Certainly! Here’s the translation while keeping the HTML structure intact: ```html 一千四百万亿千瓦时(TWh)。这是一个巨大的能量数值。即使是人类有史以来最愚蠢的技术之一,工作量证明的加密货币,每年只消耗大约十分之一的能源。为了更好地理解1400 TWh,这相当于德国年度预算的三倍。 ```

```html

根据这些头条新闻,您可能会认为人工智能即将消耗如此多的能源。实际上,即使是对2030年人工智能能源需求的激进估计也低于200太瓦时——略超过比特币网络目前用于制造希望和梦想的能源。

```Here is the translation with the HTML structure kept intact: ```html What could possibly consume 1,400 TWh per year? 每年可能消耗 1,400 太瓦时的是什么? ```

Sure! Here's the translation with the HTML structure preserved: ```html That’s how much energy it takes to power our current stock of global intellectual capital. I’m talking about human brains. ``` ```html 这就是驱动我们当前全球智力资本所需的能量。我说的就是人类的大脑。 ```

人民的力量

每个人类大脑每天使用不到半千瓦时的电量。考虑到我们的能力,这是一个难以置信的数字。然而,任何数字乘以80亿都会变得庞大。

人类的智力资本是高效的,但并不是特别生产力。不到一半的人类参与劳动力市场,而那些参与的人每天只有几个小时是高效生产力。如果做个计算,只有大约1400太瓦小时中的约5% 生成了高效产出。

Here's the translation with the HTML structure preserved: ```html Assumptions: 全球人口 = 82亿 劳动力参与 = 35亿 (43%) 每年工作天数(平均) = 250天 (68%) 每天生产性工作小时数(估计) = 4小时 (17%) ```

```html

这个思维练习让我沉迷其中。人工智能的能效是高于还是低于人脑?制造知识资本是否是一种可行的商业模式?我们是否应该放慢人工智能的生产,直到模型更高效,且可再生能源更为普及?

```让我们深入了解数据。

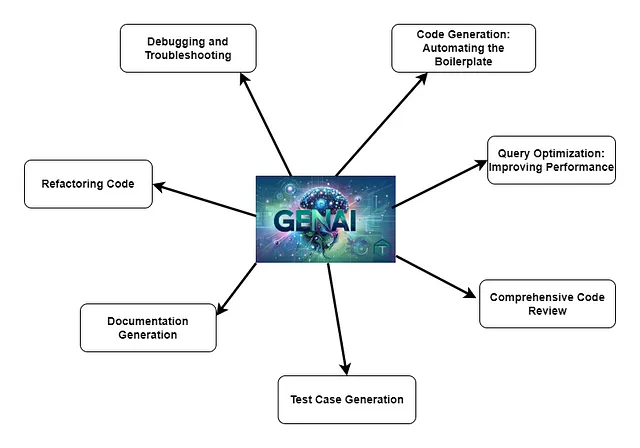

人工智能

Sure! Here is the translated text while keeping the HTML structure intact: ```html

人工智能模型被广泛认为是非常耗电的。公共数据有限,但据报道,GPT-3在训练中使用了1,287兆瓦小时的电力。训练需求与模型参数呈平方关系,因此GPT-4可能需要超过100,000兆瓦小时。这个数字高度推测,因此我们将GPT-3作为基准。

```人类在接受培训之前并不具备经济生产力。让一群三岁的孩子在办公室里到处跑可能很有趣,但他们不会完成太多工作。

对于这个比较,假设训练一个人要花费18年时间才能与GPT-3在类似任务上竞争(例如写作、推理)。利用我之前提到的数字,这意味着制造一个18岁人类大脑需要约3.2兆瓦时。

Sure! Here's the translation to Simplified Chinese while maintaining the HTML structure: ```html The implication is that GPT-3 required the same energy to train as four hundred human brains. That’s a large number, but it’s not ridiculous. I doubt four hundred humans could accurately memorize every pattern encoded in GPT-3’s 175 billion parameters. ``` Translated: ```html 这意味着 GPT-3 训练所需的能量相当于四百个人类大脑的能量。这个数字很大,但并不荒谬。我怀疑四百个人类能够准确地记住 GPT-3 的 1750 亿个参数中编码的每一个模式。 ```

为了好玩,让我们倒着计算一下。 GPT-3是在大约3000亿个token上接受训练的。使用保守的假设,需要大约400个人花费13年的时间来处理训练GPT-3所使用的token。

假设:GPT-3 训练令牌 = 3000亿 每个令牌的词数 = 0.75 人类阅读速度 = 每分钟250个词每天工作小时数 = 8人数 = 400(根据先前的计算)

GPT-3和四百名青少年一样有能力吗?你更愿意让谁在办公室工作?

我将毫不犹豫地承认这些计算是荒谬的。 你可以写一篇关于我的逻辑错误和简化假设的论文。 也就是说,我没有看到AI模型比人类大脑更需要能量的压倒性证据。 如果有的话,它们可能更少。

Here is the translation with the HTML structure preserved: ```html One Less Crisis ``` ```html 少一个危机 ```

Sure! Here’s the translated text while maintaining the HTML structure: ```html

让我们停止担心人工智能的能源消耗。如果我们在2030年将人工智能的能耗设定为200太瓦时,这意味着我们正在以惊人的速度制造和利用知识资本。如果人工智能的能力在那之前停滞不前,我相信我们会减缓模型训练并将资源转移到我们的旧技术——人力资本。

```

```html

我担心人工智能的安全性和劳动市场的扰动。您不需要极端假设或严格的计算来验证这些风险。您所需要的只是想象力和对以前技术如何颠覆社会的理解。能源是不同的。

```我们几千年来一直依赖人类的智慧来推动经济增长。这种模式变得日益不可持续。如果您关心将人类从贫困中解救出来,同时保护自然资源,您应该全力支持人工智能,并可能应避免加密货币。

注意:在讨论这篇文章时,一个朋友问及推理。人工智能在训练过程中可能与人脑竞争,但在执行任务时呢?我也进行了这些计算,结果类似。我的大脑用2.2瓦时生成了一封61字的电子邮件回复。根据我在网上找到的最佳假设,我估计ChatGPT用了2.8瓦时来生成它的60词回复。这个比例与我发现的训练比例大致相同,而且训练假设更为可靠。人工智能比人脑消耗更多电力,但时间要短得多。