Here’s the translation with the HTML structure kept intact: ```html Mamba LLMs : 注意力并非你所需要的全部 ```

变形金刚的替代品

“关注是你需要的一切”必须是人工智能领域中最好的创新,最终将我们引向ChatGPT和其他生成式人工智能研究。变压器使用“注意力机制”,使其能够专注于输入数据的不同部分,使其在翻译和文本生成等任务中高效。

Sure! Here's the translation with the HTML structure kept intact: ```html However, in 2023, a new architecture called Mamba was introduced, which has the potential to change the game once again. 然而,在2023年,推出了一种名为Mamba的新架构,它有可能再次改变游戏规则。 ```

Here is the translation with the HTML structure intact: ```html Mamba 不使用注意力机制 ```

Sure! Here’s the translation of the provided English text to simplified Chinese, while keeping the HTML structure intact: ```html

是的,您没有听错。Mamba 依赖于选择性状态空间模型(SSSM)。它顺序处理数据,在读取每个标记(如单词)时逐步更新其内部记忆。这使它能够更高效地处理较长的序列,而无需一次考虑所有内容。

```在我们继续之前

什么是SSM?

状态选择模型常常用于经济学、统计学和机器学习等领域,用于表示随时间演变的系统,其中模型的行为或预测取决于系统当前的“状态”。这里的“状态”一词指的是描述系统当前配置的一组变量。这些模型允许基于系统的状态进行选择性过程或转换,意味着根据状态不同的行为或规则适用于不同的状态。

在这种模型中,通常会有:

Here is the translation with the HTML structure preserved: ```html States: 这些是系统可以处于的不同状态或配置。 ```

```html 状态转移:系统可以随着时间的推移在状态之间演变或过渡,通常根据一套概率或确定性规则。 ```

状态相关行为:系统的行为取决于其所处的状态,这可能会影响决策、预测或结果。

```html 你听说过马尔可夫链吗?这只是一种状态空间模型(SSM)而已! ```

Sure! Here's the translation while keeping the HTML structure: ```html Example: 一个简单的天气模型 ```

假设你在模拟天气,它可以处于晴天或雨天两种状态中的一种。明天的天气取决于今天的天气,而状态之间的转变遵循概率规则。各状态及其之间的转变如下:

```html 1. 州: ```

Sunny: 用S表示

下雨: 用R代表

2. 转移概率:

如果今天是晴天,明天也有0.8的概率是晴天(有0.2的概率是下雨天)。

Here is the translation with the HTML structure maintained: ```html 如果今天是雨天,那么明天是雨天的概率为0.6(而阳光明媚的概率为0.4)。 ```

这些转移概率可以被捕捉在一个转移矩阵中。

In simplified Chinese, the translation of the text "( 0.8 0.2 0.4 0.6)" remains the same as it consists of numbers, which are universally understood. Here’s how it looks while keeping the HTML structure intact: ```html ( 0.8 0.2 0.4 0.6) ``` If you need to include any specific Chinese context or meaning related to these numbers, please provide that context, and I'd be happy to assist!

哪里:

第一行表示从晴天到晴天(0.8)和从晴天到雨天(0.2)的转换概率。

第二行表示从雨天到晴天的转换概率为0.4,从雨天到雨天的转换概率为0.6。

3. 初始状态分配:

Sure! Here is the translated text while keeping the HTML structure: ```html At the start, we need to specify the probability of being in each state. Suppose we know that: 在开始时,我们需要指定处于每种状态的概率。假设我们知道: ```

- 明天有50%的概率是晴天。

- 明天有50%的几率会下雨。

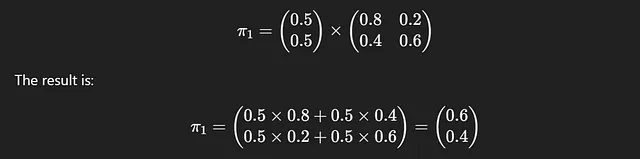

因此,初始状态分布是:π1 = (0.5 0.5)

```html 1. 一天后: ```

Sure! Could you confirm if you would like me to retain the specific formatting, or is there any special formatting you need?

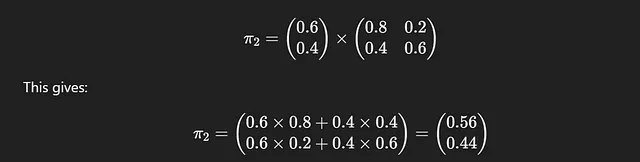

2. 两天后

预测两天后的天气,我们将一天后的状态分布再次乘以转移矩阵:

请注意,系统的行为是根据状态选择性的。如果今天是晴天,明天天气的概率(状态转换)将遵循一套规则。如果今天是下雨天,它们将遵循另一套规则。

这是一种状态选择模型的核心思想:系统的行为或转换取决于系统所处的状态。该模型根据系统处于哪种状态,有选择性地应用不同的规则或概率。

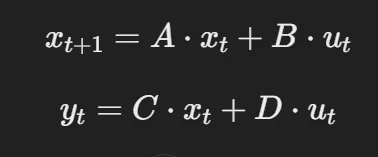

理解 A、B、C、D 矩陣

Here is the translation to Simplified Chinese, while keeping the HTML structure intact: ```html 在状态空间模型(SSM)的上下文中,ABCD 矩阵指的是一组用于表示系统状态及其随时间演化的矩阵。这些矩阵构成了动态系统线性状态空间表示的核心,通常写成以下形式: ```

在哪里:

xt 表示 t 时刻的状态向量。

ut表示在时间t的控制输入(通常在简化模型中不存在)。

yt是时间t的输出(观察)。

A,B,C,D是定义系统动力学的矩阵。

- 在时间t时的状态向量xt将表示在每个状态(晴天或雨天)中的概率。

- 转移矩阵P 定义了状态向量随时间的演变,但我们可以将其分解为组件A 和B,作为状态空间模型的一部分。

Sure! Here's the translation of your text into Simplified Chinese while maintaining the HTML structure: ```html Note: xt+1 与 yt 不同。xt+1 是“状态”向量,而 yt 是实际输出。 ```

在上述天气示例中,

A = 定义系统状态如何根据其当前状态从一个时间步骤演变到下一个时间步骤的状态转移矩阵。对于第一天的转移,A =

( 0.8 0.2 0.4 0.6)

Sure! Here's the translation while keeping the HTML structure: ```html B = 描述外部输入(控制或动作)如何影响状态演化的输入矩阵。由于没有外部影响,在此情况下它为 0。 ```

C = 将系统状态映射到观察输出的输出矩阵。就像上面的例子中一样,状态矩阵类似于输出矩阵,C是一个单位矩阵。

(1001)

D = 直接传输矩阵定义了外部输入如何直接影响输出,而不经过状态。由于D依赖于B,所以也为0。

Returning to Mamba … 回来Mamba...

为什么蛇精病胜过变形金刚?

- 序列建模:曼巴的设计旨在比变形金刚更高效地处理长序列数据。变形金刚由于复杂的注意力计算而在处理长文本时遇到困难,而曼巴可以处理大量信息而不会减速。

- 选择性焦点:斑马使用SSM来进行选择性聚焦。这意味着它可以根据接收到的输入动态调整焦点,使其能够优先处理重要信息,同时忽略不太相关的数据。例如,如果斑马正在阅读关于“彩虹”的故事,它可以根据上下文是科学的还是神话的,来聚焦于不同的方面。

- 效率: Mamba 在计算和内存使用方面更高效。 与通常需要大量资源处理长文本的变压器相比,Mamba 可以使用更少的计算资源处理更长的序列。

- Sure! Here's the translated text with the HTML structure preserved:

```html

硬件优化:Mamba 旨在与现代计算机硬件特别是 GPU 配合良好。这种优化使其在训练和推理过程中能够更快速、更高效地执行。

```

Here is the translation with the HTML structure intact: ```html The key distinction between Transformers and Mamba is Selective Focus. ``` Translated to Simplified Chinese: ```html 变形金刚和曼巴之间的关键区别是 选择性聚焦。 ```

SSMs 如何帮助曼巴进行选择性聚焦?

让我们通过示例了解SSM(状态机器)是如何为马姆巴工作的。

- 输入表示:当曼巴接收到输入,比如有关彩虹的故事时,它首先使用嵌入将文本转换为矢量表示。这些嵌入捕捉了文本的语义含义。

- Sure! Here is the translation in Simplified Chinese, while keeping the HTML structure: ```html Context Extraction: Mamba 通过分析周围的词语、句子结构或其他元数据来识别输入的上下文。 ```

例如:如果故事提到“光折射”,那么曼巴推测出一个科学背景。如果提到“一锅金币”,那么背景就变成了神话。这是通过上下文关注机制发生的,权重被分配给文本的各个部分,以确定相关性。

3. 动态焦点调整:使用SSM,蟒蛇调整其模型的内部状态,以优先考虑特定的焦点区域:

在科学背景下,该模型激活与物理学和光学相关的途径或参数(例如,光线、折射、色散)。

在神话背景下,该模型将焦点转向文化或民间知识。这种调整是通过选择性激活旨在处理特定任务或领域的状态空间区域而发生的。

4. 稀疏计算:仅激活模型的相关部分进行处理。这确保了计算的集中性,并避免浪费资源在不相关的数据上。

5. 输出生成:一旦应用了选择性关注,猛犸将生成与检测到的上下文相一致的响应或见解。

Sure! Here's the translation of your text into Simplified Chinese while keeping the HTML structure intact: ```html For science: “彩虹是由光在水滴中的折射和色散造成的。” ```

对于神话:根据爱尔兰的民间传说,彩虹通常被视为通往财富的路径。

6. 反馈循环: 如果新输入改变了上下文(例如,“这个故事以一名科学家解释彩虹为结束),Mamba会动态重新调整焦点,实时优化输出。

何时使用变压器

一般用途的应用程序:跨不同领域进行语言翻译、摘要和问答等任务。

丰富的上下文处理:当输入需要有效地捕获长程依赖时。

Sure! Here is the translated text in simplified Chinese, keeping the HTML structure: ```html Unstructured Data: 最适合处理没有明确结构的多样或模糊数据。 ```

```html

定制需求:易于针对特定任务进行微调或与其他架构结合。

```高计算资源可用:如果硬件和能源成本不是问题。

何时使用Mamba(基于SSM):

特定领域任务:当问题空间被明确定义,如技术文本、科学模型或重复性任务时。

资源限制:边缘设备或计算和能源有限的系统。

实时处理:需要低延迟和高效资源分配的场景。

稀疏数据相关性:仅对输入的部分重要部分进行关注,忽略无关数据可以提高效率。

动态环境:需要持续适应而无需重新培训的任务。

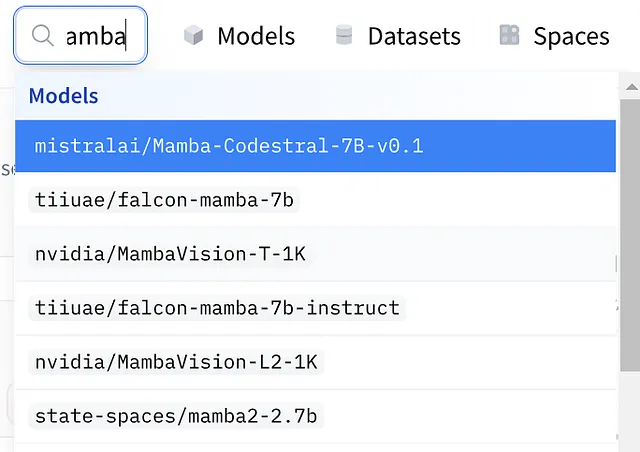

一些基于曼巴的LLM版本可以在HuggingFace上找到,并且可以轻松使用。这些模型的代码可以在这些模型的模型卡上找到。

```html

至此,我们将结束这篇较长的文章。看起来最终变压器和注意力机制迎来了一个值得的对手,它在变压器的延迟和内存限制方面进行了优化。

```希望你尝试一下曼巴模型!!