如何在 Langchain 中实现 Groq 嵌入

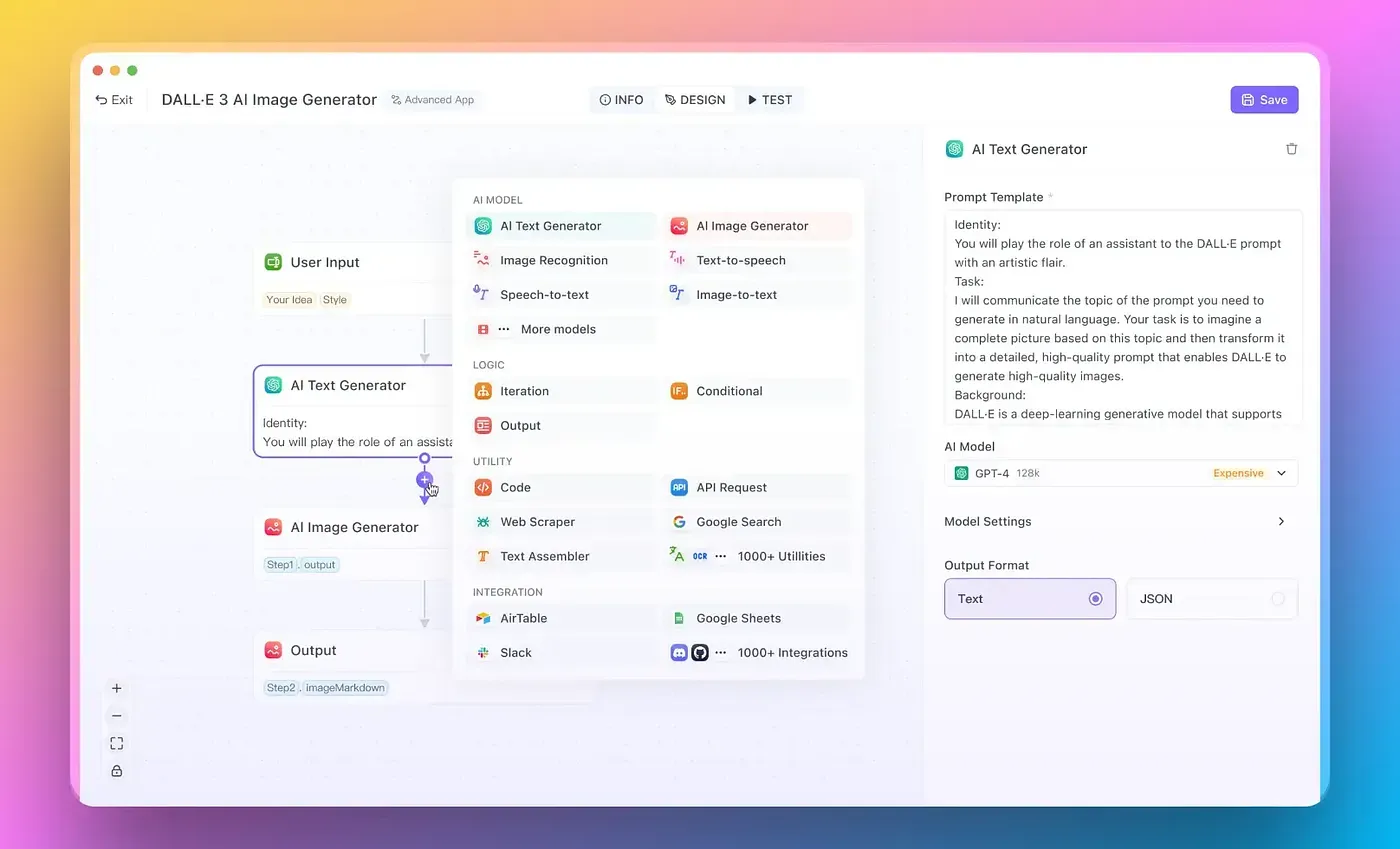

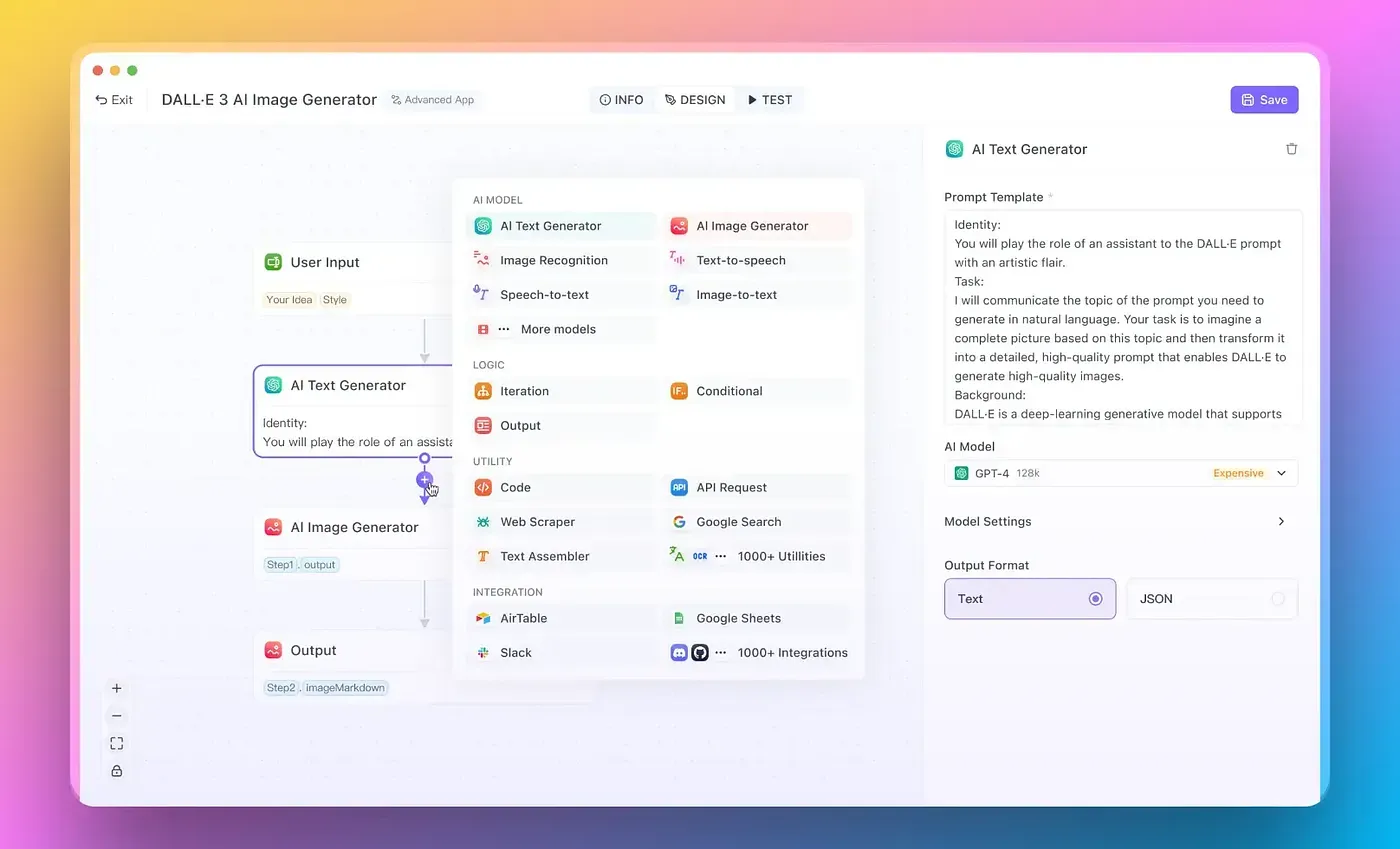

想创建由GPT-4o、Claude 3.5 Sonnet、Llama 3.1 405B、Google Gemini Pro等驱动的自动化AI代理吗?

那么,您绝对不能错过Anakin AI!您可以使用无代码工作流来自动化您的工作流程,为您提供定制的代理人工智能!

立即在这里查看👇👇

如何在LangChain中实现Groq嵌入:设置您的环境

在深入实施之前,必须要为有效使用 LangChain 和 Groq embeddings 设置环境。确保您已安装 Python — 最好是 Python 3.7 或更高版本。之后,您将需要安装必要的库。

步骤1:安装所需的库

打开你的终端或命令提示符,并执行以下命令:

pip install langchain

pip install openai

pip install requests

这将安装LangChain,OpenAI的语言模型和requests库,将有助于发起HTTP调用。

步骤2:准备您的API密钥

为了利用Groq嵌入,您将需要您的Groq API密钥。在继续之前,请确保您已设置账户并且手头有您的API密钥。按照以下方式配置API密钥环境变量:

export GROQ_API_KEY='YOUR_GROQ_API_KEY'

确保将'YOUR_GROQ_API_KEY'替换为您的实际密钥。

如何在LangChain中实现Groq嵌入:创建一个基本示例

现在您的环境已经准备就绪,让我们继续在LangChain中实现Groq嵌入的实际示例。这里的目标是创建一个简单的文本搜索应用程序,利用嵌入来高效地搜索文档。

步骤1:导入必要的库

开始导入项目所需的模块:

import os

from langchain.embeddings import GroqEmbeddings

from langchain.vectorstores import Chroma

from langchain.document_loaders import TextLoader

from langchain.chains import SimpleRetrieval

步骤2:初始化Groq Embeddings

您需要初始化嵌入类。 只需创建GroqEmbeddings的一个实例,并如下所示传递API密钥即可:

groq_embeddings = GroqEmbeddings(api_key=os.getenv('GROQ_API_KEY'))

现在,您已经准备好了您的Groq嵌入初始化。

步骤3:加载文件

使用嵌入进行搜索,您需要将一些文档加载到您的应用程序中。在这个例子中,让我们将一些简单的文本文件作为您的文档。

# Let's assume you have some .txt files in 'documents' directory

loader = TextLoader("documents/sample.txt")

documents = loader.load()

步骤4:创建一个向量存储器

现在,我们将使用Chroma(一个内存向量存储器)来存储您的文档的嵌入。

vector_store = Chroma.from_documents(documents, groq_embeddings)

这一步将您的文本数据转换为嵌入并将其存储在适合查询的格式中。

第五步:实现检索链

接下来,我们创建一个检索链,根据搜索查询获取相关文档。

retrieval_chain = SimpleRetrieval(vector_store)

这部分将允许您根据嵌入执行搜索操作。

步骤6:测试实施

让我们来测试我们的文本搜索应用程序。您可以运行下面的代码来搜索已加载的文档:

query = "What is LangChain?"

results = retrieval_chain.run(query)

for result in results:

print(result.page_content)

这段代码将打印出与您的查询最相关的文档内容。

如何在LangChain 中实现 Groq 嵌入:微调您的结果

虽然基本实现允许文档检索,但您可能希望微调您的 Groq 嵌入以提高搜索准确性和效率。以下是如何逐步进行的步骤。

步骤1:调整嵌入参数

您可以自定义Groq嵌入的参数来完善输出。例如,调整嵌入模型和其他属性可以提供更好的结果。

groq_embeddings = GroqEmbeddings(

api_key=os.getenv('GROQ_API_KEY'),

embedding_model='text-embedding-001',

model_version='v1'

)

第二步:实施查询预处理步骤

您可能希望对查询进行预处理,以提高检索结果的相关性。您可以实施简单文本预处理,如转换为小写或删除停用词。

def preprocess_query(query):

# Convert to lowercase and remove special characters

return ''.join(e for e in query if e.isalnum() or e.isspace()).lower()

query = preprocess_query("What is LangChain?")

步骤3:测量绩效

一旦你完善了你的实现和参数,衡量应用程序的表现就变得至关重要。以下代码片段有助于评估你模型的效果:

from time import time

start_time = time()

results = retrieval_chain.run(query)

end_time = time() - start_time

print(f"Query results retrieved in {end_time:.4f} seconds.")

这段代码将帮助您了解LangChain中Groq嵌入的效率。

如何在LangChain中实现Groq嵌入:与更大的数据集一起工作

如果您计划在LangChain中为一组更大的文档实施Groq嵌入,有几种策略可以采用来处理增加的复杂性。

步骤1:文档的批量处理

在处理更大的数据集时,一次性加载每个文档是低效的。相反,应该实现批处理:

def load_documents_in_batches(file_paths, batch_size):

for i in range(0, len(file_paths), batch_size):

yield file_paths[i:i + batch_size]

file_paths = ["documents/sample1.txt", "documents/sample2.txt", ...] # Add your file paths here

for batch in load_documents_in_batches(file_paths, batch_size=10):

batch_documents = [TextLoader(file).load() for file in batch]

vector_store.add_documents(batch_documents)

步骤2:使用分页功能查询结果

当结果数量很大时,请考虑实施分页以获得更好的用户体验。

def get_paginated_results(query, page=1, per_page=5):

results = retrieval_chain.run(query)

start_index = (page - 1) * per_page

return results[start_index:start_index + per_page]

results = get_paginated_results(query)

Step 3: 选择正确的向量商店

对于更大的数据集,您可能希望考虑持久的矢量存储选项,如PostgreSQL或ElasticSearch。这可以让您有效地管理更大规模的数据量。

from langchain.vectorstores import Postgres

# Initialize Postgres vector store

vector_store = Postgres(url='your_postgres_connection_string', embeddings=groq_embeddings)

如何在LangChain中实现Groq嵌入:与Web应用程序集成

您可能希望将您的LangChain应用程序与网络框架集成,以获得更好的交互体验。在本节中,我们将演示如何使用Flask来实现这一点。

第一步:建立Flask

确保您已经安装了Flask:

pip install Flask

步骤2:创建一个基本的Flask应用程序

创建一个名为app.py的新文件,并设置一个基本的Flask应用程序:

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/search', methods=['POST'])

def search():

query = request.json['query']

results = retrieval_chain.run(preprocess_query(query))

return jsonify(results=[result.page_content for result in results])

if __name__ == '__main__':

app.run(debug=True)

第三步:运行您的Flask应用程序

要运行该应用程序,请执行:

python app.py

您现在可以向您的/search端点发送POST请求,并根据Groq嵌入接收搜索结果。

curl -X POST -H "Content-Type: application/json" -d '{"query":"What is LangChain?"}' http://127.0.0.1:5000/search

通过遵循这个指南,您已成功将Groq嵌入到使用LangChain的网络应用程序中,使用户能够动态检索相关信息。

如何在LangChain 中实现 Groq 嵌入式:部署您的应用程序

一旦您的应用程序准备就绪,您可能希望将其部署以获得更广泛的访问权限。本节将介绍部署LangChain应用程序的关键步骤。

步骤1:选择一个托管平台

选择一个适合部署您的Flask应用程序的平台。Heroku 和 AWS Elastic Beanstalk 是值得考虑的优秀选择。

第二步:将您的应用程序容器化

为了更容易部署,建议使用Docker 将您的应用程序容器化。 创建一个如下的 Dockerfile:

FROM python:3.8-slim

WORKDIR /code

COPY requirements.txt .

RUN pip install -r requirements.txt

COPY . .

CMD ["python", "app.py"]

步骤三:构建和运行Docker容器

现在您可以构建和运行您的Docker容器:

docker build -t langchain-app .

docker run -p 5000:5000 langchain-app

第四步:部署到您选择的平台

根据您选择的托管平台的具体说明部署您的Docker应用程序。大多数平台将允许您推送您的Docker镜像并授权访问。

通过完成这些步骤,您将学会如何有效地部署使用Groq嵌入的LangChain应用程序。

如何在LangChain中实现Groq Embeddings:持续改进实践

为了确保您的应用程序随着时间的推移保持有效,采用持续改进的实践是至关重要的。以下是如何系统性地做到这一点。

步骤1:监控应用程序性能

实施日志记录和监控实践。 使用Prometheus或Grafana等工具观察API的使用情况和响应时间。

import logging

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

@app.route('/search', methods=['POST'])

def search():

query = request.json['query']

logger.info(f"Received query: {query}")

# Continue with search implementation...

第二步:收集用户反馈

创建渠道来收集用户对搜索结果的反馈。像点击率这样的数据点可以为返回结果的相关性提供宝贵的见解。

步骤3:实施定期模型更新

随着您收集更多的文件和查询,定期使用新数据对模型进行重新训练。强化您的嵌入模型的技能可以保持搜索体验的相关性。

第四步:探索新的嵌入策略。

保持更新,了解嵌入技术的新方法和改进。定期审查和迭代您的技术,随着您对用户需求的了解而调整它们。

实施这些实践可以确保您的LangChain应用程序始终稳健且用户友好。

想要创建由GPT-4o,Claude 3.5 Sonnet,Llama 3.1 405B,Google Geimini Pro等提供动力的自动化AI代理?

然后,您不容错过安纳金AI!您可以使用无代码工作流为自定义的代理AI自动化您的工作流程!

在这里检查一下👇👇