让我们放弃ChatGPT和Copilot —— 如何为保护隐私和安全安装您自己的LLM

抛弃云平台,拥有自己的 AI —了解如何设置自己的 LLM,享受无与伦比的隐私保护和个性化定制。

在当今的编码和内容创作世界中,像OpenAI的GPT、GitHub Copilot等基于云的平台变得非常流行。这些服务提供了代码补全、建议和生成等多种功能,使它们成为开发者的宝贵工具。然而,仅仅依赖于基于云的解决方案可能存在定制性、可伸缩性和——更重要的是——安全性方面的挑战。如果您担心无法控制您的数据并确保最大的隐私权,转向自托管的LLM可能是您需要的解决方案。本文将指导您通过设置本地安装Llama 3.1模型的过程,这是云端AI服务的强大替代品。

在MacBook Pro M3-Pro上进行测试

为什么选择Llama 3.1?

Llama 3.1 在AI领域脱颖而出,特别适合那些寻求开源、具有成本效益的替代方案,例如专有模型GPT-4。以下是为什么Llama 3.1 可能非常适合您:

- 开源:Llama 3.1 是开源的,这意味着您可以完全访问其代码库。这允许更大的定制和适应特定需求。

- 成本效益:与基于订阅的云服务不同,本地运行Llama 3.1可以显著降低长期成本,特别针对企业和开发者。

- 性能:Llama 3.1擅长数学推理,并支持多种语言,包括西班牙语,葡萄牙语,意大利语,德语,泰语,法语和印地语。这使它成为一种用于全球交流的多功能工具。

- 隐私和安全:在您自己的机器上托管Llama 3.1意味着您的数据留在您手中,减少泄露和未经授权访问的风险。

开始了解Llama 3.1

要在本地利用Llama 3.1的功能,您首先需要在您的设备上设置必要的工具和环境。以下是一个逐步指南,帮助您快速上手。

步骤1:安装Ollama

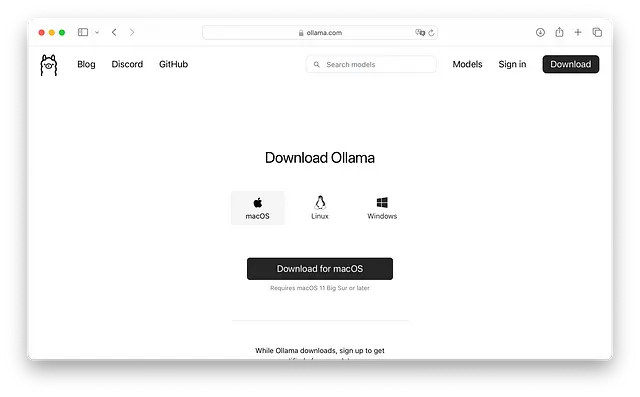

Ollama 是一个平台,通过它您可以下载并在本地运行像 Llama 3.1 这样的 LLM。以下是设置它的方法:

- 安装Docker:如果您还没有安装过,请先在您的MacBook上安装Docker。Docker允许您将应用程序容器化,使其更易于管理和部署。

- 下载Ollama:访问Ollama网站并按照提供的安装说明进行安装。安装完成后,您就可以开始进入下一步了。

步骤2:通过Ollama下载Llama 3.1

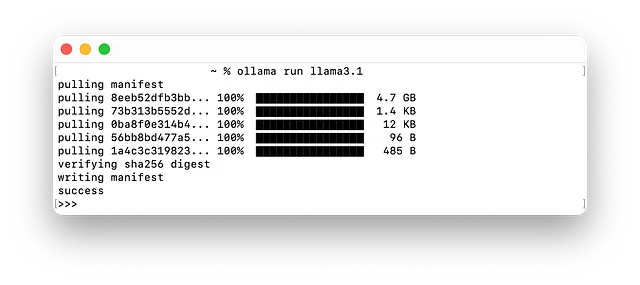

- 打开终端:在您的MacBook上打开终端。

- 运行以下命令:将以下命令复制粘贴到终端中,通过Ollama API下载Llama 3.1。

- 测试模型:下载完成后,您可以与模型进行交互。 输入您选择的“你好”句子以欢迎您的助手。

设置开放网络用户界面

要替换熟悉的ChatGPT界面,您需要设置Open Web UI,这是一个与您本地LLM进行交互的用户友好界面。

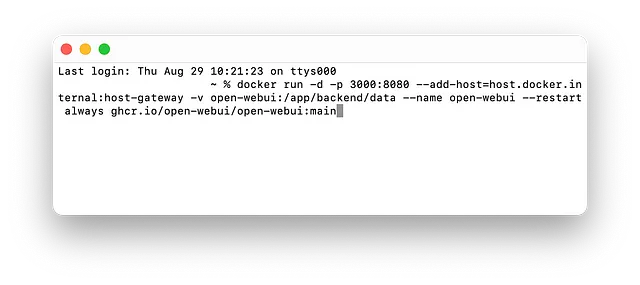

步骤1:安装 Open Web UI

- 运行安装:在Ollama已经安装的情况下,您可以按照官方文档直接下载并安装开放式Web用户界面。

- 启动应用程序:安装完成后,开放的Web用户界面将在本地端口3000上运行,因此请访问localhost:3000以显示Web应用程序。

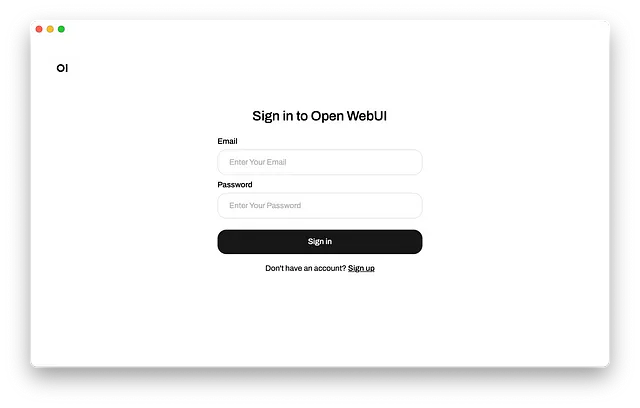

步骤2:访问开放的Web界面

- 访问本地主机:打开您的网络浏览器,然后进入本地主机:3000

- 注册您的帐户:由于Open Web UI设计用于在服务器上运行,它会要求您注册。请确保将您的凭据存储在安全的密码管理器中。

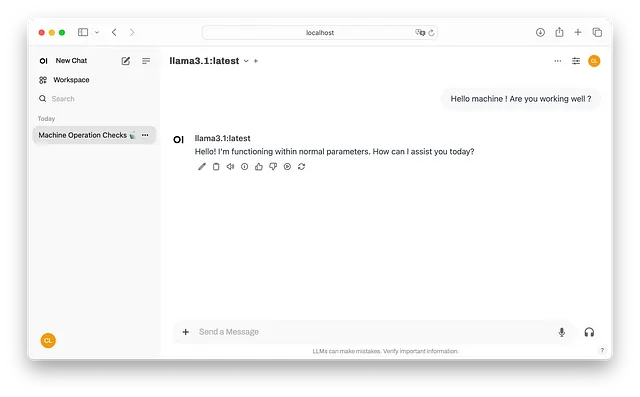

- 将默认模型设置为:从Ollama下拉菜单中选择Llama 3.1模型,并将其设为默认模型。这将在将来的会话中为您节省时间。

现在,您的MacBook上有一个完全功能的LLM!好极了!欢迎加入俱乐部!

与VSCode集成

随着时间的推移,GitHub Copilot 已被证明是开发人员的宝贵工具,但人们对其安全性和对知识产权的潜在风险提出了担忧。这些问题可能会使得优先考虑隐私的人觉得它不够理想。幸运的是,您可以通过将 Ollama 与您的 VS Code 界面集成来解决这些问题,我假设您已经安装了它。这样设置可以让您享受人工智能助手的好处,同时不会损害您的数据安全性。

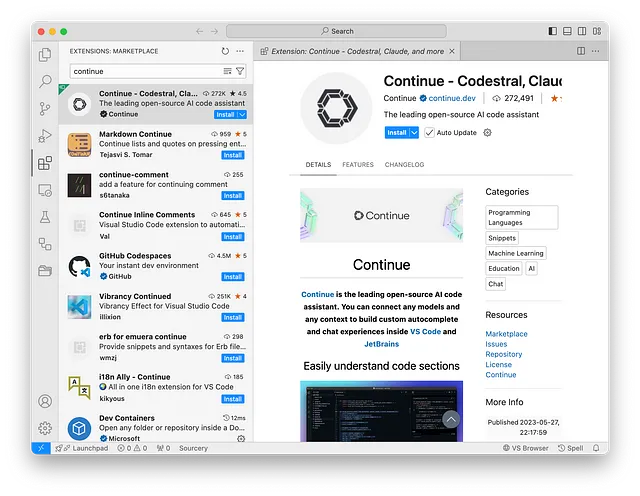

步骤1:安装“继续”插件

- 插件安装:打开 VS Code 并导航到扩展选项卡。搜索“Continue”插件并安装它。

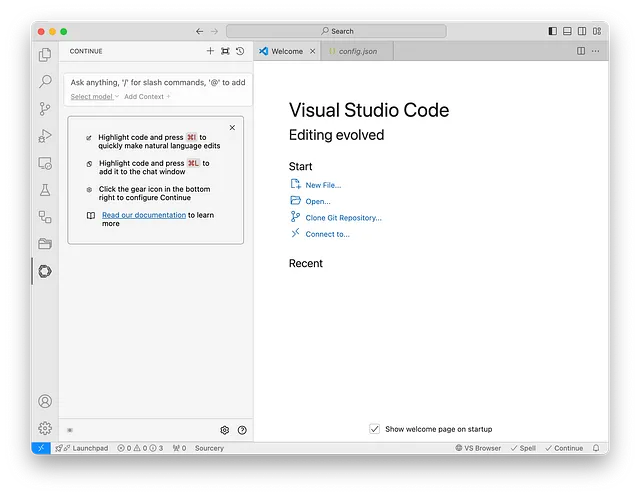

步骤2:配置插件

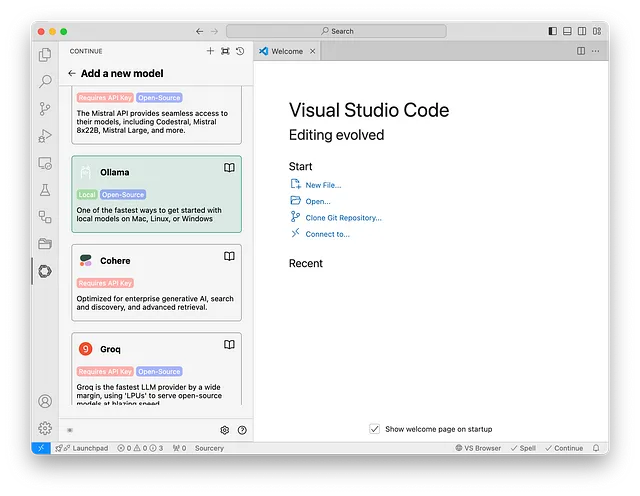

- 选择您的型号:安装完成后,打开“继续”插件。点击“选择型号”按钮。

- 选择Ollama:浏览列表并选择Ollama框。

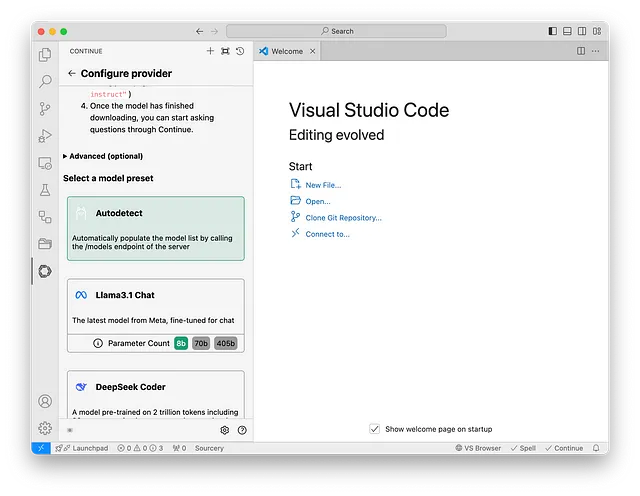

- 启用自动检测:此功能允许插件自动检测由Ollama下载的所有模型。

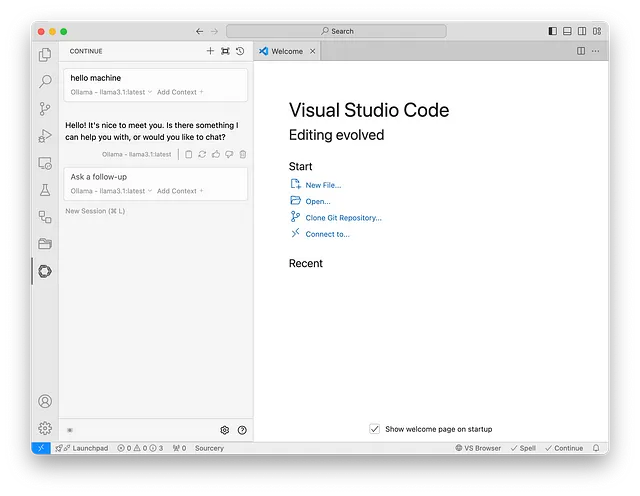

- 开始编码:您已准备就绪!您现在可以直接在VS Code中要求Llama 3.1为您提供帮助,就像您使用Copilot一样,但具有增强的隐私和安全性。

结论

通过在本地设置Llama 3.1,您已经在保护编码环境安全的同时,仍然受益于人工智能的强大功能迈出了重要的一步。无论您是一个担心数据隐私的开发者,还是只是寻找更可定制的解决方案,托管您自己的LLM是一个明智和前瞻性的选择。欢迎来到安全和私密人工智能的未来!

下次见,chloelavrat.com。