Sure, here is the translation: Prompt Engineering — 思维联想链

以下是系列文章的一部分:通过提示模式进行提示工程

Sure, here's the translated text in simplified Chinese, while keeping the HTML structure: ```html 您可以切换到本文的视频版本 ```

Sure, here's the translated text in simplified Chinese, maintaining the HTML structure: ```html

作为孩子,我们都有一个倾向,如果被问到一个复杂的问题,特别是如果我们觉得我们的答案可能是正确的,那么就会提供一个条件反射式的答案。毕竟,谁愿意费时去计算并思考解决方案,如果我们对自己的猜测相当有信心,觉得这可能是正确答案呢?值得一试对吧?

``` This HTML code will display the translated text in simplified Chinese.以下是 HTML 结构,翻译成简体中文的文本: ```

原来,LLM在这方面并没有太大的不同。

在我们的ChatGPT功能和提示工程系列中,我们多次遇到一个问题,那就是当涉及到数学、逻辑和推理类型的问题时,LLM至少在今天表现得很差劲。

它们会自信地生成完全错误的答案,甚至可能为这个错误的答案提供一个简短的解释。但那完全是错误的,就像一个孩子一样。

这是什么样的行为?LLM因为反复做这样的事情应该被送去留堂。

```html

人类和模型一样的问题在于,当涉及到数学和逻辑问题时,不通过猜测来节省时间往往是代价高昂的。人类和模型的第一本能是节省大脑和处理器的使用量,尤其是当感觉答案正确时就会尝试猜测答案。但是,就像你可能经历过的那样,老师们如果你只写答案而不写步骤或推理过程,就不会给你一个好分数。即使作为成年人,在面试中,会使用巧妙的问题来观察候选人的方法。Leetcode 上充满了这样的问题,猜测和草率得出结论只会让你失败。我最喜欢的之一是告诉模拟时钟在 3:15 时两只指针之间的角度。大多数人本能地会开始说是零度。但当被迫给出步骤或推理时,你的准确性会大幅提高(我希望如此)。事实证明,非常反直觉的是,对于大多数大型语言模型也是如此。

``````html

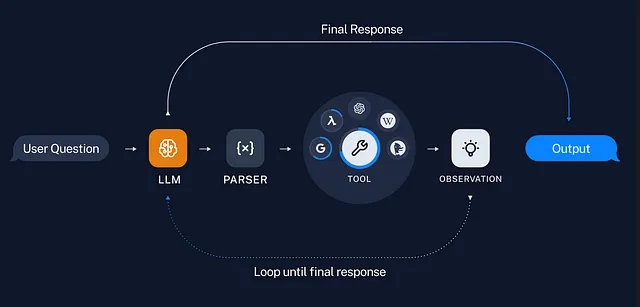

如果你想想的话,这是有道理的。LLM 是预测模型。它们只是试图提出对你提示最合理的回答。如果它们的训练包括与你提出的问题类似性质的问题,它们可能会首先尝试用它的答案来回答。不要指望一个LLM会努力想出对你查询最准确的回答,它会尽量提供最合理的答案。但意识到LLM的这种局限性会给你一些提示工程技术,以引导出更高质量的输出。有些在我们的提示模式系列中已经介绍过了。然而,可能这种类型问题中最好的是'思维链提示'。

```

```html

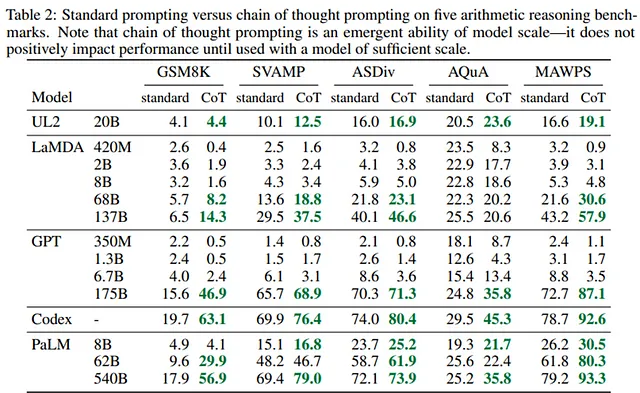

本文内容受到谷歌研究脑团队的一篇令人惊叹的论文的启发,该论文由Jason Wei和同事组成。我已经在下面提供了实际论文的链接,并强烈建议您阅读,因为我们显然不会详细讨论。本文试图简化该论文中的详细信息。论文中的一个重要教训是,这种技术相对于所涉及的模型大小是主观的。模型越大,这种技术就越有效,但仍然,在大多数情况下,该技术都有效,并且在大型模型中显示出明显的改进。论文末尾附近提供了各种LLMs的大量示例提示及其输出,您可以使用这些来提高此技术的技能。至于论文,就这些了,让我们继续思维链的提示。

```Here is the translation of the text you provided into simplified Chinese, keeping the HTML structure intact: ```html

研究论文: Chain-of-Thought Prompting Elicits Reasoning in Large Language Models,来自Google研究团队Jason Wei及其同事。

``` Translated text in Chinese: ```html研究论文:Chain-of-Thought Prompting Elicits Reasoning in Large Language Models,来自Google研究Brain团队的Jason Wei和他的同事。

```以下技术的主要思想是强迫LLM证明其输出是基于推理的,这样做会迫使它更多地处理你的问题,从而完善答案。这也使它通常将问题分解为连贯的中间组成步骤,特别是在必要时。请注意,这是一种完全颠倒的少数情况,我们在其中提供了解决问题的中间步骤的示例,而模型则跟随其后,而在这里,我们要求它提出或生成中间步骤。正如我们之前讨论的,模型总是试图减少处理的情况,而思维链的提示会迫使它处理你的答案,比默认情况下更多。正确的推理导致正确的答案,正确完成第1步会增加第2步正确的机会,依此类推。

```html

最简单的方法是手动将一个大数除以一个较小的数来可视化它。必须逐步进行,并且所有步骤都很重要以获得正确的答案。这只是一个基本示例,因为我们在这里讨论与此提示的工程技术相关的复杂逻辑和推理问题😊 对多个大型语言模型进行的实验表明,思维链提示可以提高在一系列算术、常识和符号推理任务上的表现。它适用于任何人类可以通过语言解决的任务。实证收益可能非常显著。

``````html

我们可以认为思维链提示是在强迫模型过度思考吗?在某些情况下,是的,它可能已经在没有思维链提示的情况下正确地作出了反应。但是在它应该做出反应而没有做出反应的情况下呢?当它应该做出‘思考’或‘推理’时,你如何知道它是否做出了反应?没有明显的红线,因此对于任何复杂的问题,如果没有思维链提示,某人就必须做出努力来核实答案,所以要么是你,要么是模型在思考。如果你愿意这样做,你可以让模型摆脱困境。否则,思维链提示就是你的朋友 😊

```Sure, here is the translated text in simplified Chinese, keeping the HTML structure: ```html

另一个重要的方面是,思维链提示提供了一个可解释的窗口进入模型的行为,暗示了它可能是如何得出特定答案的,并提供了调试的机会,找出推理路径出错的地方(尽管完全描述支持答案的模型计算仍然是一个未解之谜)。您可以识别和更改提示/问题,或添加进一步的细节以减少混淆的可能性,并将模型引导到正确的答案。至少你有一次机会。

```Sure, here's the translated text in simplified Chinese: ```html

这项技术可以与我们在此系列早期文章中介绍过的少量示例提示技术有效结合,您在其中给出一些示例并在答案中提供详细的推理。这些示例与明确的指示相结合,以理性化输出,会产生详细且希望更准确的答案。仅仅几个提示问题和答案可能导致比我们的示例涉及推理部分时更多的错误答案,我们在其中为答案提供推理。答案实际上可能会改变,希望是更好的 😊

```Sure, here is the translated text in simplified Chinese within the HTML structure: ```html 让我们现在来看一些例子,首先是错误的例子。我列出了多个类别中的一个错误,所以对于字体较小的情况,我道歉。为了节省时间,我不会逐个例子进行讲解,但你可以暂停一下,看看,或者更好的方法是在下面的论文链接中找到更多例子,详细说明了错误和错误推理的完整细节。 ```

以下是对这类问题LLM(Large Language Models)通常会出现的大多数错误进行了广义上的分类。这些错误可以分为三类:计算器错误、语义理解错误和漏步错误。计算器错误是由于计算不正确而产生的简单错误。您可以看到第一个例子,一个非常简单的乘法出现了错误,计算结果不是600,而是300。研究表明,在思维链提示中,有8%的情况除了这种类型的错误外都是正确的。另一类是语义理解或符号映射类的错误,即模型产生了理解或映射错误。最后是漏步错误,即正确解决问题所需的步骤中有一些步骤缺失。这是研究中错误的最大贡献者,占比为22%,而计算器错误占比为8%,符号映射错误占比为16%。

Sure, here is the translation: ```html

```html

Q: Roger has 5 tennis balls. He buys 2 more cans of tennis balls. Each can has 3 tennis balls. How many tennis balls does he have now? A: Roger started with 5 balls. 2 cans of 3 tennis balls each is 6 tennis balls. 5 + 6 = 11. The answer is 11.

Q: The cafeteria had 23 apples. If they used 20 to make lunch and bought 6 more, how many apples do they have?

``` ```html问题:罗杰有5个网球。他再买了2罐网球。每罐有3个网球。现在他有多少个网球?答案:罗杰一开始有5个网球。每罐3个网球的2罐是6个网球。5 + 6 = 11。答案是11。

问题:自助餐厅有23个苹果。如果他们用了20个做午餐,并再买了6个,他们现在有多少苹果?

``````html

A:食堂原本有 23 个苹果。他们用了 20 个做午餐。所以他们剩下 23 - 20 = 3 个。他们又买了 6 个苹果,所以他们现在有 3 + 6 = 9 个。答案是 9。

```Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html 为什么会发生这种情况?在解决复杂的推理任务,比如多步骤的数学问题时,考虑自己的思维过程是很重要的。通常会将问题分解成中间步骤,并在给出最终答案之前解决每一个步骤。强迫模型生成类似的思维链,使其更深入地探索,因为它必须为每一步推理出解释。 ```

Sure, here is the translated text in simplified Chinese while keeping the HTML structure: ```html 请再次注意,对于较小的大型语言模型,思维链激活并不能提供最佳结果,并且在参数为100B及以上的模型中表现最佳。尽管较小的模型能够流畅生成思维链,但可能是不合逻辑的,导致错误和不准确的答案。 ``` This text is now translated to simplified Chinese and can be used directly in your HTML structure.

简而言之,研究的两个主要结论是,虽然这种技术适用于任何文本到文本的任务,但它在需要复杂多步推理和使用大型语言模型的任务中效果最佳。对于仅需要单个或两个步骤的问题,即使使用较小的模型,性能也相当不错,使用这种技术会过度,带来的额外好处微乎其微。

在论文中只选择一个例子。

问题:特蕾西在花园里用一段4英尺长的金属线来支撑番茄植物。这根金属线被切成了6英寸长的小段。她一共得到了多少小段?

在具有62B参数的模型的回答

Sure, here's the translation: ```html 她把电线剪成了6英寸长的小段。这意味着她得到了4 * 6 = 24块。答案是24。(错误:语义理解错误) ```

将英文文本翻译成简体中文,保持 HTML 结构: ```html

模型答案为 520B 参数

```Sure, here's the translated text in simplified Chinese within the HTML structure: ```html

这根导线长4英尺。这意味着它长48英寸(4 * 12 = 48)。它被切成了6英寸长的小段。这意味着她得到了48 / 6 = 8段。答案是8。(正确)

```在论文中还有许多其他例子。

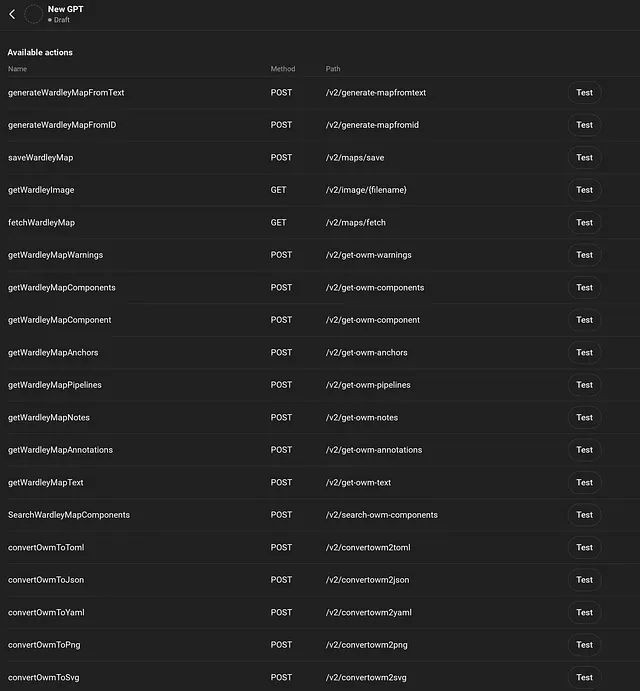

在研究中展示了一个结果幻灯片,其中对各种大型语言模型及其大小变体进行了基准测试。带回家的是,对于需要两个以上中间步骤的问题,最好使用较大变体的大型语言模型。

Sure, here's the translation: ```html 阅读文章末尾以获取大量思维链提示的示例。 ```

Sure, here's the translated text in simplified Chinese: ```html 这就是思维链提示工程技术的全部内容。如果你喜欢,请鼓掌并分享。你也可以考虑订阅我们的YouTube频道。谢谢!!! ``` Just copy and paste it into your HTML structure!