Sure, here's the translated text in simplified Chinese:

```html

AI中的专家混合模型(MOE):是什么以及如何工作?

```

Sure, the translation of "Introduction" into simplified Chinese while keeping HTML structure would be:

```html

介绍

```

Sure, here's the translated text: ```html 你是否曾经想过像GPT-4这样的语言模型如何能够产生如此准确和引人入胜的文本? 这种神奇通常来自一个称为“专家混合”(MoE)的巧妙技巧。 想象一下,就像有一支顶尖专家团队,每个人都有自己的超能力,当需要他们特定的技能时随时可以投入使用。 这基本上就是MoE在人工智能中的工作原理。 ```

Sure, here's the translated text: ```html 在本文中,我们将解析MOE的工作原理,以及它为何改变了游戏规则,以及对人工智能的现在和未来意味着什么。 ```

Sure, here's the translation: 专家混合模型概念

```html 想象一下,你正在举办一个晚宴,你有一群朋友都是出色的厨师,但每个人都有自己独特的专长。简是一个出色的烘焙师,迈克做出最棒的意大利面,莎拉是烧烤大师。与其让每个人都做每道菜,你让简负责甜点,迈克做意大利面,莎拉烤烧烤。这样,你可以得到最美味的一餐,因为每个人都专注于自己擅长的领域。 ```

在人工智能中,专家混合(MoE)概念的工作方式类似。与其让一个庞大的模型试图处理所有事情不同,MoE使用一堆更小、更专业的模型,也就是“专家”。每个专家都非常擅长特定的任务。当问题出现时,系统决定需要哪些专家,并让它们投入工作。

Sure, here's the translation in simplified Chinese: ```html

因此,就像我们的晚宴上,每道菜的最佳厨师上场一样,MoE激活了AI模型的最佳部分来完成手头的任务。这不仅使系统更加高效,还确保您在每个具体任务中获得最佳表现。这是一种聪明的方式,可以在不浪费资源的情况下充分利用系统。

```技术解释:混合专家(MoE)的工作原理

Sure, here is the translated text in simplified Chinese while keeping the HTML structure: ```html

混合专家(MoE)模型

混合专家(MoE)模型是一种神经网络架构,旨在增强大型模型的性能和效率。以下是MoE工作原理的技术解析:

Sure, here's the translation of "Architecture Overview" into simplified Chinese while keeping the HTML structure:

```html

架构概述

```

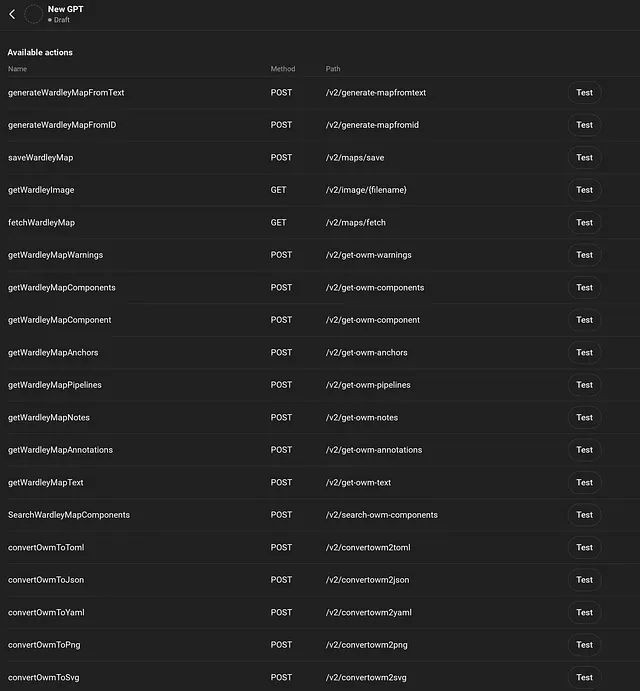

Sure, here's the translation: ```html 多个专家模型:MoE 系统由几个较小的子模型组成,称为专家。每个专家都专门负责数据的不同方面或不同类型的任务。 ```

Sure, here's the translated text in simplified Chinese, while keeping the HTML structure: ```html

门控网络:门控网络决定对于给定输入激活哪些专家。门控网络是一个较小的神经网络,接收输入数据并输出对专家的概率分布。

```Sure, here's how you can write "Workflow" in simplified Chinese while keeping the HTML structure intact: ```html 工作流程 ``` This HTML code uses the `` tag to mark the text and the `lang` attribute to specify the language as simplified Chinese (`zh-CN`).

Sure, here's the HTML structure with the translated text in Simplified Chinese: ```html

输入数据:当系统接收到输入数据时,首先通过门控网络传递此数据。

Sure, here is the translated text in simplified Chinese while keeping the HTML structure: ```html 2. 门控网络决策:门控网络分析输入并生成一组权重或概率。这些权重决定了应该激活哪些专家。通常,每个输入只激活一小部分专家,使得该过程高效。 ```

Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html

- 专家激活:基于门控网络的权重,选择的专家被激活。每个专家处理输入数据并生成输出。

Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html 4. 聚合:激活的专家输出通常通过门控网络的概率加权和进行组合。这个聚合输出是 MoE 系统的最终结果。 ```

训练多输出模型

训练一个MoE模型涉及更新专家和门控网络。该过程通常遵循以下步骤:

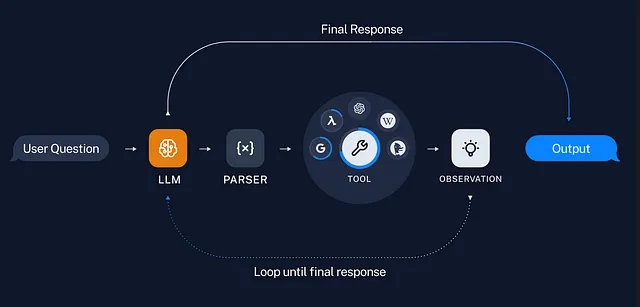

Sure, here is the translated text in simplified Chinese: ```html 1. 前向传播:对于每个训练样本,输入通过门控网络传递,以确定激活哪些专家。 ```

Sure, here's the translation: 2. 专家选择:选定的专家处理输入并生成他们的输出。

Sure, here is the translated text in simplified Chinese: 3. 损失计算:将合并输出与目标输出进行比较以计算损失。

Sure, here's the translated text in simplified Chinese: 4. 反向传播:根据损失计算梯度,并使用反向传播更新门控网络和专家的权重。

Sure, here is the translated text in simplified Chinese while keeping the HTML structure: ```html

在专家混合(MoE)中的负载均衡

```Sure, here's the translation in simplified Chinese while keeping the HTML structure: ```html

负载平衡是混合专家(MoE)模型的关键方面。 它确保模型中的所有专家得到有效利用,防止任何一个专家负载过重,而其他专家则被低效利用。

```Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html 为什么负载均衡很重要? ```

Sure, here's the translated text in simplified Chinese, while keeping the HTML structure: ```html

效率:适当的负载平衡有助于充分利用计算资源。如果一些专家被低效利用,会导致效率低下和资源浪费。

```Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html

可扩展性:

随着模型规模的增长,保持平衡的工作负载确保系统保持高效和响应迅速。没有负载平衡,添加更多专家可能会导致收益递减。

```Sure, here's the translated text in simplified Chinese: ```html 4. 模型寿命:过度使用模型的某些部分,而其他部分被低效利用,可能导致运行这些专家的硬件更快地磨损,潜在地缩短基础设施的寿命。 ```

Sure, here is the text translated into simplified Chinese while keeping the HTML structure:

```html

如何在MoE中实现负载均衡

负载均衡是一种关键的技术,用于在MoE中平衡工作负载,确保系统高效稳定地运行。它通过分配请求到多个服务器上,以减轻单个服务器的压力。

在MoE中,负载均衡工作原理如下:

- 当用户发送请求时,负载均衡器接收并分析这些请求。

- 然后,它根据预设的算法将请求分发到可用的服务器上。

- 每个服务器处理其分配的请求,并将结果返回给用户。

这种方式可以确保系统资源被充分利用,同时提高了系统的可靠性和性能。

```Sure, here's the translated text in simplified Chinese: ```html

门控网络的作用:门控网络负责决定对于给定的输入激活哪些专家。它输出专家之间的概率分布,指示每个专家应该对处理输入贡献多少。

```Sure, here's the translation: ```html

软门控:在一些实现中,根据门控网络的输出概率,多个专家以不同程度被激活。这允许每个专家做出更细致的贡献。

```Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html

- 硬门控:在其他实现中,根据门控网络的概率选择固定数量的顶级专家进行激活。这种方法可以简化负载平衡,但可能需要更仔细的调整以避免瓶颈。

Sure, here's the translated text in simplified Chinese, keeping the HTML structure intact: ```html 2. 正则化技术:可以应用各种正则化技术来鼓励专家的平衡使用。其中包括: ```

Sure, here's the translated text in simplified Chinese: ```html

- 负载均衡损失:在损失函数中添加一个惩罚项,以阻止门控网络过度依赖于少量专家。该损失函数鼓励更均匀的激活概率。

Certainly! Here's the text translated into simplified Chinese while keeping the HTML structure intact: ```html

- 熵正则化:鼓励门控网络输出中的更高熵,以确保随时间选择更多样化的专家集合。

Certainly! Here's the translation of the text into simplified Chinese, maintaining the HTML structure: ```html 3. Capacity Constraints: 在每位专家可以处理的最大能力或负载上施加限制。这迫使门控网络更均匀地分配负载。 ``` This HTML structure ensures the translation is correctly formatted and can be directly used in a web page.

动态路由:根据专家当前的负载和性能调整输入的路由。如果一个专家负载过重,门控网络可以被训练来重新将部分输入路由到负载较轻的专家。

Sure, here's the translation in simplified Chinese: ```html

在混合专家(MoE)模型中,专家学到了什么?

```Sure, here's the translation in simplified Chinese, keeping the HTML structure: ```html

在专家混合(MoE)模型中,每个专家是一个专门处理输入数据特定方面的神经网络。以下是专家学习内容的简要说明:

``` Just insert this code into your HTML document, and it will display the translated text in simplified Chinese.Sure, here's the translation: 1. 专业功能

Sure, here's the translated text in simplified Chinese, maintaining the HTML structure: ```html

专注的表征:专家学习如何表示与其任务相关的数据中的特定特征或模式。例如,在自然语言处理中,一个专家可能专注于句法,而另一个专注于语义。

```Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html

领域知识:专家可以专注于不同的领域。例如,一个专家可能处理医学术语,而另一个专注于法律用语。

```Sure, here's the translation: ```html

任务特定技能

```• 专业领域:专家在特定任务或子任务中积累专业知识,如情感分析或命名实体识别。

Sure, here is the translation in simplified Chinese while keeping the HTML structure: ```html

优化参数:专家的参数在训练过程中进行微调,以优化其在专业任务上的性能。

```Sure, here's the translation: ```html

自适应处理

```动态适应:专家根据门控网络的决策调整处理输入,确保在各种输入情况下性能高效。

Sure, here's the translation in simplified Chinese: ```html

高效推理:专家通过专注于较窄的范围来优化计算,从而提供更快、更准确的结果。

```Sure, here's the translation in simplified Chinese while keeping the HTML structure: ```html

4. 变异的强健性

```Sure, here is the text translated into simplified Chinese while keeping the HTML structure: ```html

处理变异性:专家学会在其专业领域内管理数据的变异性,处理不同的变化、噪音和异常情况。

```Sure, here's the translation in simplified Chinese: ```html

范围内的概括:专家在其领域内进行概括,将所学知识有效地应用于新的、未见过的例子。

```优点混合专家(MoE)

Sure, here's the translated text in simplified Chinese: ```html

混合专家(MoE)模型提供了几个重要优势,使其成为构建大规模、高效率和高性能神经网络的吸引人方法。以下是这些优势的更详细介绍:

Sure, here's the translated text in simplified Chinese while maintaining the HTML structure: ```html 效率 ```

Sure, here's the translation: ```html

选择性激活:MoE 的主要优势之一是它仅对每个输入激活一部分专家。这种选择性激活大大减少了所需计算量,与传统模型相比,传统模型在每个输入中使用所有参数。因此,整体计算成本显着降低。

Sure, here is the translated text in simplified Chinese while keeping the HTML structure: ```html

减少资源消耗:通过不为每个任务使用整个模型,MoE 节省了内存和处理能力,从而更有效地利用硬件资源。这对于大规模部署特别有益,因为计算资源可能成为瓶颈。

```Sure, here's the translation: ```html

专业化

```Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html

专家优化:MoE 中的每个专家都可以接受培训,专注于数据的不同方面或不同类型的任务。这意味着当门控网络选择一个专家时,它正在选择最合格的“专家”来完成工作,从而提高各种输入的性能。

```Sure, here's the translated text in simplified Chinese, while keeping the HTML structure intact: ```html

改善准确性:专业化使每个专家都可以调整其参数,以在其特定领域表现卓越,从而增强了MoE模型的整体准确性和性能。这类似于拥有一支高技能专业人员团队,每个人都为更有效地解决问题贡献自己的专业知识。

```Sure, here is the translated text: 3. 可扩展性

Sure, here's the translated text: ```html

- 模块化增长:通过增加更多专家而不会成比例地增加每次推断的计算成本,MoE模型可以被扩展。这种模块化方法使模型能够增长并处理更复杂的任务,而不会变得笨重。

Sure, here's the translated text: ```html 处理各种任务:随着专家数量的增加,系统可以涵盖更广泛的任务和数据类型。每位新专家都可以带来一项新的专长,使MoE模型更加灵活多样,并能够高效处理更广泛的输入。 ```

Sure, here is the translated text in simplified Chinese, keeping the HTML structure intact: ```html

4. 增强性能

```Sure, here's the translated text: ```html

- 动态适应性:门控网络根据输入动态选择最合适的专家,使 MoE 模型能够实时适应不同的场景。这导致在各种任务中保持高性能。

Sure, here's the translation of the text you provided into simplified Chinese while keeping the HTML structure: ```html 减少过拟合:通过将任务分配给专业的专家,减少了任何单个模型过拟合的风险。每个专家专注于数据的较窄方面,这可以导致更好的泛化和在未见数据上的性能。 ```

Sure, here's the translation: ```html 5. 灵活性 ```

Sure, here is the translated text in simplified Chinese: • 量身定制的培训:每个专家都可以独立培训或在特定数据子集上进行微调,从而实现更加个性化和高效的培训过程。这种灵活性意味着可以更新或替换专家,而无需重新训练整个模型。

Sure, here's the translated text in simplified Chinese, keeping the HTML structure intact: ```html

自适应复杂性:通过改变专家数量或门控网络使用的标准,MoE模型的复杂性可以进行调整。这使得MoE成为一个灵活的解决方案,可以针对不同的性能和资源约束进行优化。

Sure, here's the translated text: ``` 专家混合(MoE)的挑战和缺点 ```

```html

尽管专家混合(MoE)模型具有显著的优势,但它也带来了一些挑战和缺点,需加以解决:

```在保持 HTML 结构的情况下,将英文文本“Load Balancing”翻译为简体中文。

在使用不均衡: 确保所有专家得到有效利用可能会很困难。一些专家可能被过度使用,而其他专家则未被充分利用,导致效率低下和潜在的性能瓶颈。

Sure, here is the translated text in simplified Chinese: ```html

复杂正则化:通过添加惩罚或约束等技术来平衡负载,可以增加模型和训练过程的复杂性。

```2. 网络复杂性的门控

Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html

- 可扩展性问题:随着专家数量的增加,门控网络变得更加复杂,训练效率更低。这可能导致模型管理和优化方面的困难。

在培训过程中保持稳定性:确保门控网络在培训期间保持稳定和准确可能具有挑战性,特别是当模型扩展时。

Sure, here's the translated text in simplified Chinese: ``` 3. 计算开销 ```

增加的复杂性:MoE模型的整体架构比传统模型更复杂,需要谨慎设计和实施。

Sure, here is the translation: ```html • 资源密集型:训练多个专家和一个门控网络可能需要大量的计算资源和基础设施。 ```

Sure, here's the translation in simplified Chinese, keeping the HTML structure: ```html

4. 数据和任务分割

```Sure, here is the translated text in simplified Chinese, while maintaining the HTML structure: ```html

- 有效的分割:

- 在有意义的方式上将任务和数据分配给专家是具有挑战性的。

- 糟糕的分割可能导致性能不佳和专家的低效使用。

Sure, here's the translation in simplified Chinese: ```html

专家特长:确保每位专家都能够发展出有意义的专长,而且不与其他人重叠太多,需要仔细设计和培训。

Sure, here is the translation in simplified Chinese: ```html 5. 维护和更新 ```

Sure, here's the translated text in simplified Chinese, while maintaining the HTML structure: ```html

复杂维护:与单一的、整体模型相比,管理和更新多个专家和门控网络可能会更加繁琐。

```Sure, here's the translated text in simplified Chinese while maintaining the HTML structure: ```html

持续学习:调整MoE模型以适应新数据或任务可能需要持续重新训练专家和门控网络,增加维护工作。

```Sure, here is the translation in simplified Chinese while maintaining the HTML structure: ```html

6. 可解释性

```Sure, here's the translated text in simplified Chinese while maintaining the HTML structure: ```html

黑匣子性质:虽然单个专家的解释可能更容易理解,但整体而言,MoE系统可以被视为黑匣子,这使得理解和解释决策过程变得困难。

```Sure, here's the translated text in simplified Chinese: ```html • 复杂的交互:门控网络和专家之间的交互可能很复杂,这使得诊断问题和理解模型行为变得具有挑战性。 ```

Certainly! Here's the translation of "7. Overhead in Deployment" into simplified Chinese while keeping the HTML structure: ```html 7. 部署开销 ``` In this HTML snippet: - `部署开销` translates to "Deployment Overhead" in simplified Chinese.

Sure, here's the translated text in simplified Chinese while keeping the HTML structure intact: ```html

基础设施要求:部署MoE模型可能对基础设施要求更高,因为它可能需要支持动态专家选择和输入的高效路由。

```Sure, here's the translated text: ```html

延迟问题:由于选择和汇总专家输出所涉及的额外计算,实时应用可能会面临延迟问题。

```Sure, here's the translation while keeping the HTML structure: ```html 结论: ```

Sure, here's the translated text in simplified Chinese: ```html

深度学习中的混合专家(MoE)之旅才刚刚开始,还有许多里程碑有待达成。然而,它彻底改变我们对深度学习模型的方法的潜力是巨大的。鉴于当前硬件发展的速度,我们更可能看到建模技术的快速改进,而不是硬件。通过利用MoE的优势 - 将复杂任务分解为由专业专家处理的较简单的子任务 - 我们可以继续推动深度学习可以实现的极限。这对未来来说是令人兴奋的前景。

```