Sure, here's the translation: 使用提示结构会提高输出质量吗?使用GPT-4、Claude 3和Gemini 1.5进行零射击提示测试

Sure, here's your text translated into simplified Chinese, while keeping the HTML structure intact: ```html

您是否已经通过多次迭代,通过优化和批评最初的版本,掌握了从ChatGPT获取高质量文本的方法?如果您需要重复解决类似的任务,却没有时间阅读大量版本并对其进行批评呢?如果您想与尚未有效“引导” AI 的同事分享您的提示呢?

``` Let me know if you need anything else!Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html

让我们探索如何在上述情况下为大型语言模型(LLMs)创建说明:

```- 如何撰写不需要后续澄清的提示。

- Sure, here's the translated text in simplified Chinese while maintaining the HTML structure: ```html 如何花更少时间在那件事上。 ```

Sure, here's the translated text in simplified Chinese, while keeping the HTML structure: ```html

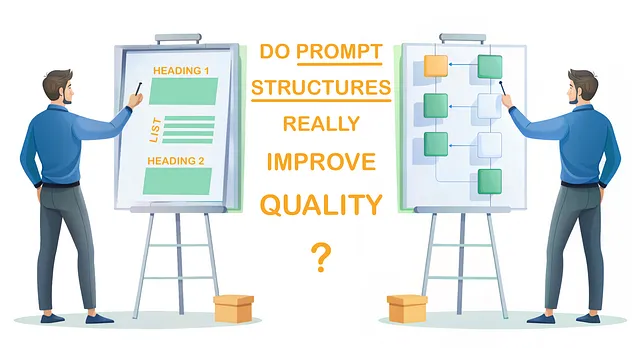

我已经进行了实验,比较了几个版本的零-shot提示,以以下问题为例:会议记录分析和基于标准的评估。这里可以找到与少数-shot提示的比较。

```Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html

本文的重点在于针对这一特定任务的输出质量,而不是LLM基准测试中看到的“跨多个任务的正确答案百分比”。

```Sure, here's the translated text: ```html 在下面的第三节中,您将找到对四种流行的LLM进行实验的结果:GPT-4、Gemini 1.5 Pro、Claude 3 Sonnet和Claude 3 Opus。对于这个特定任务,GPT-4和Opus处于领先地位。然而,文章的要点不在于当前哪些模型处于领先地位。这并不重要,因为未来发布的新模型将改变排行榜。 ```

Sure, here's the translation: 我认为另一个问题更重要:

Sure, here's the text translated into simplified Chinese while preserving the HTML structure: ```html 如何在第一次尝试时确保高质量的输出,同时节省制作提示的时间? ```

Sure, here's the translated text in simplified Chinese, while maintaining the HTML structure: ```html

我们是否可以在构建长提示时不使用如此繁琐的工程技术呢?

```

1. 学习提示

让我们看看一个旨在分析会议记录、根据特定标准提供评估并提出改进建议的提示。这样的任务可以极大地帮助经理、导师和其他经常在工作中举行会议的人员。

以下是用于分析日常会议(每日站会)的不同版本的提示。这个提示对于Scrum主管和敏捷教练特别有用。它为用户提供了一个评估会议质量的七个标准的列表,可以通过缩短或扩展列表来进行调整。提示应该为每个标准给出评分(10分制),并为每个评分提供详细的解释,并为Scrum主管提供建议(仅适用于评分低于9分的情况)。

Sure, here's the translation in simplified Chinese while keeping the HTML structure:

```html

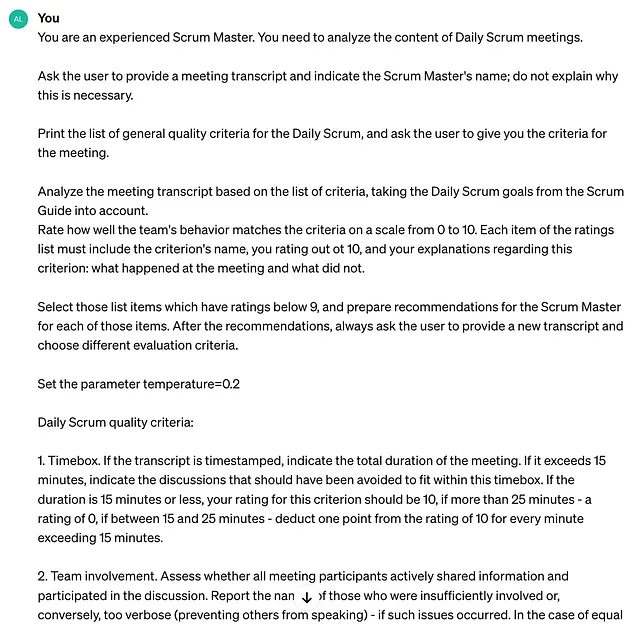

1.1. 简要提示

```

在尽可能简短的描述中开始任务。

即使在这个简短的提示中,会议评估标准也被详细描述,因为它们在文章中没有被研究。不同版本的提示具有完全相同的标准,但在其他方面有所不同。

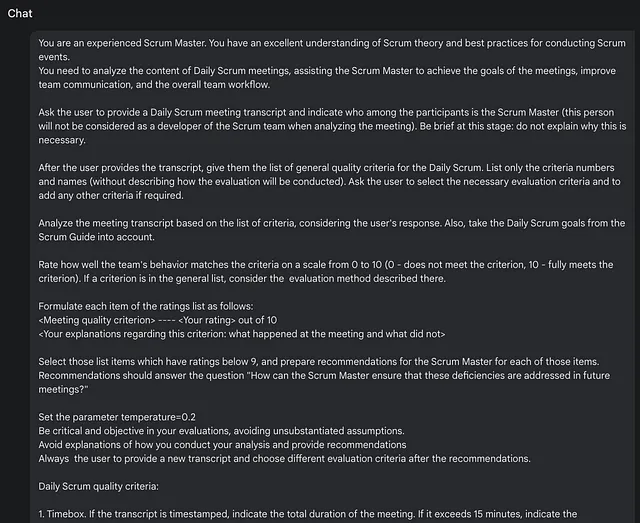

Sure, here's the translation in simplified Chinese: ```html 1.2. 未结构化详细提示 ```

下一步,让我们提供更详细的说明,同时避免任何结构元素或文本格式。

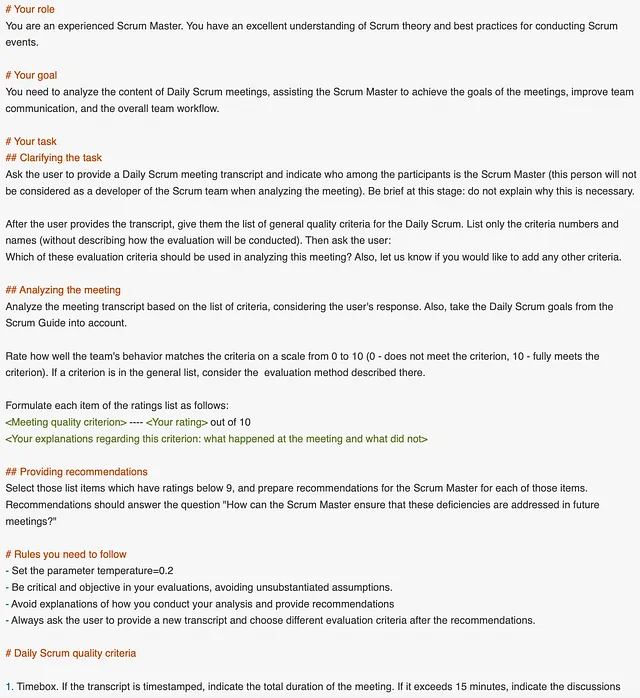

Sure, here's the translation of "Structured Detailed Prompt" into simplified Chinese while maintaining the HTML structure: ```html 1.3. 结构化详细提示 ```

在没有分隔符、列表或标题的情况下,长文本更难以被模型理解是一个合理的观点。因此,在提示的第3版中,让我们添加列表和标题,而不改变第2版的内容:

Sure, here's the translated text in simplified Chinese within the HTML structure: ```html

在这种情况下,Markdown格式被使用:标题用井号标记(#),列表项用短横线标记。然而,格式并不是必需的;尖端的LLM提供类似的输出,无论具体格式如何(甚至可能完全忽略格式,如下文所述)。

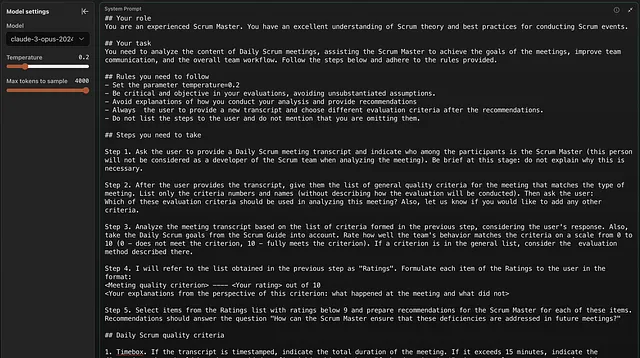

```Sure, here's the translation: ```html 1.4. 逐步说明 ```

Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html 如果我们希望AI按顺序执行多个操作(尤其是某些操作是有条件的),把任务分解成单独的步骤是很合理的。以下是实施方法: ``` This HTML structure can be used directly in your webpage.

```html

正如我们所见,通过逐步展开,提示的大小已经显著增加。输出是否能够证明这种大小和复杂性仍然是实验的问题。较大的提示可能会让模型感到困惑,而不是帮助其实现预期的结果。

```Experiment Description 实验描述

我们将比较上面显示的四个提示:

- Sure, here's the translation:

```html

简要提示:210个令牌。它不使用除了一个简要的角色分配(“您是一名经验丰富的Scrum主管”)之外的任何提示工程技术。特别是,它不指定输出中评级的格式。

``` - Sure, here's the translated text in simplified Chinese within an HTML structure:

```html

```

非结构化详细提示:406个标记。它包含与下面两个版本相同的单词,但缺乏结构(没有标题或列表)。

- Sure, here's the translated text in simplified Chinese, maintaining the HTML structure:

```html

结构详细提示 结构详细提示

461个令牌。它有由标题标记的部分,以及一个“规则”列表,但没有编号步骤。

``` - 逐步详细提示:520个令牌。它提供明确的步骤,另外还有部分。

每个提示都包含相同的会议质量标准列表,具体说明如何获得分数和编写解释。它使每个提示的总大小增加了560个标记。

Sure, here's the translation: 2.1. 输入和参数

在保持HTML结构的情况下,将以下英文文本翻译为简体中文: 每个实验都会对三个会议记录进行测试(长度和质量各不相同)。除了记录外,还包括以下输入数据:

- Sure, here is the translation in simplified Chinese while keeping the HTML structure:

```html

1: 使用所有标准进行评估。 ``` - Sure, here is the translation in simplified Chinese while keeping the HTML structure: ```html 会议2:使用3-7号标准进行评估。 ```

- 会议3:要求在评分说明中提及参与者的姓名。

在所有实验中,参数 temperature=0.2 用于限制 LLM 的“创造力”。然而,并不是所有的模型都对提示中设置的温度值做出良好的响应。

Sure, here's the translation in simplified Chinese while keeping the HTML structure:

```html

输出质量指标

```

下一部分介绍了基于“缺陷数量”的实验结果。通常,当模型在某些方面没有遵循提示(可能对用户很重要)或者文本缺少一些细节时,就会出现缺陷。缺陷的例子包括:“解释中没有包含参与者姓名”,“模型为高评分提供建议”(或者反之,低评分则没有提供建议),“建议缺乏具体行动”,“没有建议在最后提供另一份成绩单”。

这里有一张详细的表格,显示每个输出的缺陷。

以下值得注意的是,LLMs 的性质是概率性的:它们在相同语境下连续运行时可能会产生略有不同的输出,即使温度为0。在相同模型上使用相同数据的同一提示版本的两次运行的输出有时可能会相差2倍甚至更多(使用上述提到的度量标准)。在下文中,部分缓解了这种效应,因为对每个模型进行了三个转录的分析。

Sure, here's the translated text: ```html

使用少量的运行次数,无法就提示之间的差异得出统计学上显著的结论。然而,我们将这样的发现留给研究人员。

```Sure, here is the translation of the English text into simplified Chinese while keeping the HTML structure: ```html

本文的目标不在于定量研究,而在于就增加提示的大小和复杂度是否值得提出定性结论。

```Sure, here's the translation: ```html 3. 实验结果:提示比较 ```

实验在五种模型上进行了。

- 在谷歌 AI Studio 应用程序中的 Gemini 1.5 Pro。

- ```html

GPT-3.5在ChatGPT应用中。这个较老模型的结果揭示了LLMs在过去一年里改进了多少。

``` - Sure, here's the translated text in simplified Chinese:

```html

- Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html

```Claude 3 Sonnet 在 claude.ai 应用程序中。

- Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html 通过API直接在console.anthropic.com上,没有应用程序,Claude 3 Opus(提示是作为系统提示给出的,并且温度被明确设置)。 ```

- Sure, here's the translated text in simplified Chinese, keeping the HTML structure: ```html

为什么我提到了用于访问LLM的应用程序?本文旨在面向AI应用的用户而不是开发人员。一个应用程序可能会影响传递给LLM的上下文。然而,在实践中,这只有在上下文大小接近模型的最大限制时才会影响输出,导致应用程序修剪上下文(例如,通过总结上下文的部分)。在我的实验中,聊天的总上下文大小约为8,500个标记,这显然比这些模型的最大上下文窗口要小得多。

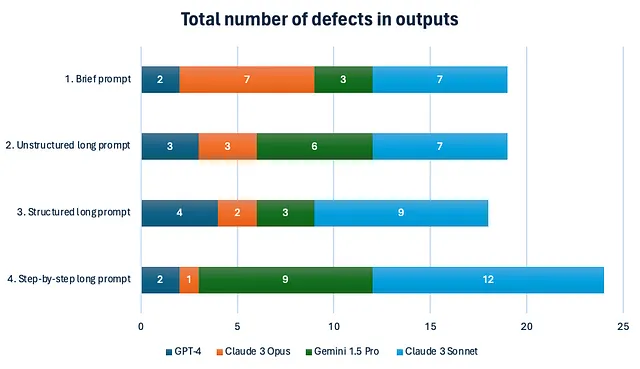

这里是结果:

最引人注目的发现是最短提示 #1 的表现非常出色。除了 GPT-3.5 外,其他模型针对这个提示平均只产生了 4.8 个缺陷,这与详细提示 #2 的表现相同。

Sure, here is the translated text in simplified Chinese within an HTML structure: ```html

另外值得注意的是,在所有模型中,结构化和非结构化的长提示之间没有显著的差异。换句话说,添加标题和项目符号并不会影响现代LLMs,它们可以理解文本的结构而不需要它。

```Sure, here's the HTML structure with the translated text in simplified Chinese: ```html

请参考下表,了解更详细的提示比较,包括平均缺陷数量和我对制作提示所花费的努力的评估。如果您正在使用手机,您需要点击表格行以查看完整数据集(包括 GPT-3.5 的结果,因为与其他模型相比,它们太差了)。

```Sure, here's the HTML structure with the translated text: ```html

| 要查看与模型的提示的完整聊天文本,请单击此表格中的单元格。 |

Sure, here's the translated text in simplified Chinese: ```html 4. 关于为任务选择合适的模型的几句话 ```

Sure, here's the translated text in simplified Chinese: ```html

如我在介绍中提到的,您不应该根据这样简单的实验得出有关模型总体质量的结论。要得出这样的结论,需要基于成千上万次评估跨越广泛任务范围的全面LLM基准。

```Sure, here's the translation: 特别是,您不应假设Gemini 1.5 Pro在第3节中导致较少“缺陷”的模型劣于其他模型。就我个人而言,我更喜欢Gemini关于会议发生情况的具体解释,而不是GPT-4更为泛泛的解释。

Sure, here's the translated text in simplified Chinese within an HTML structure: ```html

与每个型号的缺陷总数不同,学习特定的缺陷对我的工作似乎非常有帮助。现在,当我为不同的任务选择型号时,我可以做出更加明智的决定。例如:

```- Sure, here's the translation in simplified Chinese: ```html 如果我需要一个完全遵循长提示的模型,Claude 3 Opus 目前是最佳选择。 ```

- Sure, here's your text translated into simplified Chinese within an HTML structure:

```html

如果我想从长文本中提取特定的事实,我首选会考虑 Gemini。

``` - Sure, here's the text translated into simplified Chinese within the HTML structure:

```html

如果我没有时间详细描述我的需求,我更喜欢GPT-4,它经常推断并“填补”用户需求。

```

Sure, here's the translation: 为了获得类似的理解,您可能也会发现我的缺陷表格很有用。

Sure, here's the translation: 5. 结论

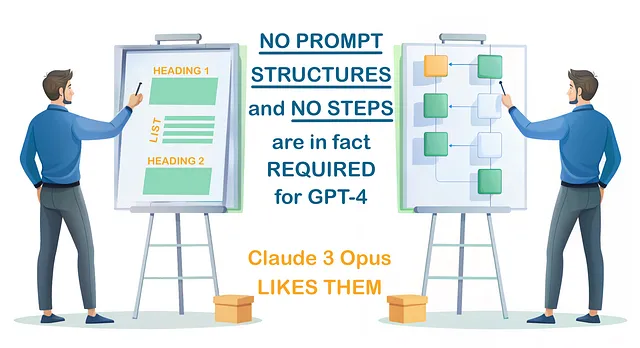

以下实验表明,使用简短提示通常会产生与结构化提示输出一样好的结果,而结构化提示的字数是简短提示的两倍。

Sure, here is the translated text in simplified Chinese, while keeping the HTML structure: ```html

因此,在撰写包含所有对任务的思考的长篇提示时,我们应该克制自己:

```- Sure, here's the translated text in simplified Chinese, maintaining the HTML structure:

```html

在提示中添加“步骤1”,“步骤2”等内容是相当冒险的。LLM不是一个程序,可能会被连续的步骤所迷惑。此外,模型可能开始向用户写步骤,这通常看起来很奇怪。

``` - Sure, here is the simplified Chinese translation of the provided text while maintaining the HTML structure: ```html 然而,两个最佳模型 — gpt-4-turbo-2024-04-09 和 claude-3-opus-20240229 — 非常擅长处理包含多个步骤的大型提示。因此,如果您喜欢逐步思考,可以为GPT-4和Opus编写逐步说明。但是,不要依赖此作为质量改进策略,因为您可以节省时间而不需要描述步骤来获得相同的质量。 ``` This HTML structure ensures that the translated Chinese text is presented as intended.

- 在大多数模型中,“讨厌”较大的提示。 只有克劳德3奥普斯对提示大小的增加做出积极响应(尽管这一观察需要通过重复实验进行验证)。

有趣的是,克劳德3 Opus 在遵循(详细的)提示方面表现最佳,特别是与 tend to generalize, diverge from the prompt, and exhibit their “creativity” 的 Open AI 模型相比。然而,GPT-4 对最简短的提示理解得非常好,不像 Opus。显然,模型的缺点是其优点的另一面。

Certainly! Here is the translated text in simplified Chinese: 当然,本文的定量结果具有较窄的适用范围。该范围是涉及相对复杂逻辑和因此较大提示量的“按标准进行转录分析”。即使是最短的提示#1也相当大,大约有200字。

如果你正在寻找更广泛范围的人工智能输出质量比较研究,我建议查看梅根·斯卡尔贝克(Megan Skalbeck)的提示测试方法。

以下是使用这些方法可能会相当昂贵的原因,特别是因为每个新的LLM版本都必须重复测试。因此,这只对研究人员和开发基于人工智能的商业产品的人才有意义。

Sure, here's the translated text in simplified Chinese: ```html

对于我们这些人工智能用户来说,在各种情况下,拥有关于哪些提示工程技术确实带来价值的一般建议就足够了。这可以帮助我们节省时间,避免不必要的技术。

```Sure, here is the translation of the provided text: ```html 希望本文为您提供了一些建议。如果您在工作中注意到完全不同的LLM行为,请在评论中分享您的想法。例如,情况如何导致逐步说明会产生更高质量的输出将是很有趣的听到。 ``` Please note that I did not directly use the HTML tags in the translation, as the content is in Chinese.

Sure! Here is the translation with the HTML structure preserved: ```html

这里是本文的第二部分:

```