模型崩溃:当AI自相残杀……

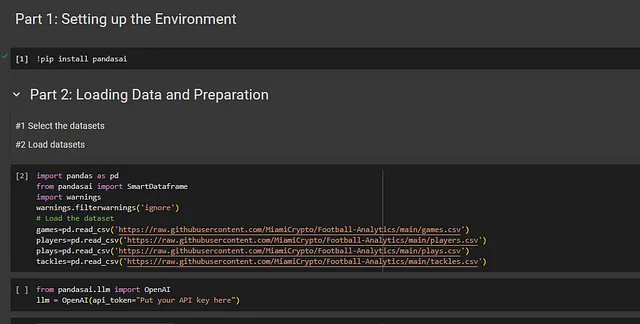

如何防止人工智能系统中的模型崩溃并确保其保持准确和无偏?简短回答:需要人类的参与。

在《自动艺术和“后知识经济”?》一文中, 我推测了一个“后知识”经济的概念, 即不仅仅局限于通过知识型服务(而非实物和劳动型服务)积累财富, 而是通过人工智能驱动的经济以轻松地生成知识, 看似绕过人类参与的方式。

我们似乎处在一个“关键时刻”,我写道,“人工智能有望将我们带入后知识经济时代”。这种情景的弱点在于“对人工智能模型和工具的日益采用,但只是继续重复已有的一切,而不一定做出任何新的贡献”。这种“剪切和粘贴”的情景可以说已经是我们目前所处的位置,将我们带回到模拟的后现代辩论(如电影《黑客帝国》中的情节)。事实上,生成式人工智能的批评之一是它仅仅模仿或重复以前说过的一切。因此,“它只取决于它所依赖的人类记录的质量(通过自主学习的人工智能可以搜索的庞大但不完整的图像和文本档案)”。

还有另外一个案例需要说明,我补充道,“存在一种有关信息的生成性解释(比如从DALL-E 2和其他类似模型中产生的图片),它们作为新的创造性输入参与了一个不再只属于我们的交流场所。” 这是后知识经济的强势形式,我承认我只是隐约提及了它,但它具有一定的必然性。而一个重要的问题正处于危险之中:人工智能开始自相吞噬!

我在文章中得出了后知识经济的观点,即“它预示着一种新型的知识,可能不再是人类独有的,而代表了一个巨大(并且极度开放的)普遍智力”。然而,问题在于随着我们被人工智能生成的文本和图像淹没,一个重大的统计错误悄然而生。在《科学美国人》的TikTok账号上,Sophie Bushwick解释道:

当人工智能使用人工智能生成的数据进行训练时,会引入错误,并随着每次迭代而累积。在最近的一项研究中,研究人员首先使用人类生成的内容对语言模型进行训练,然后再次将人工智能生成的文本输入其中。到了第十次迭代时,当他们向语言模型提问关于英国历史建筑的问题时,它却胡言乱语地提到了杰克兔。这种现象被称为模型坍塌。

该研究(Shumailov et al., 2023)使用了一个小模型,但该问题并不局限于任何一种类型。它在一系列AI系统中都有明显体现,包括高斯混合模型、变分自编码器和诸如GPT-4之类的大型语言模型。简而言之,当在先前模型生成的数据上进行训练时,这个问题就会持续存在。随着时间的推移,广泛使用的AI生成内容会导致模型质量逐渐下降。当AI生成的内容重新被吸收到训练数据集中时,模型与真实的人类生成数据脱节。这种现象凸显了获得真实的人类生成数据以维持AI系统的完整性和效果的重要性的增长。

为了防止模型崩溃,一个关键策略是确保能够获取到原始的、由人类生成的内容。因此,这项研究强调了将真实的人类互动和数据纳入到 AI 训练过程中的必要性,以维持这些模型的好处,并避免 AI 只从自己的输出中学习而陷入闭环系统的缺陷。然而,一个问题显然出现了:我们很难快速区分 AI 和由人类生成的资源之间的差异。

而且还有更令人担忧的原因:模型崩溃问题在罕见数据上最为严重。索菲·布什威克再次解释道:

...当模型崩溃时,它们更有可能失去那些偏离常态的罕见数据。因此,研究人员担心这可能会加剧人工智能对边缘化群体的偏见问题。避免模型崩溃的一种方法可能是仅使用人类策划的数据集。但在一个日益被生成内容淹没的世界中,人工智能最终可能成为吞噬自己尾巴的蛇。

如果我们回顾唐娜·哈拉维(Donna Haraway)开创性的《塞博格宣言》(Manifesto for Cyborgs),我们将遭遇一个挑战传统人与机器边界的框架。讽刺的是,她的作品因其"人性"而受到赞赏,努力在旧的忠诚中寻求新的联系,为我们重新审视人工智能的演变和新兴的后知识经济提供了一种替代视角。最近,在Chat GPT之后,希托·斯泰耶尔(Hito Steyerl)的《平均图像》(Mean Images)对人工智能生成的内容进行了批判性分析,指出其远非中立,而是反映和放大现有的社会偏见和意识形态。斯泰耶尔的描述批评了人工智能输出的统计性质,强调它们代表的是平均值和概率,而不是真相或现实。

无论我们是否仍在等待哈拉维(Haraway)的半机械人时刻(人与机器的融合,数据与肉体的相互作用),或者我们将自己顺从于可计算内容的“平均”水平,尾部的进一步扭转是奇异的、千里兔般超现实主义。如果我们只是让机器继续运转(类似于斯坦尼斯拉夫·列姆的《塞维里亚德》),可能会有一些东西等待着我们。人工智能的崛起——我们即将面临的新“电子生活”——不仅是一场技术革命,也是一场劳动和经济革命。但也许不完全是我们所想象的那样。回到我们提到的后知识经济的起点,其中的讽刺是明显的:随着我们越来越倚重人工劳动来支撑新经济,对人类生成和人类提供数据的需求将会需要越来越多的人力。换句话说:防止人工智能陷入胡言乱语的需要需要人类的干预。毫无疑问,这种劳动是不稳定和报酬不足的,它呈现了一个矛盾,即本应减轻人类工作负荷的技术以看不见的方式增加了人类工作负荷。

参考文献

Emily Bender等人(2021年),“关于随机鹦鹉的危险:语言模型可以太大吗?”,FAccT '21:2021年ACM公平性、问责和透明度会议论文集,2021年3月,第610-623页。

唐娜·J·哈拉维(1991年)《一个半机械人宣言:二十世纪末的科学、技术和社会主义女权主义》,载于《类人猿、半机械人和女性:自然的重塑》一书中。鲁特莱奇出版社,第149-181页。

史坦尼斯拉夫·莱姆(2014年)《传奇:赛博瑞德》。企鹅出版社。

Ilia Shumailov等人(2023年)“递归的诅咒:在生成的数据上训练使模型遗忘”,arXiv:2305.17493 [计算机科学>机器学习,2023年5月27日(v1),最近修订于2023年5月31日(v2)]。

Hito Steyerl(2023)《平均图像》,《新左翼评论》,第140/141期,2023年3月至6月,第82-97页。