Microsoft的Orca 2:人工智能推理的一大飞跃

介绍

在2023年6月,微软发布了一篇革命性的论文《鲸鱼:从GPT-4的复杂解释轨迹中进行渐进学习》,在这篇论文中,研究人员展示了一个更小的130亿参数模型可以在某些基准测试中超越包括Chat GPT和BARD在内的更大型模型。最近,微软宣布发布了Orca 2,不仅有一篇研究论文,还发布了模型权重,对于开源社区来说这是一个重大消息。在本博客文章中,我们将详细介绍Orca 2的技术细节,这是微软第二版的人工智能模型,具备卓越的推理能力。

逆戟鲸 2:更近一步观察

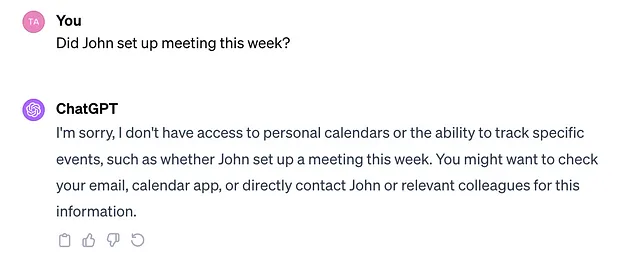

Orca 2的关键亮点是它能够超越更大的模型。拥有130亿参数的Orca 2在推理能力上始终表现优于拥有700亿参数的模型,展示了它令人印象深刻的实力。

理解奥卡2的培训方法

标题为“虎鲸2:教授小型语言模型如何推理”的论文,专注于增强较小模型的推理能力。微软的研究人员认为过度强调模仿大型模型可能会限制较小模型的潜力。与依赖模仿学习的传统方法不同,虎鲸2引入了各种推理技术。这些技术包括逐步回忆、直接生成答案以及针对不同任务的量身定制的解决方案策略。重点是赋予较小模型运用多样化的解决方案策略的能力,而不仅限于模仿较大模型。

基准和性能

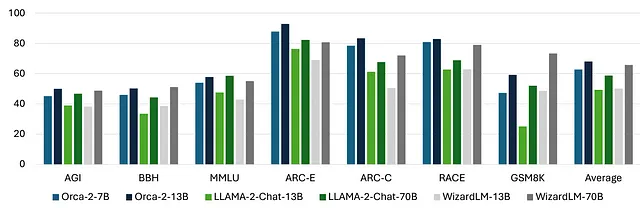

Orca 2的性能彰显了其训练方法的优势。以上结果展示了其卓越的推理能力。130亿参数的Orca-2模型在几乎所有的推理基准测试中都表现一致超过了700亿参数的LLAMA-2模型。700亿参数的WizardLM在GSM8K基准测试上超过了Orca-2,然而在其他指标上,Orca-2-13B与之持平。这些结果突显了微软采用的独特训练策略的有效性。

在本地运行Orca 2

对于那些渴望在本地探索Orca 2的人来说,这个过程非常简单。使用Python中的Transformer包,您可以加载模型权重并释放其功能。此外,微软还提供了LM Studio,一个用户友好的界面,用于测试大型语言模型。在这篇博客中,让我们逐步探索使用Hugging Face库进行推理的过程。

第一步:导入并设置

import torch

import transformers

if torch.cuda.is_available():

torch.set_default_device("cuda")

else:

torch.set_default_device("cpu")

步骤2:使用Hugging Face Transformers库中的AutoModelForCausalLM类加载Orca-2-13b语言模型。

model = transformers.AutoModelForCausalLM.from_pretrained("microsoft/Orca-2-13b", device_map='auto')

步骤3:加载与Orca-2–13b模型相关联的分词器。使用参数use_fast=False确保使用较慢的分词器。

tokenizer = transformers.AutoTokenizer.from_pretrained(

"microsoft/Orca-2-13b",

use_fast=False,

)

步骤4:通过组合系统、用户和助手消息来创建对话提示。

system_message = "You are an AI language model. You are a cautious and polite \

assistant. Please carefully follow the user's instructions."

user_message = "What came first, the chicken or the egg?"

prompt = f"system\n{system_message}\nuser\n{user_message}\nassistant"

步骤5:将提示词分词并从Orca-2–13b模型中生成回复。

inputs = tokenizer(prompt, return_tensors='pt')

output_ids = model.generate(inputs["input_ids"],)

answer = tokenizer.batch_decode(output_ids)[0]

print(answer)

总之,以上代码展示了如何使用微软Orca-2-13b模型来完成对话式人工智能任务,处理对话并根据用户输入生成回应。从关于鸡和蛋的哲学问题到关于人工智能投资的实际问题,Orca 2能够提供富有洞察力和合理推理的回答。该模型分析市场标准并提供潜在的投资考虑,展现了其实际应用价值。

O2的许可和可用性

请注意:Orca 2在微软研究许可证下仅供研究目的使用。虽然不适用于商业用途,但Orca 2所调整的基础模型Llama 2是可以用于商业目的的。了解许可条款将确保遵守使用准则。

结论

微软的Orca 2在人工智能推理领域崭露头角,突破了较小模型所能实现的界限。创新的训练技术、令人印象深刻的基准测试和用户友好的可访问性的结合,使Orca 2成为研究人员和开发者的宝贵资产。在探索人工智能进展的过程中,Orca 2是微软致力于推动人工智能前沿的证明。

参考资料

- Microsoft Research(2023年)“Orca:从GPT-4的复杂解释轨迹中进行渐进学习” 点击此处阅读论文

- 微软研究(2023年)“鲸鱼2:教授小型语言模型如何推理”论文链接