在Danswer中探索AI配置和设置(通过GPT与您自己的数据聊天和查询)第一部分

介绍

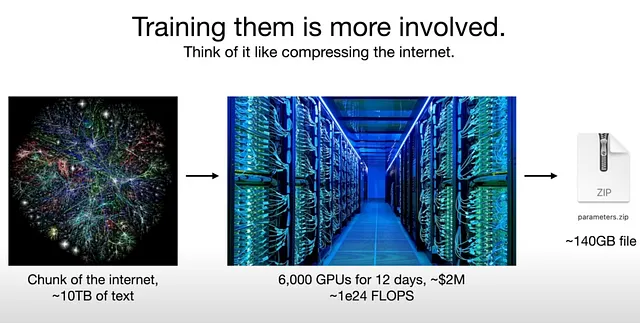

生成式人工智能(Generative AI)或大型语言模型(LLMs)在Danswer的能力中发挥着重要作用,使其能够根据通过搜索获取的相关文档来解释和生成答案。本概述探讨了Danswer支持的广泛的LLM托管服务,可用的多种模型选项以及实现无缝集成的配置。

关于Danswer的更多信息,请查看我们的另一篇博客文章。

先决条件

如果您想设置Danswer,Techlatest.net可以在AWS,Azure和Google Cloud上提供开箱即用的Danswer设置。

请点击下面的链接,按照逐步指南在您选择的云平台上设置Danswer。

对于Danswer:AWS,GCP和Azure。

为了通过浏览器访问Danswer GUI环境,请在虚拟机详细信息页面复制虚拟机的公共IP地址,并在浏览器中输入地址 https://vm_public_ip/。然后按回车键。

请注意:在访问Danswer GUI时,请使用https而不是http作为URL,例如:https://35.223.255.180/

LLM托管选项

Danswer支持多种LLM主机服务,包括OpenAI、Azure OpenAI、HuggingFace、Anthropic、Replicate、AWS Bedrock、Cohere等。用户还可以利用像Ollama和GPT4All这样的本地选项。此外,还支持自定义模型主机服务器,需要用户实现一个小型的LLM类来连接到他们的定制服务器。

轻量级LLM Langchain图书馆

保持HTML结构,将以下英文文本翻译为简体中文: LLM支持的灵活性由LiteLLM Langchain库实现,可以相应地配置每个托管服务。这使用户能够选择与其偏好和需求最符合的托管解决方案。

生成AI的用例

在Danswer中,LLMs对从文档中提取有价值的知识、提供智能答案起着重要作用。这些模型解释从检索到的文档中获得的内容,提供对信息的全面理解。

默认LLM

默认情况下,Danswer采用来自OpenAI的GPT-3.5-Turbo。该模型提供了无需批准流程的可访问性,OpenAI的API托管确保了易用性和成本效益。它为刚开始使用生成式人工智能的用户提供了最佳起点。

选择不同的模型

用户可以根据自己的具体需求选择不同的型号。选择其他型号的原因可能包括尽管价格更高但需要更强大的性能(例如GPT-4),偏好具有不同数据保留政策的托管服务,或者希望通过在本地托管模型来实现完全控制。

答案模型配置

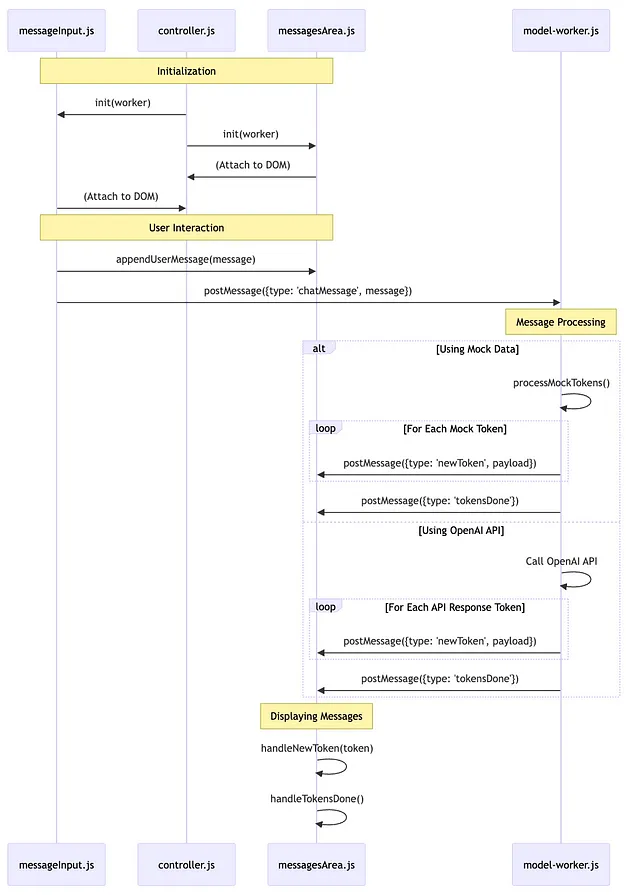

所有Danswer的生成式AI的配置都通过部署环境变量来管理。用户可以自定义LLM提供商,指定模型版本,根据需要提供API密钥,并为标准API设置LLM提供商类型。不论是使用Docker Compose还是Kubernetes进行部署,这些环境变量都可以进行生成式AI功能的微调。

所有Danswer Gen AI的配置都是通过部署环境变量完成的。对于Docker Compose来说,这意味着在部署过程中覆盖.env文件中的默认值。对于Kubernetes来说,这意味着更新服务部署的YAML文件(具体来说,是api_server和后台服务)。

影响通用AI模型的环境变量如下:

- GEN_AI_MODEL_PROVIDER: 使用与LiteLLM兼容的模型服务(例如openai、azure、huggingface、gpt4all等)。

- 指定“custom”来使用自定义实现。

- GEN_AI_MODEL_VERSION:要使用的模型版本,例如gpt-4,Falcon-180B-Chat-GPTQ等。

- 请务必使用与托管服务兼容的版本。

- GEN_AI_API_KEY:如果您的LLM服务需要API密钥(很可能是这样),请提供此密钥。

- GEN_AI_API_ENDPOINT: API端点,例如Azure OpenAI的https://danswer.openai.azure.com/。

- GEN_AI_LLM_PROVIDER_TYPE: 如果使用遵循标准LLM API的模型服务器,请进行设置。对于兼容OpenAI的模型服务器,例如fastChat,请设置为“openai”。

结论

Danswer的生成智能功能是一个强大的功能,使用户能够根据各种托管服务、模型和配置选择灵活性。无论选择默认设置还是自定义每个方面,Danswer都能确保在利用生成智能的力量时实现无缝和高效的体验。