人工智能中的人性因素:重新思考通用AI的学习过程

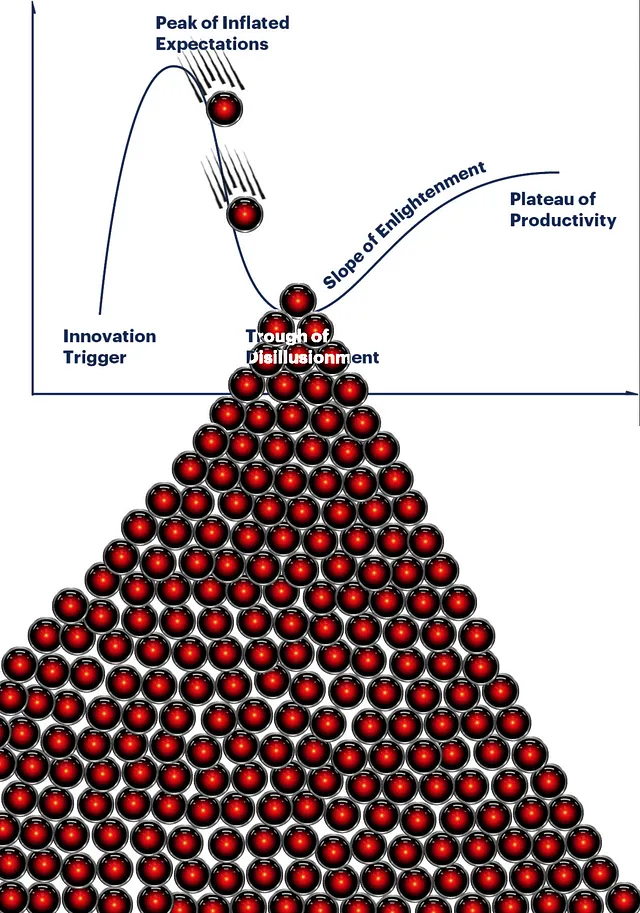

人工智能平台如ChatGPT正在成为我们的信息生态系统。然而,由于这些技术模糊了现实与虚构之间的界限,我们必须提出一个关键问题:我们如何确保所获得的信息保持清晰、准确和道德观念根深蒂固?

通过与Z世代与人工智能的互动和研究,我已经看到了一个未来世界的片段,这个世界不仅是高科技的,还是高度关注人性的 - 知情、高效和公平。但是,为了实现这一目标,我们需要的工具不仅要聪明,还必须具有连贯性、目标驱动性,并且要考虑到每个人的需求。我不仅仅是想影响技术;我希望通过真实的故事、研究和关怀来精心塑造它。因此,我一直在探索不同的方式,我们可以一起实现这个目标,首先从像ChatGPT这样的巨头迈出第一步。

为了开始一个方向,我提议一个想法-在ChatGPT的框架中整合一个人工驱动的验证层。这个层次将扮演两个关键角色。首先,它将使ChatGPT的学习基于来自经过验证、积极参与和动态实时环境的数据。其次,它引入了一个众包功能,使普通用户和专家可以参与验证训练数据。这种双重策略增强了ChatGPT主要获取准确信息的可能性,从而产生更可靠和明智的输出。

提高训练数据质量

我们现在都非常清楚网络错误信息不断升级的问题,这个问题在社交媒体的作用下被放大,可以瞬间触达数十亿人。生成式人工智能(如ChatGPT)的崛起加剧了这一问题,因为它目前是从随机的互联网来源学习,基本上是传播现有的错误信息。这就是我的模型发挥作用的地方,主张ChatGPT仅从活跃可信的来源学习,并由人类进行双重核实以确保准确性。这种验证训练数据的框架旨在抵制人们盲目接受在线信息的倾向,打断错误信息的循环。

平衡偏见与包容性

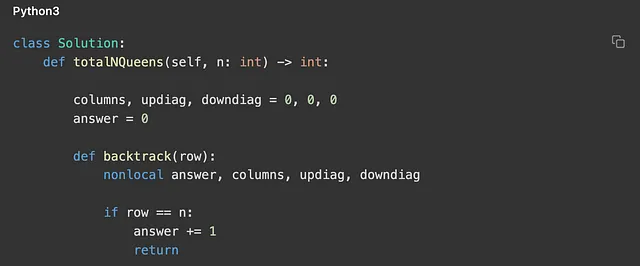

我谨记一件潜在的担忧,那就是人类参与训练过程可能会使ChatGPT的中立性产生偏差,因为参与者可能会引入他们的偏见。为了缓解这个问题,我的想法是ChatGPT通过使用广泛的用户参与指标(如点赞、评论和评价)来评估训练材料。这个初始的过滤器可以促进多样化的内容范围,反映公众话语的广泛议题,并通过用户互动和参与度来衡量话题的相关性。通过结合人工智能驱动的选择与人工验证,这个双管齐下的方法确保了ChatGPT的输入和输出都具有包容性和公正性。

应对可扩展性和响应能力

生成式人工智能平台处于不断变化的状态,使其与新趋势和用户偏好保持一致。批评人士可能会认为,随着用户数量和数据输入的增加,及时验证训练数据可能会变得具有挑战性,可能会妨碍ChatGPT的响应能力或功能。然而,人工驱动验证层将质量置于数量之上。由于生成式人工智能擅长处理大型数据集,人工专家仅专注于监督输入的有效性和道德一致性。这种策略有效地减少了瓶颈,保留了ChatGPT的灵活性和适应性。

培养人工智能社会动态中的信任

最终目标是使ChatGPT的训练过程更加负责,以便新兴公司也能建立更加谨慎和以人为本的基础。公众对人工智能的信任日益增长,这种信任建立在对透明度和社区参与人工智能开发的期望之上。通过将社会考虑纳入ChatGPT的设计中,我们可以营造开放的环境,与公众对可靠人工智能系统的期望保持一致,并促进更广泛的接受和利用。

在ChatGPT的架构中嵌入人为驱动的验证层是朝着负责任的人工智能迈出的一步。众包和透明、详细记录的人工验证流程的整合提升了ChatGPT的精度和可靠性。定期的检查有助于保持公正,从而产生更有见识、更及时和更可信赖的人工智能输出。这些考虑展示了一个未来,人工智能不仅与社会共存,还以更包容、准确和道德的方式丰富社会。

带着对未来的希望和手指触动键盘准备迎接下一个挑战,充满热情地结束。

阿尔萨