构建道德和安全的定制GPT模型:开发者的综合指南

简介

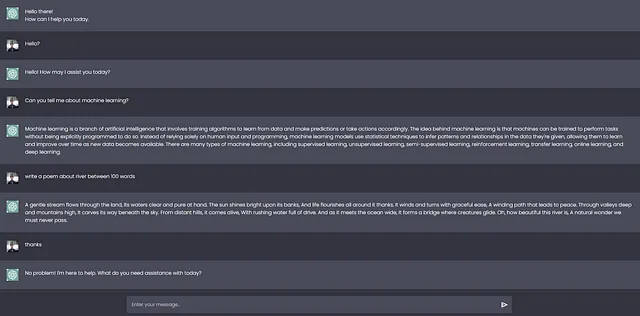

发现利用人工智能系统中的漏洞的技术,例如来自新加坡南洋理工大学研究人员的“主密钥”过程,凸显了开发人员在负责任地构建定制人工智能方面的需要。本指南为我的同行创作者提供了全面的最佳实践,以创建尊重用户隐私、促进公平性并防止滥用的伦理和安全的生成预训练转换(GPT)模型。

通过道德人工智能实践建立信任

- 建立一个伦理审查委员会,监督模型开发并维护问责制。任命法律、伦理、安全和社会公正等领域的多元专家。

- 通过设计伦理学方法论,将伦理考虑直接融入AI建设过程中,而不仅仅是作为一个事后补充。

- 使用数据标记、注入噪音和模型锚定等技术,以确保训练模型在推理过程中可靠地行为,避免出现有害行为。

促进公平和减轻偏见

- 通过偏见审查来策划培训数据,以最大化多样性和平衡潜在偏差。从第三方审计人员获得反馈。

- 利用WOE转换等算法,分配样本权重来抵消不均匀的训练数据。

- 持续测量模型输出在不同子群体中的实际表现,以识别任何隐藏的偏见或不公平的结果。

确保用户的隐私和数据权益

- 加密和匿名化用户数据,维护隐私权并遵守GDPR等法规。限制访问并实施网络安全协议。

- 明确传达用户数据的处理方式,包括收集、使用、存储程序和保留政策。提供透明度以建立信任。

- 通过选择同意,允许用户对自己的数据拥有控制权,能够更新个人信息,并且有提交数据删除请求的途径。

通过技术解决方案防止滥用

- 为了防止垃圾信息和滥用,限制API调用频率。

- 在封闭环境中进行沙盒部署,隔离网络并限制硬件访问,以限制潜在损害。

- 最后的选择是构建杀手开关和远程停用措施,以防止模型开始出现异常或恶意行为。

启用监督和协作

- 保持清晰明确的文档记录,涵盖安全控制、模型版本、数据物流和事故报告,以便进行内部和外部审计。

- 与学术研究人员和倡导团体建立技术咨询委员会以合作解决伦理问题和加强安全性。

- 为透明用户反馈和报告不当、偏见或剥削性的模型行为建立沟通渠道。严格调查并相应更新模型。

总结性建议

负责任的GPT开发是一项持续的实践,需要道德设计、广泛测试、持续监控和开发人员、研究人员和公众之间的合作。通过采取积极全面的方法,公司可以构建用户可以信赖的模型。总体而言,将社会福祉置于利润或进步之上是确保这些强大技术造福而非伤害的关键。