如何在使用ChatGPT和其他LLMs时保护您的数据

保护您的信息:深入探讨保护数据免受生成型人工智能的侵害

近年来,LLM的广泛利用几乎无处不在,人们通过与ChatGPT、其他聊天机器人的直接交流,或通过API将其集成到产品中,以各种形式参与其中。这些交互的核心在于提交提示,有时这些提示中包含个人身份信息(PII)。这些提示对语言模型生成的回应起着至关重要的作用。

重要的是要意识到,在这些互动过程中提交的提示信息通常会被提供生成式人工智能服务的公司存储。例如,OpenAI 会保留您的数据长达30天,Anthropic 则会保留您的信息长达28天。值得注意的是,当这些语言模型的训练过程中使用这些数据时,这个保留期甚至可能进一步延长。在本文中,我们将探讨与ChatGPT和类似的语言模型进行互动时,保护您的数据的有效策略和最佳实践,确保在使用这些强大工具的同时保护您的个人信息。

您可能会想到与OpenAI或其他AI公司存储您的提示相关的潜在风险。有几个原因使您必须非常小心提供给它们的信息。1. 数据泄露:数据泄露意味着您的机密或敏感信息被嵌入您的提示中,并暴露在一个不安全的环境中。这个威胁在2023年3月变得非常明显,当时OpenAI遭遇了一次重大数据泄露,未经授权的用户能够查看您的提示。

让我们来详细解释一下——当你与任何语言模型(如ChatGPT)交互时,其中的某些细节会被暂时存储下来。现在,问题在于,这些存储的信息会成为可能被具有恶意意图的黑客攻击的目标。想象一下这样的场景,那些具有恶意动机的人获取了临时数据储存,从而使你的个人信息有风险。

2. 利用提示数据以保留模型:在主要的人工智能公司中,一种普遍的做法是利用用户的提示数据来重新训练他们的模型。这种策略背后的目标是提升其产品和服务的整体体验。然而,这种看似无害的方法引发了一系列的担忧,促使一些公司甚至整个国家对使用大型语言模型(LLM)进行了禁止。举例来说,三星采取了果断的行动,禁止了Anthropic的Claude AI,理由是担心使用用户数据重新训练模型。同样,意大利在其国内实施了对ChatGPT的禁令,反映出全球范围内对人工智能公司所采用的重新训练做法可能带来的潜在风险的更广泛情绪。

3. 从LLMs中提取训练数据:你是否曾想知道人们如何从这些语言模型中提取信息?好吧,有一大堆研究论文探索不同的方法来实现这一点。例如,来看看由DeepMind和几所大学合作的“从产品语言模型中提取可扩展的训练数据”论文。他们揭示了一些获取训练数据的方法。猜猜看?还有更多的技术可供选择!

所以,让我们来详细分析一下。如果您的数据被用来训练模型,有人找出了如何提取它的方法,那就是一个警示信号。这意味着您的数据并没有像您可能认为的那样安全。在本文中,我们将深入探讨研究人员正在使用的各种方法,从语言模型中提取训练数据,以及为什么这对您的数据安全是一个问题。

我明白了,你并不是在这里了解有关LLMs的数据隐私和安全挑战的情况。好吧,准备好了吗?因为我们将深入探讨一些聪明的做法,这将使您能够保护您的宝贵信息。与LLMs互动时,有两种主要的保护数据的方式。

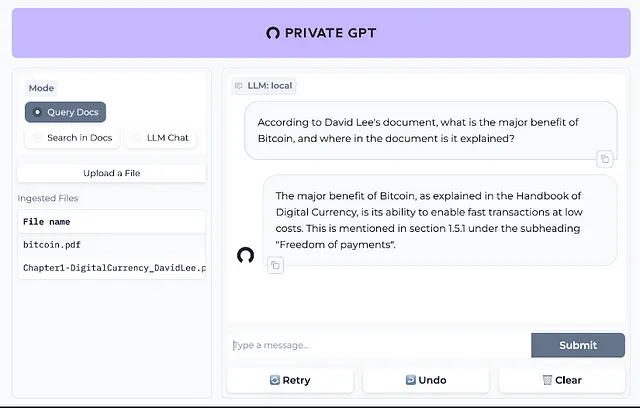

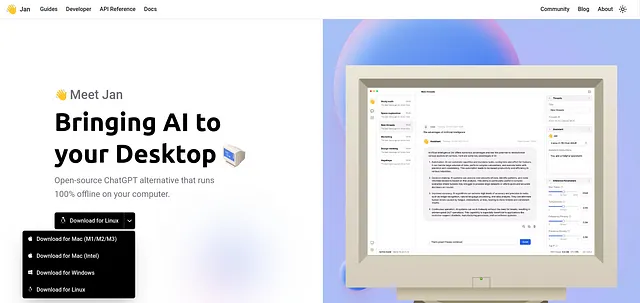

在本地运行LLM(语言模型)在保护数据安全方面,将其在本地运行是最有效的方法之一。这意味着您可以在未连接互联网的情况下操作您的模型,确保对数据有更高的控制水平。出现了几个简化该过程的工具,使其更易于使用。其中两个值得注意的选择是Jan AI和private GPT。在本讨论中,我们将重点介绍Jan AI。它是一个用户友好的工具,也消除了克隆GitHub存储库的需要。下面是您可以在Mac、Windows或Linux计算机上开始的方法:

- 下载 Jan AI:获取适用于Mac、Windows和Linux操作系统的Jan AI。

- 设置和模型下载:通过应用程序设置并下载开源模型。

- 选择您的型号:在右上角展开选项卡,选择您希望使用的特定型号。

- 定制说明:根据您的偏好,通过添加定制说明来调整模型的行为。

- 监控资源使用情况:在下方,您可以找到关于内存消耗的详细信息,从而了解所使用的资源。

请注意,在本地运行LLM可能会导致稍慢的性能,并可能需要一些更多的计算机资源。然而,这样做可以提高数据安全性,为您提供更多的控制和安心感。

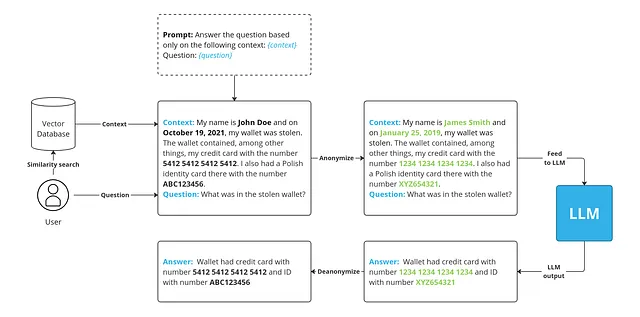

数据匿名化和去识别化

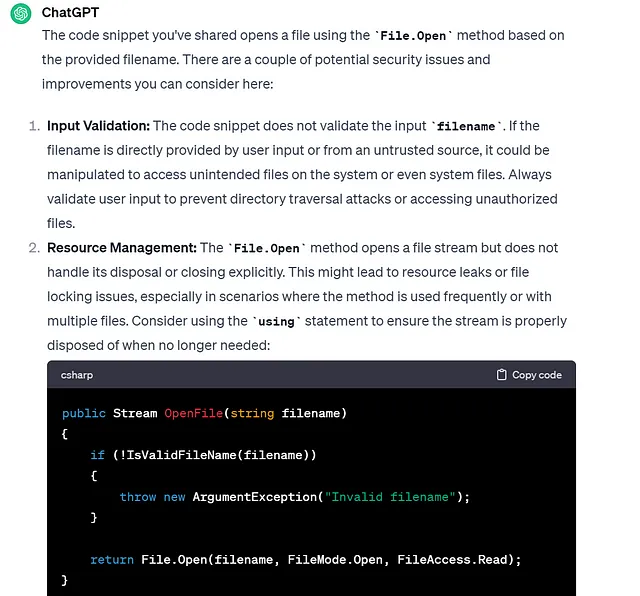

数据匿名化是在将数据包含在像GPT-4这样的语言模型的提示中之前,使数据匿名化的过程。这对于保护隐私和保密信息非常重要。如果您不对数据进行匿名化处理,敏感细节,例如姓名、地址、联系电话或与特定个人相关的其他标识符,可能会被发现和滥用。像微软的Presidio这样的工具,它被集成到Langchain中,可以帮助进行这个过程。

在这篇文章中,我们深入探讨了与生成式人工智能互动时的数据隐私挑战。但别担心!我将为您提供两种强大的策略来保护您的数据。不仅如此,我还透露了一些聪明的工具,每种方法都能确保您的数据像福特诺克斯堡一样安全。所以,让我们转变对隐私问题的担忧,使与人工智能的互动变得轻松愉快!