应对“真实性”问题:确保大型语言模型的可靠性

大型语言模型(LLMs)的崛起引发了对它们改变我们与技术互动和工作方式潜力的兴奋。不管是写代码、生成文档、总结报告还是分析数据,LLMs 展示了惊人的生成近乎人类般文本的能力。

然而,他们不可思议的流利有时可能会误导人。 LLM(语言模型)有一种“幻觉”的倾向——他们会编造听起来有说服力的陈述,但却没有任何事实依据。这种倾向被描述为他们的“真实性问题”,对于在敏感领域(如医疗保健和金融)中安全和道德地使用LLM而言,构成了一个重大障碍。

LLMs已经影响了全球范围内的重要商业决策。设计能够确保生成输出结果的信任、透明度和可验证性的系统对于可靠、道德和负责任的人工智能应用的发展至关重要。

本文探讨了在减轻幻觉并创建人类与LLMs之间可信赖关系的应用程序方面,技术方法(包括及时工程、知识检索和自我完善)和用户体验设计的重要性。

为什么可核实性很重要

不同于大多数为狭窄任务设计的传统AI系统,LLM在训练过程中接触到大量的在线文本。这使得它们能够推测信息和模仿人类语言,但也意味着它们很容易受到数据中的偏见影响,并且喜欢生成令人信服的虚假信息。当利用LLM的生成能力进行法律咨询或投资建议等重大场景时,小错误可能会导致灾难性后果。

为了在企业环境中负责任地部署LLM(语言模型),确保它们的输出可验证是非常重要的——即可追溯到可信源头的语句来源。这使得终端用户可以“信而核实”建议。用户体验设计在此方面起着关键作用,通过整合交互功能来实现透明度,如证据链接和解释。

像Perplexity.ai、Scite.ai、Cohere和ChatGPT这样的平台正在开创新颖的用户体验,其中包括对外部参考文献的引用并提供用户检查陈述可靠性的能力,以解决LLM的黑箱问题。随着企业越来越多地利用LLM的能力来增强人类能力并增强决策能力,这种创新将至关重要。

应对幻觉的新兴策略

最近发表的一份调查论文介绍了一种深入的分类法,对研究人员为解决幻觉问题引入的多样技术进行分类。这些技术从最初的文本生成后的改进到从零开始设计更加忠实的创新模型构架都涵盖其中。

后期生成改进

使用研究和修订的Retrofit Attribution(RARR)和高熵词汇检测等方法在初始生成阶段之后对LLM输出进行优化。RARR模仿事实核查工作流程-获取证据以验证生成文本中的声明,并进行编辑以与可靠来源对齐。高熵词汇检测识别LLM输出中缺乏事实依据的推测性术语,并使用次级LLM将其替换为更少歧义的替代词汇。

自我完善通过反馈

其他技术采用了一个反馈循环——检查 LLM 初始输出中的矛盾陈述等缺陷,并使其相应地改进其回应。例如,ChatProtect 方法通过制定一个三步流程来确定矛盾陈述并通过有针对性的提示来减少它们的发生。

提示工程

细致地设计指令和示例,为LLMs提供启动的有效策略正在逐渐形成。像UPRISE和SynTra这样的方法优化模型提示,以减少对话和摘要等特定下游任务的错觉。

监督微调

调整模型权重通过在标记数据集上进行微调是另一种方法,其中技术(如知识注入)直接在相关领域知识上训练模型。HAR通过产生关于事实主题的虚假细节来生成反事实数据集,帮助模型更好地区分真实和虚构。

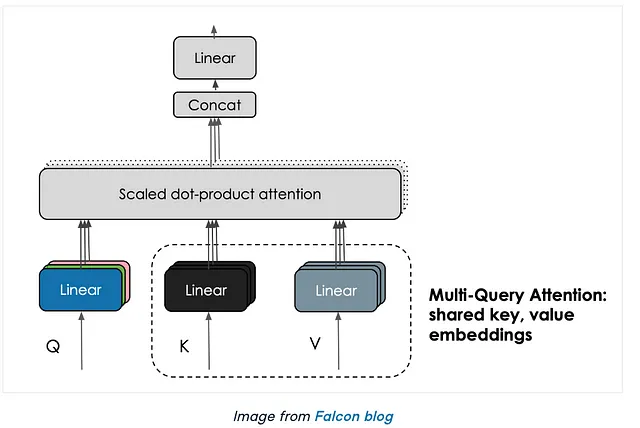

小说模型架构

一些研究从头开始设计新模型,以增强信实性。这包括上下文感知的解码策略,如CAD,可以覆盖语言模型的先验知识和给定输入之间的矛盾,并且损失函数可以惩罚虚构内容。

设计信任:用户体验设计的作用

我们消费人工智能生成的结果并与人工智能模型进行互动的方式在塑造LLMs的“真实性”和增强其结果的可信度方面起着至关重要的作用。一个精心设计的用户体验可以使用户能够在盲目接受人工智能生成的内容和具备批判性评估和验证该信息的用户之间产生差异。

透明度至关重要。用户体验应设计为为用户提供关于LLM操作方式、限制条件和信息来源的清晰了解。例如,当一个LLM提供一个答案时,用户体验可以包含一个功能,允许用户查看“置信度评分”或数据源使用的摘要。这些功能使用户能够评估所呈现信息的可靠性。

另一个方面是用户反馈机制的整合。允许用户标记不确定或不正确的回答有两个好处:一方面提供了改进模型的数据,另一方面给用户在人工智能生态系统中的控制感和参与感。这种反馈循环可以成为建立信任的强大工具,因为用户可以看到他们的意见被重视并被采纳。

提供定制选项还可以增强信任。用户有能力设置他们接收信息的偏好,比如选择详细解释或简明摘要之间的区别,可以让用户获得个性化的体验。个性化的定制尊重用户的个体需求和学习风格,在建立用户与人工智能之间信任关系方面起到关键作用。

创意的用户体验设计能够实现透明度和“信任但需核实”的方法,将与模型架构和促进进展同样重要——使终端用户能够无缝验证LRL所作陈述的渊源。

可信度的法学硕士

虽然每种技术都有独特的贡献,但长期解决方案很可能需要针对特定使用情况量身定制的策略的融合。通过无监督和弱监督技术减少对标记数据的依赖可能会提高可扩展性。将自我纠正能力与基于实际知识检索相结合的体系结构具有潜力。制定普遍有效的策略需要研究人员、开发人员和领域专家的持续合作。

LLMs的用户体验不仅仅涉及美观或者易用性。它是建立用户和人工智能之间可信任关系的基本组成部分。 通过优先考虑透明度、反馈、可访问性、定制化和持续改进,用户体验设计师可以创建用户不仅对人工智能的性能满意,而且能够“信任但验证”的环境。

随着LLM在能力和安全性方面不断成熟,它们在商业生态系统中的地位必将得到巨大扩展。验证性LLM可以丰富人类智能,同时严格验证信息,有潜力改变金融、法律和医疗等领域的工作流程。通过努力提高模型的可信度,并做出深思熟虑的用户体验选择以实现用户透明度,我们可以充分发挥LLM的优势,进行协作决策,同时减少其缺点的影响。

如果您想了解更多有关如何利用大型语言模型帮助您的组织更智能地工作的信息,欢迎您通过AecFoundry与我联系或在LinkedIn上添加我。