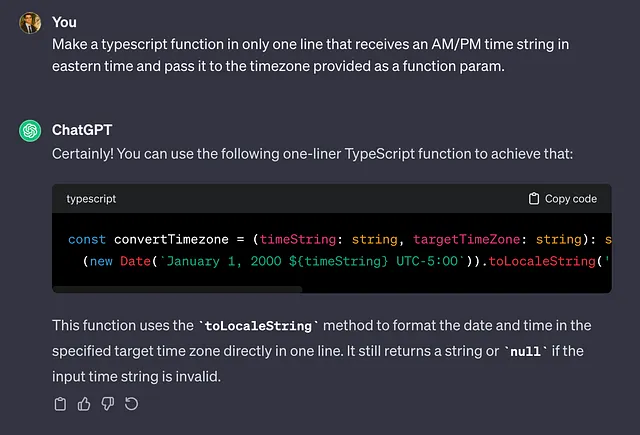

检索增强生成的结束?新兴架构预示着变革。

检索增强生成(RAG)一直是增强大型语言模型(LLM)用于复杂的、知识驱动任务的基石。通过从向量数据库中提取相关数据,RAG赋予LLM以事实基础,显著减少了虚构信息的出现。但这是RAG的终点吗?

克服核心限制:展望未来

RAG的必要性源于当前LLM中的基本限制。尽管这些模型具有令人印象深刻的学习能力,但它们的知识仅来自预训练的互联网文本,缺乏对现实世界的认知,并且在事实推理方面表现困难。因此,RAG在注入动态的外部知识方面起着重要作用,提高了LLMs在应对知识密集型提示时的准确性。

然而,RAG并非没有缺陷。选择合适的嵌入、向量数据库和排序算法的过程非常微妙,会影响结果的有效性。从本质上讲,RAG一直是对LLMs中更深层次问题的脆弱解决方案。

新架构和扩展的曙光

模型架构和规模的快速进展意味着潜在的转变。其中两个关键领域尤为值得注意:

加速注意力机制

• 创新如稀疏、线性和闪电注意力机制正在重新定义传统的Transformer注意力机制,该机制受到计算序列长度二次方缩放的限制。

• 随着技术的进步,我们看到像Yarn、GPT-4-Turbo和Claude 2.1这样的LLM支持高达200k个标记的上下文大小。这种上下文大小的扩展使得LLM能够吸收更广泛的知识库,可能使RAG的外部知识检索变得多余。

超越变形金刚:

• 新的架构,如 Mamba 和 RWKV 正在挑战 Transformer 模型。这些模型通过使用线性注意力机制来解决 Transformers 中自注意力的二次计算和内存复杂性。

• RWKV将RNN和transformers的优势相结合,提供高效的内存使用和并行训练。与此同时,Mamba引入了一种用于结构化状态空间模型的选择机制,实现了线性可伸缩性和上下文相关推理。

3. RAG:必需品到利基市场的过渡? Note: The translation provided is in simplified Chinese characters.

虽然这些进展不会立即使得RAG过时,但一个转变是不可避免的。一两年后,RAG可能会从一个关键的组成部分转变为一个小众优化工具。对于增强LLM限制的需要将随着这些模型天然的无限上下文长度而减弱的。

未来的LLMs和RAG

不断发展的景观暗示着一个可能成为过去的过去,因为我们所知道的RAG可能会成为一种古迹。 LLM(语言模型编程)正在稳步迈向一个现实,其中他们的知识库足够庞大,使整个RAG架构 - 包括其向量数据库和文本分块 - 变得不必要。然而,某种检索系统可能仍然是填充上下文所必需的。

预测的RAG的消亡

总而言之,RAG的出现是一种应对暂时限制的创造性解决方案。随着LLMs在更大的上下文容量和更高效的架构下不断发展,对RAG的依赖可能会减少,最终导致其被淘汰。未来将呼唤着不仅更富知识,而且本质上更能处理人类知识广博的LLMs。