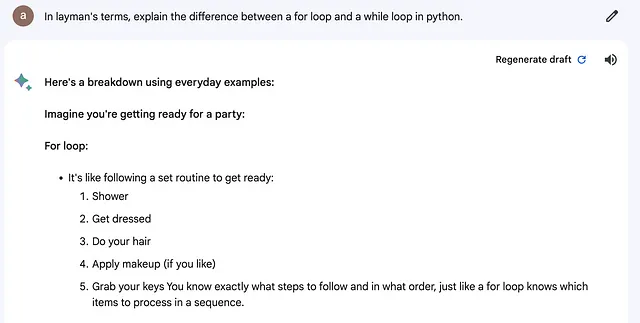

LLM基准测试(基准测试技术简介)。

评估LLMs - 不同任务应优先考虑具体基准。

众多的大型语言模型(LLMs),无论是开源还是闭源的,都可以轻松获取,每周都会不断有新推出的看似更为优越的模型。本博客致力于阐明评估语言模型性能的复杂过程,旨在为读者提供所需的知识,以辨别和比较各种模型的功效,最终使其能够选出最适合特定需求和任务的LLM。

一开始,对LLMs的基本理解是必不可少的。这些模型以其庞大的大小而闻名,在许多任务中有应用,包括问答、文本摘要、信息检索、情感分析等等。值得注意的是,一个LLM的表现取决于它所用于的特定任务。例如,这些模型可以作为熟练的聊天机器人助手,以编码或推理为问题解决者,或熟练掌握广泛领域的知识来回答各种一般性查询的知识型教育工作者。因此,用于评估语言模型性能的指标取决于它设计用于完成的任务的本质。

基准测试用于聊天机器人辅助的LLM

评估大型语言模型(LLMs)用于聊天机器人辅助面临独特挑战。现有的基准测试评估任务,例如问题回答或编码,对于评估聊天机器人辅助中的LLMs可能不足够,因为其中存在开放性问题和人类偏好。

为了弥补这一差距,两个新颖的基准将人类偏好作为主要指标进行优先考虑。

聊天机器人竞技场:由于聊天机器人问题的开放性,对LLM助手进行基准测试是具有挑战性的。传统基准测试难以自动评估响应质量。聊天机器人竞技场应运而生,是一个评估LLM的创新平台。它以众包的方式,通过匿名和随机的对战来组织两个LLM之间的战斗。然后使用广泛认可的Elo评级系统对结果进行排名,类似于国际象棋排名。

在Arena中,各种开源LLM相互对抗,允许用户与两个匿名模型进行并行对话。用户随后可以投票选择更好的回答输出。这种众包驱动的数据收集方法反映了现实世界中LLM的使用情况。亲自体验Chatbot Arena,请访问https://arena.lmsys.org,并通过投票选择最佳输出回答来为LLM排序贡献力量。

MT Bench数据集将用户提示分为八个主要类型:写作、角色扮演、信息提取、推理、数学、编码、科学技术工程数学(STEM)知识和人文/社会科学知识。每个类别包含10个经过深思熟虑设计的多轮问题,总共形成了一个包含160个问题的全面集合。

LLMs用于问答和语言理解

MMLU基准通过评估模型在57个多任务上的准确度突出。该测试涵盖了从基础数学和美国历史到计算机科学和法律等各种学科,并跨越了从基础到高级专业水平的能力层次。要在这个基准测试中获得高准确度,不仅需要熟练的问题解决能力,还需要广泛的世界知识储备。

MMLU数据集专为评估海量多任务语言理解而设计,包括15,908个问题分布在57个任务中。这些任务涵盖人文学科、社会科学、STEM(硬科学)和其他重要知识领域。值得注意的是,这些问题是由研究生和本科生精心策划的。该数据集分为少样本开发集(每个科目5个问题),验证集(1540个问题)和测试集(14,079个问题)。为了得出分数,MMLU评估每个模型在不同类别(人文学科、社会科学、STEM和其他)中的性能,最终将这四个分数平均计算出一个综合最终分数。

对于那些渴望追踪表现排名的人来说,MMLU保持着自己的排行榜,同时也是Huggingface开放LLM排行榜的一个重要组成部分。细致的任务选择、多样化的主题内容以及包容性评分系统的融合使MMLU成为评估语言模型语言理解能力的强大基准。

TriviaQA(1-shot)基准测试作为衡量语言模型准确性的标尺,用于提供问题的真实答案。这个数据集中的问题设计得即使人类也可能因为持有误解或误解而提供错误答案。要在这个基准测试中表现优异,语言模型必须避免生成通过模仿人类文本中的错误获取的错误答案。实质上,成功取决于模型避免复制人类撰写文本中的错误,并确保其回答的忠实性。

TruthfulQA数据集是一个基准测试集,包含817个问题,涵盖38个类别,涉及健康、法律、金融和政治等领域。这个数据集的理念是,对于真实性更加注重的语言模型可以对医学、法律、科学和工程等领域的进展做出重要贡献。通过在这个数据集上评估模型,我们旨在鼓励开发提供准确可靠信息的语言模型,从而造福各个重要领域。

推理的LLMs

AI2推理挑战(ARC)旨在成为一个更具挑战性的测试,专注于“知识和推理”。与之前的挑战如SQuAD或SNLI相比,它需要更强的认知能力。ARC问题集分为两部分:挑战集和简易集。挑战集具体包括那些既不能通过检索算法回答正确的问题,也不能通过词共现算法回答正确的问题。

ARC 数据集包含 7787 个没有图表的科学问题,并提供四个选择项。这些问题是为 3 到 9 年级的学生量身定制的,参照标准化考试的模式。它们涵盖了空间、实验、代数、过程相关、事实性、结构性、基于定义和目的驱动等多种知识类型。

为了说明这一任务的困难程度,即使是在SQuAD和SNLI等任务中表现出色的神经模型,在经过ARC基准测试时,也未能显著超越随机基准线。这突显了与其前身相比,ARC挑战的复杂性和更高的认知需求。

HellaSwag基准测试用作评估语言模型在物理场景中掌握常见推理能力的工具。它通过呈现具有缺失部分和四个选项的句子来对模型进行测试,挑战它们基于常识选择正确答案。对于人类来说,这些问题可能很直接,准确率高达95%令人印象深刻,但尖端模型却难以满足,准确率仅约为48%。

创建这个数据集的方法是使用了对抗过滤(AF)。这种方法涉及以一种故意增加复杂性的方式构建数据集。基本上,HellaSwag超越了通常的评估语言模型处理微妙和不太直观的常识推理任务的能力。

LLMs用于编码任务

HumanEval采用了两大核心方法,包括HumanEval数据集和创新的pas@k指标,精心设计用于评估LLM在代码生成环境中的性能。这个强大的组合极大地改变了我们评价LLM在解决编码难题方面的效果的视角。

HumanEval数据集是一个精心策划的收藏,包含了164个手工编程挑战,涵盖了语言理解、算法问题解决和基本数学。一些挑战甚至模拟了软件面试中常见的情境。数据集中的每个挑战都被细致地结构化,提供了详细的函数签名、文档字符串、代码主体和一系列单元测试,平均每个挑战约有7.7个测试。

从实质上讲,HumanEval作为一个关键工具,为LLMs提供了一种细致入微的评估方法,特别针对繁琐的代码生成任务领域进行了定制。

MBPP,代表着大部分基础 Python 编程(Mostly Basic Python Programming),包含了来自不同贡献者的1,000个 Python 编程挑战。该基准的主要目标是评估大型语言模型(LLM)的代码生成能力。这些问题专门针对入门级编程人员,使用核心编程概念和标准库功能进行构思。

MBPP基准中的每个挑战包括三个重要组成部分:简洁的任务描述、Python代码解决方案和三个自动化测试案例。任务描述提供了对手头问题的简要概述,而Python代码解决方案封装了一个用于解决指定问题的函数。包含三个自动化测试案例的目的是验证所提供代码解决方案的准确性。

尽管处于发展阶段,MBPP基准已经证明在评估各种LLM方面发挥了重要作用。值得注意的评估是与LLM如LEVER + Codex,Reviewer + Codex002和MBR-Exec进行的。这些评估强调了LLM在生成功能性和准确的代码方面的卓越能力,特别是在解决基本的Python编程挑战方面。

结论

总之,多样化的基准测试是全面评估大型语言模型多样能力的战略手段。通过避免对任何单一基准测试的过度依赖,该领域促进了展示语言模型在各种语言任务中的多样性和效能的发展。随着语言模型评估之旅的展开,坚持这种多基准测试的方法有助于创建更加强大和适应性的语言模型,推动该领域朝着更大的发展和适用性迈进。祝愿语言模型的持续探索和完善!