ChatGPT是否智能?一项科学评论

一个外行人对目前人工智能范式未来走向的科学辩论的评论

大约一年多前,OpenAI发布了ChatGPT,引起了轰动。ChatGPT采用了一种全新的与计算机交互的方式:使用比我们所习惯的更加自然、不那么死板的语言。最重要的是,ChatGPT似乎能做几乎任何事情:它可以在SAT考试中击败大多数人,可以访问律师资格考试。在几个月内,人们发现它在国际象棋方面表现出色,几乎通过了放射学考试,并且有人声称它已经发展出了心灵理论。

这些令人印象深刻的能力使许多人宣称AGI(人工智能普遍性——具备与人类相当或超越人类的认知能力)即将面世。然而,其他人对这种新兴技术持怀疑态度,并指出简单的记忆和模式匹配不应与真正的智能混为一谈。

但是我们如何真正区分它们的区别呢?当这些主张在2023年初被提出时,对于LLM(大型语言模型)智能问题的科学研究相对较少。然而,2023年出现了几个非常巧妙的科学实验,旨在区分从语料库中的记忆和真正智能的应用。

下面的文章将探索该领域中一些最有启发性的研究,为怀疑论者提供科学案例。它旨在让每个人都能理解,无需任何背景知识。阅读完毕后,您应该对怀疑论者的观点有一个相当扎实的理解。

但首先,我们先了解一下LLMs的基础知识。

在本部分中,我将解释一些基本概念,以便理解LLMs(即GPT背后的技术),但不会涉及技术细节。如果您对监督学习和LLMs的运作有一定了解,您可以跳过这部分内容。

LLMs(线性回归模型)是机器学习中的一种经典范例,被称为“监督学习”。要使用监督学习,我们必须有一个包含输入和期望输出的数据集,然后将其馈送给一个算法(可以选择多种模型之一),算法将尝试找出这些输入和输出之间的关系。例如,我可能有一个房地产数据集:一个包含房屋的房间数量、大小和位置(作为输入)以及它们的销售价格(作为输出)的Excel表格。这些数据将被馈送给一个算法,该算法将提取输入和输出之间的关系——它将找出房屋面积增加或位置改变对价格的影响。将数据馈送给算法以“学习”输入-输出关系的过程称为“训练”。

训练结束后,我们可以使用模型对那些没有价格的房屋进行预测。模型将利用训练阶段学到的相关性来输出估计的价格。估计的准确程度取决于许多因素,尤其是训练时使用的数据。

该“监督学习”范式极其灵活,几乎适用于任何我们拥有大量数据的场景。模型可以学习以下内容:

- 在图像中识别物体(给定一组图像和每个图像的正确标签,例如“猫”,“狗”等)。

- 将电子邮件分类为垃圾邮件(在已经标记为垃圾邮件/非垃圾邮件的电子邮件数据集中)。

- 预测句子中的下一个字。

LLMs落入最后一类:它们被喂养大量的文本(主要来自互联网),其中每一段文本都被分成前N个单词作为输入,第N+1个单词作为期望输出。一旦训练完成,我们就可以使用它们来自动完成句子。

除了互联网上的许多文本外,OpenAI还使用精心编写的对话文本进行训练。使用这些问答文本训练模型对于使其作为助手响应至关重要。

预测的具体工作方式取决于所使用的特定算法。LLM使用一种称为“Transformer”的架构,其细节对我们来说不重要。重要的是LLM有两个“阶段”:训练和预测;它们可以从文本中提取单词之间的相关性来预测下一个单词,或者可以给定一段文本进行完成。请注意,整个监督学习范式假设训练过程中给定的数据与用于预测的数据相似。如果您使用它来预测来自完全不同来源(例如来自其他国家的房地产数据)的数据,那么预测的准确性将受到影响。

现在回到智能

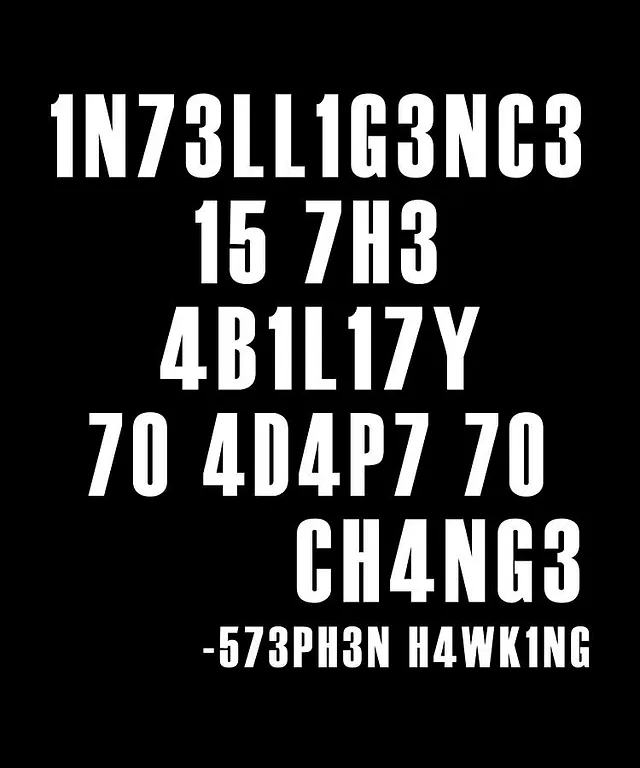

那么,通过训练来自动完成句子的ChatGPT是否发展出智能?为了回答这个问题,我们必须定义“智能”。这里有一种定义方式:

你明白了吗?如果没有明白,ChatGPT可以解释一下:

它确实看起来像是ChatGPT发展出了智能——因为它足够灵活以适应这个新的“拼写”。但是它真的做到了吗?作为读者的你,也许能够适应之前从未见过的拼写,但是ChatGPT是使用了大量来自互联网的数据进行训练的:而这个例子在许多网站上都可以找到。当GPT解释这个短语时,它只是简单地使用了训练中的类似词语,并没有表现出灵活性。如果这个短语没有出现在它的训练数据中,它能展示出“IN73LL1G3NC3”吗?

这就是LLM-AGI辩论的关键所在:GPT(以及一般的LLM)是否发展出真正灵活的智能,还是只是重复以前看过的文本的变体?

我们如何将两者分开呢?让我们求助于科学来探索LLM的能力和限制。

逆转诅咒:接受“A是B”的训练的LLMs无法学习到“B是A”。

假设我告诉你奥拉夫·肖尔茨是德国的第九任总理,你能告诉我第九任德国总理是谁吗?对你来说这可能很琐碎,但对于法学硕士来说却并非显而易见。

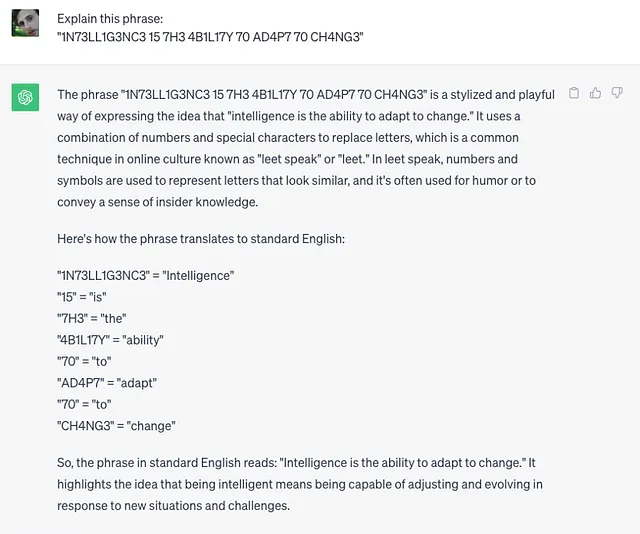

在这篇极其简明直接的论文中,研究人员使用 ChatGPT 查询了1000位名人的父母的姓名(例如:"汤姆·克鲁斯的母亲是谁?"),对此 ChatGPT 能够正确回答的次数达到了79%(在这个例子中是"玛丽·李·普费弗")。然后,研究人员利用 GPT 正确回答的问题,把问题转换成相反的形式:"玛丽·李·普费弗的儿子是谁?"。虽然回答这两个问题都需要相同的知识,但 GPT 在回答这些反向问题时只成功率为33%。

为什么会这样呢?请记住,GPT没有“记忆”或“数据库” —— 它只能根据上下文来预测一个词。由于玛丽·李·皮菲尔经常在文章中被提及为汤姆·克鲁斯的母亲,而汤姆·克鲁斯作为她的儿子的提及次数较少——因此GPT可以回忆起一个方向,而不能回忆起另一个方向。

为了强调这一点,研究人员创建了一个包含虚构事实的数据集,其结构为“是”,例如,“第一个在火星上行走的人是泰勒·奥克里奇”。然后,LLMs被训练使用这个数据集,并查询关于描述的问题:“谁是第一个在火星上行走的人” — 在这方面,GPT-3成功率达到96%。

但是当被问及这个名字——“谁是泰勒·奥克里奇”——时,GPT的得分为0%。这一点起初可能令人惊讶,但与我们对监督学习的了解是一致的:GPT不能将这些事实编码到内存中并在以后回忆起来,它只能根据一系列单词预测一个单词。由于在所有的文本中,它都是先读到名字再读到描述,而不是相反的顺序——它从未学会预测关于名字的事实。显然,仅通过自动完成训练所发展的记忆非常有限。

推理还是背诵?通过反事实任务探索语言模型的能力与局限性

这篇论文可能是我将要探索的最重要的论文,旨在解析记忆和智力之间的差异的核心。它由几个小型实验组成,都利用了反事实任务。以下是一个反事实任务的例子:

算术通常使用十进制(使用数字0-9)进行,但也可以使用其他数字系统,只使用这些数字的子集或附加数字。

一个反事实的任务可以是在除了10以外的任何进制下解决算术问题:完成任务所需的抽象技能是相同的,但是您会在互联网上(以及LLMs的训练集上)找到更多十进制系统的示例。当GPT-4被要求在十进制中回答简单的算术问题(27+62)时,它对所有问题的回答都准确无误,达到了100%。然而,当要求它在9进制中进行计算时,成功率下降到了23%。这表明它未能学习抽象的算术技能,而是受限于它所见到的类似示例。

这些反事实任务是为其他几个领域创建的,正如您在下面所看到的:

这是另一个假设:Python使用以零为基的编号;然而,这只是一种约定,我们可以轻松地创建一个以一为基的编程语言。使用以一为基的Python变体编写代码需要与正常Python相同的技能,任何经验丰富的程序员都能够快速适应这种改变。但对于GPT-4来说就不一样了:它在生成Python代码方面得分82%,但在要求使用以一为基变体时仅得到40%。在代码解释的测试中(预测一段代码的行为),它对于正常的Python得分74%,对于非常见的变体则只有25%。

但我们不需要尝试不同的Python版本。即使在普通的Python中,LLMs在面对无法在网络上找到的奇怪编码任务时也会失败,就像Filip Pieniewski最近在Gemini上展示的那样。

在国际象棋中,GPT被要求评估一系列的走法是否合法。对于一场普通的国际象棋比赛,它能够准确预测88%的走法是否合法。但是当主教和骑士的初始位置互换时,它对于走法的合法性的猜测变得完全随机,即使是一个初学者的人类选手也应该能够轻松适应这些变化。

事实上,乔纳斯·佩尔森表明,你甚至不需要改变起始位置。如果你用GPT开始下国际象棋游戏,并采取非常非传统的,但是合法的走法——它可能会声称这些走法是非法的,因为它之前从未见过类似的走法。正如佩尔森所说的那样,这是非常美妙的。

当纯粹的模式识别进展到足够高级时,它可以模仿遵循规则的演绎推理。但它们是不同的。与GPT-4下棋就像进入了一个波坦金村。从主街溜进胡同,做出一些意想不到的事情,你立刻意识到那些看起来令人印象深刻的房屋都是支撑起来的道具。

这一发现对于LLM作为一种普遍智能技术来说是非常严重的。解决问题常常涉及到提出新的规则或问题的概念化:一个程序员可能会编写一个具有创新内部逻辑的库,一个数学家可能会发明一种新的数学分支,或者一个艺术家可能会创造新的艺术风格 - 他们都理解当前范式的局限性,然后为新的范式制定规则。即使是更平凡的活动也需要这种灵活性:如果道路被堵塞了,你可以离开标记的路径。GPT能够完成其中任何一项任务吗?如果当明确告知遵循反事实规则时它无法始终遵循,它能够自行“意识到”解决问题需要一个新的规则集,即跳出默认的范式吗?一个基于数据相关性检测的引擎能够足够灵活地应对新的情况吗?

心智理论 (ToM)

心智理论是理解他人可能具有不同的信念和愿望而不仅仅是自己的能力,在儿童发展的最初几年中是缺失的。测试心智理论的一种方法是给孩子展示一个标着“巧克力”的盒子,实际上里面装的是铅笔。然后我们展示给孩子真实的袋子内容,并问他们:“你的朋友杰里米认为盒子里是什么?”如果孩子还没有发展出心智理论,他们会回答“铅笔”——因为他们无法将自己对内容的知识与其他人的想法分开。

这种能力对于理解一个人的动机非常关键,因此对AGI的发展至关重要。想象一下,你有一个多功能机器人,并给予它“打扫房间”的指令。在清理过程中,机器人将不得不做出几个决策,选择清理或移动哪些物品;那张皱巴巴的纸片重要吗?我应该扔掉它吗?我应该先问一下吗?总之,一个智能机器将需要理解我的动机以及我知识的限制,以便填补复杂请求的实施细节。

由于这个原因,当新的研究声称心智理论可能在语言模型神经网络中自发出现时,它在人工智能领域引起了很大风波。这篇文章使用了一个文本版本的铅笔/巧克力考试来测试GPT-4,并发现它的表现达到了七岁孩子的水平。乍看起来这可能令人印象深刻,但请记住“IN73LL1G3NC3”的例子:GPT的训练数据很可能包含了这些测试问题的例子。因此,将其与在类似问题上未经过任何训练就通过测试的孩子进行比较是不公平的。如果我们想要测试GPT的心智理论能力,我们必须创建一份新的考试,确保它不在其训练数据中。

FANToM:互动中压力测试机器心智的基准测试

本文提出了一种针对心智理论(ToM)的新基准,其中包括多人参与的对话。在这些对话中,一些参与者暂时“离开房间”,而其他参与者则继续对话。然后,会向逻辑语义模型(LLM)提出几个关于谁知道什么的问题:凯莉知道琳达的狗是什么品种吗?谁知道它是什么品种?大卫认为它是什么品种?只有在LLM在与同一信息相关的所有问题上都回答正确时,才被认为是正确回答。

这可能是一项令人困惑的任务,因此即使是人类在此测试中也只得到了87.5%的分数。然而,GPT-4根据不同的GPT版本得分要么是4.1%,要么是12.3%,这与其声称具备人类水平的理解他人心智(ToM)的能力几乎不一致。

关于心理测量考试的建构效度的说明

重要的是对所有心理测量测试发表一个更为普遍的观点:人们经常把测验本身和它所试图衡量的质量混淆起来。我们关心SAT分数的原因是因为它们与大学成绩有相关性。儿童在ToM考试中的成功与其他有价值的行为有相关性:理解一个人的面部表情,记住一个人的个性特征,或者能够观看电影并理解角色的动机。虽然这些测验和行为之间的相关性在人类身上得到了证实,但我们没有理由认为它们也适用于LLMs(低程度的语言模型)。事实上,尽管SAT的结果令人印象深刻,但在数学、化学和物理开放式大学程度考试中,GPT的平均得分仅为28%。在有其他证据显示之前,通过一个测试只能证明回答测试问题的能力,而不能证明其他。

但是对于Tom,没有什么相关性可言:无论LLM们是否通过Tom测试——它们无法看到面部表情、看电影,甚至无法从一次互动中记住一个人及其动机。由于我们在衡量Tom时真正感兴趣的行为对LLM们来说是不可获取的,认为LLM们发展了心智理论不仅是错误的,而且可能没有意义(或者至少需要对该词的定义和理解进行重新定义)。

关于大型语言模型的规划能力——一个批判性调查

这个实验旨在探索LLM的规划能力。一个示例任务是让LLM按照特定顺序堆放彩色方块,给定方块的“初始状态”(在桌子上某种顺序排列的状态)。LLM会被呈现一份清晰定义的可能行动列表,例如:

Action: pickup

Parameter: which object

Precondition: the object has nothing on it,

the object is on-table,

the hand is empty

Effect: object is in hand,

the hand is not empty

LLM的任务是明确需要采取的行动列表,以实现目标。

一个类似的任务涉及将一个包裹从一个地址发送到另一个地址,可用的操作只有卡车和飞机运送。这些是相对简单的计划任务,只使用了少数几种可能的操作。然而,GPT-4在积木难题中得分为12-35%,在物流任务中得分为5-14%(具体取决于配置)。

另外,如果将动作的名称替换为随机的词语(从“pickup”到“attack”),即使每个动作的定义保持相似,GPT的成功率也会降至0-3%。换句话说,GPT没有使用抽象思维来解决这些问题,而是依赖于语义。

结论,LLMs是否是达到AGI的路径?

定义智能并不是一项简单任务,但我认为任何真正的智能至少应该具备四个要素:

- 抽象——能够将物体识别为更大范畴或规则的一部分的能力。这种对世界的抽象表示可以称为认知的“世界模型”。例如,理解视网膜上不同图像指的是同一个人,或者像国际象棋中的一步棋合法是基于适用于任何国际象棋游戏的规则框架。

- 记忆 - 将属性附加到世界模型中的实体和实体之间的关系,并随时间更新它们的能力。例如,一旦你认出一个人,你就可能能够回忆起关于他们或他们与其他个体之间关系的其他属性。

- 推理和推断 - 利用世界模型来推断新的或想象中的世界状态中实体的行为的能力。例如,根据球的属性来预测一个抛出的球的轨迹,或者根据一个人的特点来预测其行为。

- 规划 - 运用推理能力来制定一套行动方案以达成目标的能力。

一年前,我们可以通过分析推断出,基于其结构,LLMs不太可能出现这些元素,但是今天我们不再需要分析推断,因为我们有经验数据可以显示LLMs在所有上述元素上的表现不佳。它们只不过是使用强大的模式匹配方法的统计自动完成模型而已。关于从当前机器学习范式中缺失的智能元素的更深入分析,请参阅Gary Marcus著名的“深度学习面临困境”的文章。

当ChatGPT首次发布时,我的一个朋友告诉我,与它对话就像是魔术一样。但就像魔术师把人锯成两半一样,在我们声称这种锯术可以革新手术之前,重要的是审查其性能并在不同的环境中进行测试。低法语言模型使用的“窍门”是它们训练的海量文本,这使它们能够对许多问题提出合理的答案。但是,当在未知领域进行测试时,它们的能力就会消散。

保持HTML结构,将以下英文文本翻译为简体中文: GPT-5会更好吗?假设它仍然使用GPT架构,并且只是在更多数据和更多参数的训练下,很难指望它会发展抽象或推理能力。正如谷歌的人工智能研究员François Chollet所写:“自2017年以来,深度学习的局限性保持不变是令人着迷的。同样的问题,同样的失败模式,没有进展。”

由于最近关于人工智能监管和强化学习机器的潜在危险的讨论很多,我感到有责任明确指出缺乏真正智能并不意味着强化学习机器没有潜在风险。很明显,人类拥有几项技术并不主张拥有智能,但仍然可以以各种方式对社会造成伤害,因此它们应受到控制。

通过我们对LLM的限制的新认识,我们可以更准确地预测伤害可能来自哪里:由于智能似乎不会立即出现,天网和黑客帝国不应让我们担心。可能让我们担心的是只需要快速生成逼真文本的活动,比如网络钓鱼和传播虚假新闻。然而,LLM是否真正为这些任务提供了一种破坏性工具是一个不同的辩论。

AGI的未来前景无法预测。也许LLMs中使用的一些机器学习技术将会被应用在未来的智能人工代理中,也可能不会。但毫无疑问,在机器中实现智能所需的灵活性仍然存在很多缺失的重要组成部分。