在黑匣子里面:变压器是如何改变自然语言处理的面貌的

介绍

\

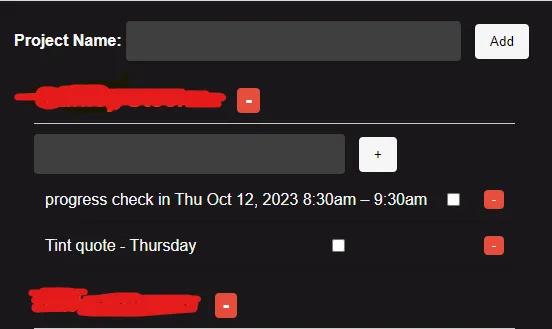

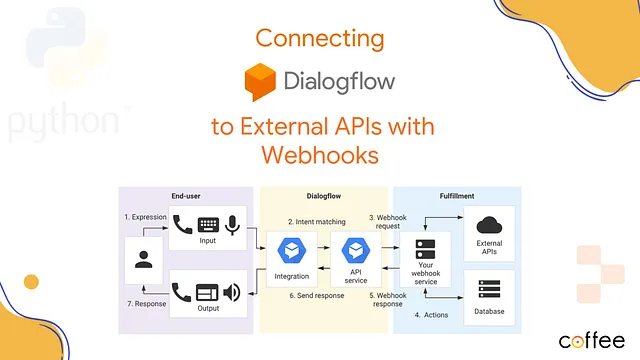

Transformer模型在自然语言处理(NLP)领域中崭露头角,彻底改变了我们理解和生成人类语言的方式。在各种类型的Transformer模型中,BERT(双向编码器来自Transformer)和GPT(生成式预训练Transformer)以其卓越的性能赢得了巨大的声誉和认可。这些模型,如ChatGPT和BARD,在超越了以往的NLP模型的能力的同时,为聊天机器人、语言翻译、情感分析等领域开辟了新的应用可能性。在本博客中,我们将深入探讨Transformer模型在NLP中的力量,探讨它们如何塑造语言理解和生成的未来。\

什么是变压器模型 变压器模型是一种神经网络架构,最早于2017年引入。它们与其他自然语言处理模型相比有一些优势,包括能够学习文本中的长程依赖关系以及能够非常快速地处理文本序列。

Transformer模型已经在各种自然语言处理任务中被用于实现最先进的结果,其中包括:

机器翻译

文本摘要化

问题回答

文本分类

文本生成

命名实体识别

情感分析

理解Transformer模型的基础知识

所以,在继续之前,让我们试着通过类比来理解这个。

类比:变形金刚模型为语言解释者

假设将变形金刚模型想象为一场多语言会议上的高技能口译员。在这个会议上,来自世界各地的人们汇聚在一起进行交流,每个人说着不同的语言。目标是进行有意义的对话并做出决策,尽管每个人都说着不同的语言。

自我注意机制:一个多语言的耳朵

Transformer模型使用类似翻译员具有出色听力技巧的自注意机制。当有人讲话时,翻译员会注意每个词及其所说的上下文。就像人们倾向于更多地倾听与当前话题相关的词汇一样,Transformer的自注意机制优先考虑与上下文更相关的词汇。

词法分析:将语言分解为单词

在会议之前,口译员会收到一本指南,帮助他们理解每种语言的工作原理。这本指南包括如何将句子分解为单词的信息,就像分词将文本分解为标记(单词或子词)一样。

预训练:学习多语言上下文

解释器已经研究了各种语言的广泛对话。同样地,变压器模型预先训练于互联网上的大量文本。它们学习了多种语言中词的上下文、语法和含义,为它们的解释打下了坚实的基础。

细化调整:专门为一种语言对进行优化

如果会议专注于特定的语言对,比如英语和法语,口译员会调整他们的技能,以在这两种语言中更加有效。同样,Transformer模型可以在特定的NLP任务上进行微调,使其成为那些任务的专家。

位置编码:理解序列

为了理解人们说话的顺序,口译员使用时间戳或手势来记住每个人的发言时间。Transformer模型使用位置编码来理解句子中单词的顺序。

输出:多语言沟通

当一个人用一种语言说话时,口译将他们的话转换成每个人都能理解的一种共同语言。类似地,转换模型可以将一种语言(或任何文本数据)转换成一种共同语言——一种共享的内部表示。这使得它们能够处理多语言交流和自然语言处理任务。

正如口译使不同语言的人能够有效沟通一样,转换器模型促进了人与机器之间的交流。无论使用何种语言,它们都擅长理解单词的含义和上下文,并且可以根据其训练和微调执行各种自然语言处理任务,就像口译专业人士在不同领域专长一样。

因此,Transformer模型是基于自注意力的概念构建的,它允许模型同时关注输入序列的不同部分。这种注意机制使得Transformer能够比以前的模型更有效地捕捉单词之间的上下文和依赖关系。

变压器模型的核心是编码器-解码器结构。

编码器处理输入序列并生成一个上下文化的表示,而解码器根据这个表示生成输出序列。这种结构使得模型能够处理各种自然语言处理任务,如机器翻译、文本摘要和问答。

此外,变形器模型结合了预训练和微调技术。在预训练阶段,模型会在一个大型无标签文本的语料库上进行训练,以学习一般语言模式。然后,使用较小的有标签数据集对具体任务进行微调,使模型能够专注于这些任务。

在下一部分中,我们将更详细地讨论变形金刚模型的关键组成部分,探索使它们在自然语言处理中如此强大的内部运作方式。请继续关注!

变压器模型在自然语言处理中的影响

Transformer模型对自然语言处理(NLP)领域产生了深远的影响。借助它们有效地捕捉上下文和单词之间的依赖关系的能力,transformers彻底改变了语言理解和生成任务。

Transformer模型的一个主要优势是它们在处理各种自然语言处理任务方面的多功能性。无论是机器翻译、文本摘要、情感分析还是问答,Transformer模型始终能够保持最先进的结果。它们的编码器-解码器架构使得输入序列的处理和输出序列的生成变得无缝,使它们适应不同的上下文。

另一个对Transformer模型成功做出贡献的关键因素是它们使用的预训练和微调技术。通过在大规模未标记的语料库上进行预训练,Transformer模型学习了底层的语言模式,并对语言具有一般性的理解。而后通过在特定任务上进行微调,使它们能够专门化并达到高性能。

在下一节中,我们将深入探讨变压器模型的技术细节,并探索它们产生重大影响的特定应用场景。不要错过这个令人激动的讨论!

利用变压器模型进行语言理解技术提升

变压器在语言理解任务中带来了前所未有的进展。它们捕捉长距离依赖和语境信息的能力使其成为自然语言理解应用中的强大工具。

一个被Transformer模型用于语言理解的关键技术是注意力机制。这个机制使得模型在处理输入序列时能够专注于重要的部分。通过为每个词分配不同的权重,模型能够更深入地理解词之间的关系以及它们在上下文中的相关性。

除了注意力,transformer 还使用自注意力机制,使其能够同时考虑输入序列中的所有单词。这一革命性的特性使得 transformer 能够捕捉全局依赖关系,并更好地理解文本的整体上下文。

此外,大型的预训练语言模型,如BERT和GPT的使用,进一步增强了transformers的语言理解能力。这些模型在海量数据上进行训练,并学会预测缺失的单词或生成连贯的文本。通过在特定任务上微调这些预训练模型,transformer模型在情感分析、命名实体识别和语义理解等任务中取得了显著的结果。

在接下来的部分,我们将探讨如何变革了语言生成任务的转换器模型,并讨论它们对文本生成和创造性写作的影响。请继续关注对转换器在语言生成中巨大威力的启示性讨论!

变压器模型和高级语言生成

语言生成一直是自然语言处理中的一个具有挑战性的任务。然而,转换器模型已经彻底改变了这个领域,并带来了前所未有的进步。凭借其捕捉长距离依赖和上下文信息的能力,转换器已经成为生成连贯和相关上下文文本的强大工具。

变压器模型在语言生成中使用的一个关键技术是自回归方法的运用。与传统语言模型一次生成一个单词的方式不同,变压器通过考虑之前生成的所有单词的完整序列来生成文本。这使得它们能够保持连贯性并产生更加类似人类的文本。

此外,转换器还利用了先前讨论过的相同的注意机制。这种注意机制使模型能够在生成文本时专注于输入序列的相关部分,确保生成的文本保持连贯和上下文适合。

Transformer模型已成功应用于各种语言生成任务,包括文本摘要、对话生成和机器翻译。它们生成高质量和上下文相关的文本的能力使其成为许多应用中的重要组成部分。

在即将到来的章节中,我们将深入探讨变形金刚模型在语言生成任务中所采用的技术和方法。我们将探索使用变形金刚生成文本的可能性和挑战,并研究它们对创意写作的影响。请继续关注对变形金刚模型在语言生成中巨大力量的迷人探索!

基于转换器的NLP模型示例

以下是一些基于Transformer的自然语言处理模型的例子:

BERT(Bidirectional Encoder Representations from Transformers)是一个基于Transformer模型的模型,它在大规模的文本和代码数据集上进行了训练。BERT可以用于各种自然语言处理任务,包括机器翻译、文本摘要和问答等。

GPT-3:GPT-3 是基于 Transformer 模型的模型,它通过大量的文本和代码数据进行了训练。GPT-3 可以用于各种自然语言处理任务,包括文本生成、翻译和创作不同类型的创意内容。

RoBERTa:RoBERTa是BERT的一个变种,它在更大的文本数据集上以不同的超参数进行训练。在许多自然语言处理基准测试中,RoBERTa胜过了BERT。

BART是一个基于变压器的模型,专为机器翻译而设计。BART在许多语言对上已经超越了先前最先进的机器翻译模型。

T5: T5是一个基于Transformer的模型,旨在成为通用的NLP模型。

T5可以用于各种NLP任务,包括机器翻译、文本摘要和问题回答。

在自然语言处理中,Transformer 模型具有广泛的现实世界应用。

变压器模型在各种需要自然语言理解和生成的现实世界应用中被证明是无价之宝。它们能够捕捉长距离的依赖关系和上下文信息,彻底改变了自然语言处理领域。让我们来探索一些关键应用领域,变压器模型在这些领域产生了重大影响:

1. 情感分析:Transformer模型广泛应用于情感分析任务,以确定文本所表达的情感。通过分析词汇的上下文和语义含义,transformers能够准确预测文本是否表达正面、负面或中性的情感。

2. 问答:变压器模型在问答任务中表现出色,通过理解上下文并从给定的文档或段落中提取相关信息。这改进了问答系统的准确性和效率,使用户能够获得精确的答案来满足他们的查询需求。

3. 聊天机器人和虚拟助手:我们利用变形金刚技术构建了先进的聊天机器人和虚拟助手系统。这些模型能够根据用户的输入生成类似人类的回应,从而实现更加有趣和个性化的对话。

4. 语言翻译:变形金刚模型捕捉上下文信息的能力极大地提升了机器翻译系统。通过考虑整个输入序列,变形金刚可以生成更准确、语言更地道的翻译。

5. 文本摘要:在文本摘要任务中,Transformer已成功应用,其目标是生成长文本的简洁而信息丰富的摘要。通过理解各个句子的上下文和相关性,Transformer模型可以生成高质量的摘要,捕捉原始文本的精髓。

这些只是变压器模型在各种应用领域中做出重要贡献的一些例子。随着我们不断发展和改进变压器架构,我们可以期待自然语言处理领域的更多令人激动的进展。变压器模型在语言理解和生成方面的能力确实非常出色,它们的影响将继续塑造自然语言处理的未来。

在语言理解和生成方面,变形金刚模型的未来潜力

转换器模型在语言理解和生成方面的未来前景广阔,对自然语言处理领域的进一步发展具有巨大潜力。随着研究人员不断探索和优化转换器结构,我们可以期待新颖创新的应用不断涌现。

一个领域,变压器模型有潜力在上下文感知的语言理解方面做出重要贡献。通过捕捉长程依赖关系,变压器能够理解句子或文档的上下文和细微之处,从而实现更准确的语言解释和分析。

此外,变压器模型还用于多模态学习的探索,它们可以将文本和视觉信息结合起来,以更深入地理解语言在图像或视频的背景下的含义。这为图像字幕、视觉问题回答和文本到图像合成等应用打开了可能性。

此外,随着大规模预训练和迁移学习技术的进步,变形金刚模型在理解和生成语言方面预计会变得更加强大。通过利用大量的无标签数据,这些模型可以捕捉更深层次的语义表示,从而在各种自然语言处理任务上提供更好的性能。

总体来说,变压器模型的未来光明无限,我们可以预见它们在语言理解和生成方面的持续影响。随着研究人员和工程师推动这些模型的可能性边界,我们肯定会见证自然语言处理领域中令人激动的发展和突破。

Transformer 模型相较于其他自然语言处理(NLP)模型的优势

在文本中学习长距离依赖的能力:Transformer模型可以通过关注输入序列的不同部分来学习文本中的长距离依赖关系。这与之前的自然语言处理模型不同,前者通常依赖于循环神经网络(RNNs)来学习长距离依赖关系。由于梯度消失问题,RNNs在学习长距离依赖方面存在困难。

非常快速处理文本序列的能力:由于Transformer模型可以并行计算自注意机制,所以它们能够非常快速地处理文本序列。这与RNN不同,RNN必须按顺序处理文本序列。

能够广泛适用于新任务和领域:已表明,Transformer模型能够在极少量的训练数据下适应新任务和领域。这是因为Transformer模型能够学习到一种通用的语言表示,可以应用于各种任务。

训练和使用转换器模型的挑战

Transformer 模型是 NLP 任务的强大工具,但也面临一些挑战。一个挑战是 Transformer 模型在训练过程中可能需要很高的计算资源。另一个挑战是 Transformer 模型对超参数非常敏感,这可能导致在特定任务中找到最佳超参数变得困难。

结论:拥抱NLP中的Transformer模型的力量

在总结中,变压器模型在自然语言处理中的能力无与伦比,它们能够彻底改变语言理解和生成的能力。通过捕捉长距离依赖和理解上下文,变压器模型能够提供更准确的语言解释和分析。此外,这些模型的潜在应用还可扩展到多模态学习,它们可以将文本和视觉信息结合起来,以更深入地理解图像或视频上下文中的语言。

随着大规模预训练和迁移学习技术的进步,变压器模型在理解和生成语言方面将变得更加强大。通过利用大量未标记数据,这些模型可以实现更深层次的语义表示,进而提高在各种自然语言处理任务上的性能。

随着未来的发展,我们可以预期变形金刚模型在自然语言处理领域持续产生重大影响。研究人员和工程师不断推动可能性的界限,我们可以预见令人兴奋的发展和突破,进一步巩固变形金刚模型在自然语言处理中的地位。现在正是拥抱变形金刚模型的力量和未来语言理解与生成巨大可能性的激动时刻。

作者:

拉什米·阿什塔吉(导游)

Bhushan Hatwar 卜松·哈特瓦

阿塔瓦·阿格拉瓦尔

Tanmay Deshmukh 丹梅·德舒姆克

Surabhi Deshpande 苏拉比·德什庞德