大型语言模型:一个单词的计算器

这是17世纪初,一位名叫埃德蒙·冈特的数学家和天文学家面临着前所未有的天文挑战。计算行星的复杂运动并预测日食需要不仅凭直觉,还需要掌握复杂的对数和三角方程。因此,像任何精明的创新者一样,冈特决定从零开始构建!他创建了一种模拟计算设备,最终成为后来人们所知的滑尺计算工具。

一个长30厘米的长方形木块,滑尺由两部分组成:固定框架和可滑动的部分。固定框架固定了对数刻度,可滑动的部分则容纳了可移动刻度。要使用滑尺,您需要了解对数的基本原理以及如何对齐刻度进行乘法、除法和其他数学运算。您必须滑动可移动部分以设置数字对齐,读取结果并考虑小数点的位置。哎呀,那真的很复杂!

大约300年后,第一台电子台式计算器“ANITA Mk VII”于1961年由贝尔点钞公司推出。在接下来的几十年里,电子计算器变得越来越复杂,并增加了其他功能。以前需要大量手工计算的工作经历了大幅减少的工时,使员工能够专注于工作的更多分析和创造性方面。因此,现代电子计算器不仅重塑了工作角色,而且为提高问题解决能力铺平了道路。

计算器对数学的实现方式进行了一次重大的改变。那么语言又会怎样呢?

想一想你是如何构成句子的。首先,你需要有一个想法。接下来,你需要了解很多单词(词汇)。然后,你需要能够将它们放入一个正确的句子中(语法)。哎呀,又是相当复杂的事情!

我们生成语言的方式在过去的5万年中保持着相当的一致性,这大约是现代智人首次创造语言的时候。

可以说,在生成句子方面,我们仍然处于冈瑟时代使用滑尺的阶段!

如果你思考一下,使用正确的词汇和语法基本上就是遵守规则。语言的规则。

这就像数学一样。它充满了规则。这也是为什么我可以确定1+1=2,以及计算器之所以能够工作!

我们需要的是一个用于单词的计算器!

是的,不同的语言遵循不同的规则,但规则需要在一定程度上遵循才能理解。语言和数学之间一个明显的区别是数学有确定的答案,而适合在句子中的可行单词的数量可以很大。

尝试完成下面这个句子:我吃了一份_________。想象可能会出现的单词。英语中大约有一百万个单词。其中很多可以在这里使用,但肯定不是全部。

回答“黑洞”就相当于说2+2=5。此外,回答“苹果”也不准确。为什么呢?因为语法!

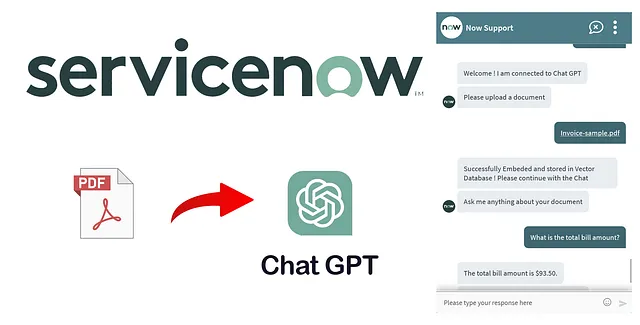

在过去的几个月里,大型语言模型(LLM)席卷全球。有些人称其为自然语言处理的突破,而其他人则将其视为人工智能新时代的开始。

LLM已被证明在生成类似人类的文字方面非常出色,提升了基于语言的人工智能应用的水平。基于广阔的知识库和上下文理解,LLM可以在各个领域中使用,包括语言翻译、内容生成、虚拟助理和客户支持聊天机器人。

问题是:我们当前是否与上世纪60年代的电子计算器一样处于同样的转折点上?

在回答这个问题之前,我们先了解一下LLMs是如何工作的。LLMs基于变压器神经网络,用于计算和预测最可能出现的下一个单词。要构建一个强大的变压器神经网络,你需要通过大量的文本数据对其进行训练。这就是为什么“预测下一个单词/标记”方法效果如此好的原因:可以轻松获取大量的训练数据。LLM将整个单词序列作为输入,并预测最有可能出现的下一个单词。为了学习最有可能出现的下一个单词,它会先摄取整个维基百科作为热身训练,然后再处理一堆书籍,最后是整个互联网。

我们之前已经确定语言包含规则和模式。该模型通过阅读所有这些句子来隐式地学习这些规则,以便在完成预测下一个单词的任务时使用。

在一个单数名词之后,下一个词是以“s”结尾的动词的概率增加。同样地,阅读莎士比亚的作品时,出现像“doth”和“wherefore”这样的词的机会增加。

在训练过程中,模型会学习语言中的这些模式,最终成为专家!

但这就足够吗?学习语言规则足够吗?

语言很复杂,一个词根据上下文可能有多种含义。

因此,自注意力。简而言之,自注意力是一种由LLMs使用的技术,用于理解句子或文本中不同单词之间的关系。就像你在故事中关注不同部分以理解其含义一样,自注意力允许LLMs在处理信息时将更多重要性赋予句子中的特定单词。这样,模型可以更好地理解文本的整体含义和上下文,而不仅仅是依据语言规则盲目预测下一个单词。

如果LLMs只是用于预测下一个单词的计算器,那么它如何能回答我所有的问题呢?

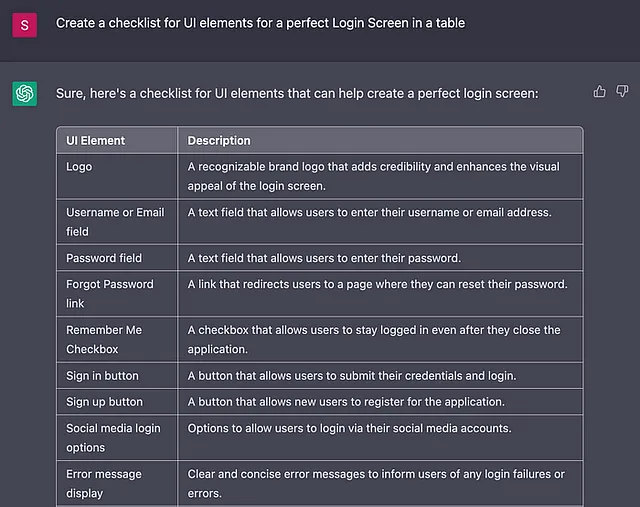

当您要求一个大型语言模型做一些聪明的事情——并且它成功了——有非常大的可能性是因为您要求它做的事情它已经见过成千上万个例子。即使您提出了一些非常独特的东西,比如:

写一首关于虎鲸吃鸡的诗给我

在波浪之中,一道看不见的景象,一只虎鲸迅猛敏捷地捕猎,大海的领域中,舞蹈开始了,就像一只鸡的命运,虎鲸胜出了。

用强大的颚部,它袭击着猎物,羽毛漂浮,漂离远方,在大自然的方式中,一个故事被编织,生与死融为一体。

~聊天GPT

相当不错,对于其自我关注机制,它能够有效地融合和匹配相关信息,构建出一个有说服力且连贯的回答。

在培训过程中,LLMs学会识别数据中的模式、关联和词语短语之间的关系。由于经过了大量的培训和细微调整,LLMs能够展现出一些 emergent properties,比如能够进行语言翻译、摘要、问答甚至创造性写作。这些能力通常超越了模型中明确编程的范围,并且表现得非常出色!

大型语言模型是否智能?

该电子计算器已经存在了六十多年。虽然这个工具自身有了长足的改进,但从未被认为是智能的。为什么呢?

图灵测试 - 图灵测试是一种看似简单的方法,用于确定一台机器是否展现出类似人类的智能:如果一台机器能够以与人类难以区分的方式与人进行对话,那么它被认为具备人类的智能。

计算器从未接受过图灵测试,因为它不会使用与人类相同的语言进行沟通,只懂得数学语言。另一方面,LLMs 生成人类语言。它的整个训练过程都围绕模仿人类语言展开。因此,它能够“以与人类无法区分的方式与人类对话”并不足为奇。

所以,用“智能”这个词来描述LLMs有点棘手,因为对于智能的真正含义没有明确的共识。一种考虑是否具有智能的方法是它是否能够执行有趣、有用且不太明显的任务。LLMs符合这一类别。不幸的是,我完全不同意这种解释。

我将智能定义为扩展知识边界的能力。

根据编写本文时的情况,一个经过训练的机器仍然无法扩展知识的边界。

但它可以在经过训练的数据上进行插值。它对单词背后的逻辑或存在的知识树没有明确的理解。因此,它永远无法生成离群的想法和深刻的洞察力。它总是会提供相对平均的连贯答案。

那么,这对我们人类意味着什么?

我们应该把LLMs更多地看作是一个词汇计算器。永远不要完全将你的思维外包给语言模型。

同时,随着这些模型的指数级提升,我们可能会感到越来越无所适从和微不足道。对此的解药是始终对看似无关的观念保持好奇心。这些观念表面上看起来不连贯,但基于我们与周围环境的相互作用却是有意义的。目标是生活在知识的边缘,创造并连接新的个别事实。

如果您在这个层面上运作,所有形式的技术,无论是计算器还是大型语言模型,都会成为您随时可用的工具,而不是您需要担心的存在威胁。