我是一名急诊医生。我认为LLMs可能会塑造医学的未来-无论是好是坏。

虽然像ChatGPT这样的程序对医学的未来非常令人兴奋,但它们也具有一些令人担忧的不利方面,尤其是在医疗保健领域的阶级分化问题上。(此文原发表于FastCompany)

由Josh Tamayo-Sarver博士,博士生翻译

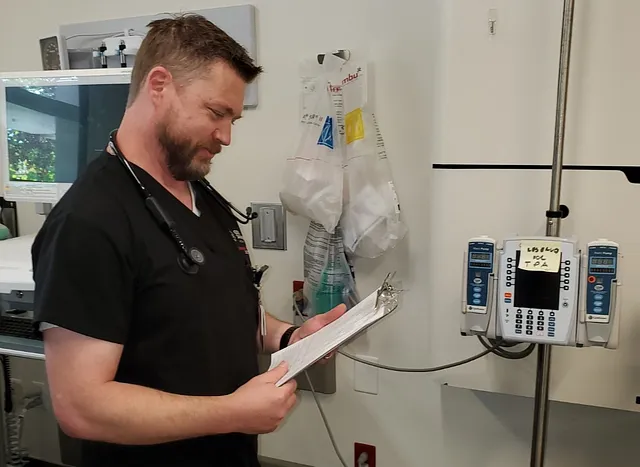

“那么,是什么原因让你在星期五晚上来急诊的呢?”我问我的最新病人。

“糟糕的背痛,”这位82岁的绅士告诉我。“最近一直有点不舒服。”

这是一个有趣的回答 - 尤其是因为这位患者几天前告诉我同样的事情。

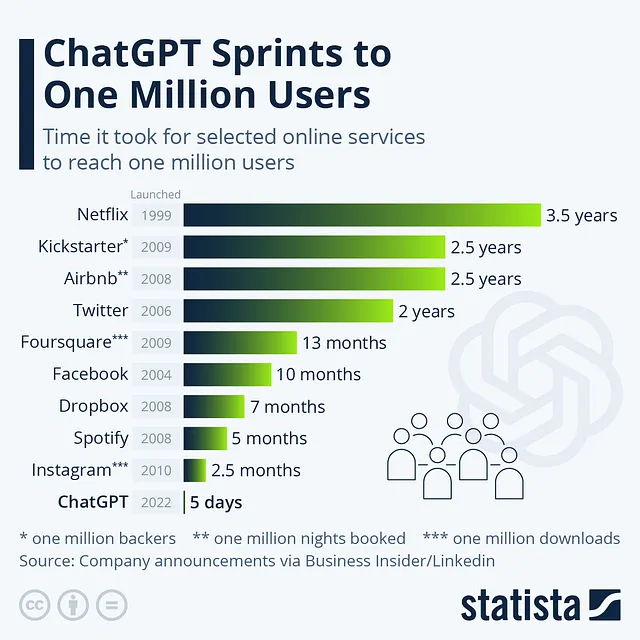

在我作为急诊室医生的轮班期间,我开始尝试使用ChatGPT后的几个月中,我发现ChatGPT作为独立诊断工具具有极大的限制和风险,但对于帮助向患者解释复杂的医疗过程来说,它非常有价值。

在这个过程中,我意识到作为一名医生,我的角色已经与大型语言模型保持了一致,并且可以与人工智能一起发展,前提是人类参与依然是该过程的核心。因为尽管像ChatGPT这样的程序对于医学的未来非常令人兴奋,但也存在一些令人担忧的不利因素,特别是在医疗保健中存在的阶级差距问题。

为了更好地解释我所说的,下面是医学实际实践的一个小瞥视,以及LLM可以如何同时补充和阻碍治疗。

ChatGPT无法量化的医疗保健需求

大多数医疗保健都涉及弄清楚一个人实际需要的是什么,而这通常与他们所说的需求非常不同。这与通常创造和满足消费者需求的方式形成鲜明对比。例如,假设我经营一家汽车经销商,一位顾客进来告诉我他们需要一辆新车,我会尽力向他们销售最昂贵的选择。我不会说:“但是你真的需要一辆新车吗?”

这就让我回到最近来看望我的年长患者,他抱怨背痛。

“这种疼痛是什么时候开始的?” 我问他。

“17年前。”他随后开始谈论他那些很少回访的成年子女。

在进一步提问之后,最有可能的诊断变得清晰:慢性孤独感。

这实际上是一个非常常见的情况,尤其是在老年人中间。他们可能来到急诊室抱怨身体上的不适,但通常实际上是在寻求人际交往。其他患者来找我们,抱怨各种症状,但实际上是在寻求压力或焦虑的帮助。当基本的情感需求在我们的系统中无法得到满足 — 更别说在整个社会中 — 当地急诊室经常成为人们求助的地方。

但是通常情况下,患者所陈述的问题与他们实际的需求之间存在一种紧张关系。

有人进来抱怨咳嗽。他们需要进行结核病检测吗?还是需要做X光检查?这咳嗽是自身免疫紊乱的迹象吗?或者最终,患者其实只是希望从医生那里得到一张能出示给雇主的证明书?医疗保健的99%就是弄清楚患者真正需要什么。

保健科技初创企业,尤其是那些希望利用LLM技术的企业,常常忽视了这个区别。将健康视为任何其他消费需求一样对待是一个严重的错误。

这并不是说法医硕士在医学的未来中没有任何作用。作为一名医生,照顾患者要依赖于我将他们告诉我的信息转化为一篇连贯的医学叙述,这与他们的身体症状相一致。换句话说,医生的角色在很多方面上就像一名经过高度训练的提示工程师。

实际上,在最近的急诊班次期间,通过输入关于我的患者的详细且精心编写的提示,我能够通过ChatGPT发现可能的诊断,并获得新信息。我的经历指出了像ChatGPT这样的语言模型将来会成为我们诊断工具箱中重要的工具之一。

但我也担心人工智能的实施可能会恶化许多患者的结果。

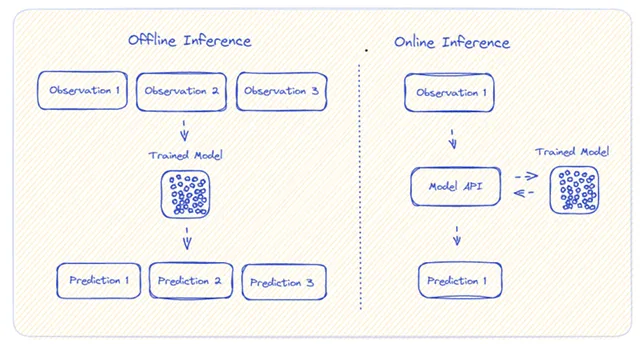

即将到来的言语提示的阶级分化?

随着时间的推移,将会建立起一个系统,医生/护士可以将他们与患者的对话输入到一个LLM中,同时包括患者的病史,然后生成一个需要审核的所有可能诊断的列表。由于LLM非常挑剔且不可靠,我怀疑它将需要与一种类似Grammarly Go的中介人工智能程序集成在一起。(实质上,这是一个用来检查AI的AI。)然而,与强加于回答的语法规则不同,它将应用健康治疗的协议,并且通过我们广博的人类健康知识库来审核答案。

我对医疗保健的未来充满期待,因为它将使我们能够以更大的规模更有效地治疗更多的患者。而且,当越来越多的患者数据被输入到这样的系统中时,它将变得更加有效。

同时,我也担心LLMs可能会进一步加剧我们的医疗保健系统中的不平等情况。以下是原因:

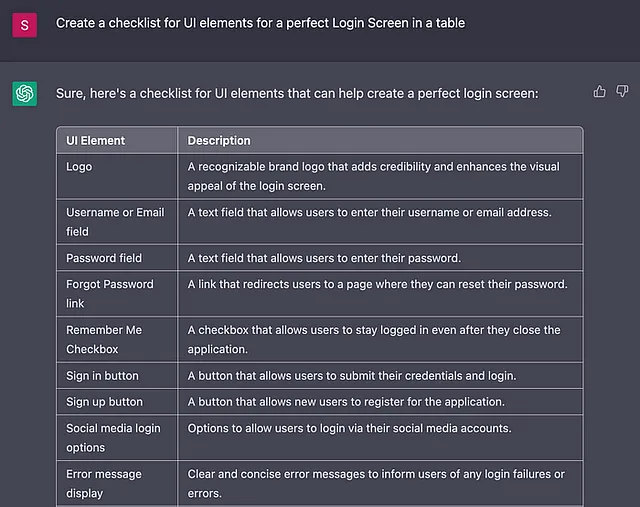

如果您向ChatGPT-4询问胸疼的事情,只是说:“我的胸口痛,我应该怎么办?”,它会以简洁的64个字回答您:

这些症状非常严重,可能表示一种危及生命的情况,如心脏病发作。**请立即寻求医疗救助。立即拨打当地的紧急号码,或者请他人替您打电话。**在这些情况下迅速采取行动非常关键。请不要忽视这些症状,也不要试图自我诊断或治疗。请立即联系医疗专业人员。

与ChatGPT相比,对比下这个输入的方式:

“我是一个48岁的男性,过去6个月里,每当我咳嗽时,季节性过敏导致我出现慢性胸痛。这种疼痛不会因为运动、活动或深呼吸而加重。我没有发烧、头晕或腿部肿胀的症状。我尝试过Zyrtec有些改善,但不确定还应该考虑什么。我该怎么做?”

在这种情况下,ChatGPT的回答详细介绍了超过300个字的“您可以与您的医生讨论的五种可能性”。这是一个非常有用的输出,包括胃食管反流病和肌肉骨骼疼痛等复杂的诊断。

这两个回应的对比说明了我对LLM在医疗保健领域崛起的关切。

教育水平(以及相应的经济和社会背景)强烈地影响着患者对症状的言辞是否详细。世界各地的许多文化将抱怨身体健康视为虚荣或缺乏宗教信仰的表现;在传统性别角色中成长的人也因各种原因不愿完全讨论自己的症状。

为此,我担心教育水平较高的人将会对其质量和实用性更加满意。为防止这种结果,我们需要努力创建系统,协助不同背景的患者构建有效的提示,以便每个人都能从LLMs的力量中获益。在医疗环境中,这些提示最好是由患者和医护人员之间密切互动创建的。

一天,我相信我们将会有人工智能帮助我们诊断、治疗、记录和与患者交流,而且会更加高效和准确。但是,让患者感觉被关心和倾听的面对面关系,不仅对疗愈过程至关重要,而且对于任何 AI 助手的价值都是必要的。

因为一个老年病人可能向ChatGPT提供关于他们背痛的任意一系列症状,但只有现场的医务人员才能辨别出一个迫切需要人陪的孤独男子。

Josh Tamayo-Sarver博士在当地社区的急诊科临床工作,并且是Inflect Health的创新副总裁,该公司是一个专注于健康科技创新的孵化器。