AI最佳实践和考虑因素:一位机器学习产品负责人的观点

专家建议降低风险并最大化生成性人工智能的好处

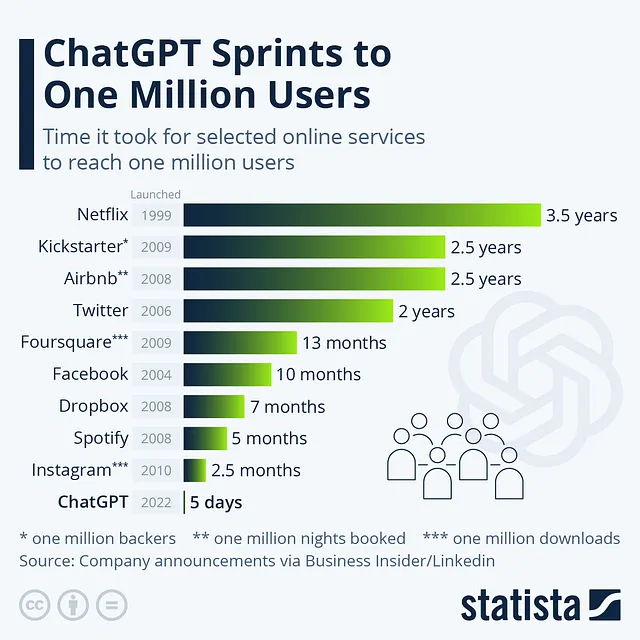

生成型人工智能(GenAI)和因此产生的大型语言模型(LLMs)在今年在企业领域引起了极大的关注和注意。这种炒作承诺了具有灵活性、适用于各种行业并具有高度能力的转型应用。作为一个支持“传统”机器学习产品发现、设计、调优、部署和监控的人员,我对像GenAI这样具有高度灵活功能的前景感到兴奋。然而,我认为在企业部署中传统机器学习所面临的许多挑战和障碍仍然存在,并且与所有GenAI用例交叉。通过在开发和部署过程的每个阶段融入最佳实践并提出关键问题,我们可以减轻风险并最大化GenAI的好处。

我想提醒一下,本文并不侧重于GenAI和LLM的能力,因为关于这个话题已经有大量可信的资料了。然而,作为一个组织的领导者,我们鼓励您建立对GenAI能力的基本理解,例如精确调优的质量保证、文档搜索、概念分析、代码开发支持、代码调试、文本摘要等等。此外,了解ML和GenAI输出的性质很重要,它们是“预测”或者是最佳猜测,可能完全正确,也可能部分正确或者完全错误。这种性能的范围以及与成功和风险期望之间的相关性都是关键考虑因素。GenAI之所以受欢迎是因为它们经常能够以小的努力实现“接近正确”,从而证明其令人兴奋之处。

最佳实践和关键问题

考虑到炒作周期,让结果驱动解决方案,而不是工具。

围绕GenAI的炒作可能会有益也可能有害。一方面,炒作会引起对新工具的关注,并促使各利益相关者愿意采用它们,从而推动对新用例的探索、实验和改进。另一方面,炒作也会引来批评,有时甚至导致对工具像GenAI的反感,并需要对证据和意见的全面审查。作为GenAI的采用者,我们必须谨慎地应对炒作周期,并利用它来推动有意义的影响,同时在我们的组织中管理风险。

GenAI有时候感觉就像一把大锤子,每样东西都像钉子。然而,在这个比喻中,重要的并不是钉子本身,而是当它们被放置在需要的地方并被谨慎使用时,所创造的东西。任何GenAI部署的真正衡量标准是它对业务的影响,这可以通过关键指标如收入、交付时间、客户获取成本和运营成本来衡量和追踪。

在考虑工具之前,你应该问自己一个问题,你可能已经有了一系列的答案:对于我的业务成功来说,最大的瓶颈是什么?然后,一个能干的机器学习产品团队可以帮助设计一个解决方案,改善那些受到瓶颈影响的指标。

早期确定成功标准,并根据新信息进行修正。

- 为什么使用这个案例?

- 如果成功的话,这个用例会实现什么样的商业成果?

- 这个GenAI/LLM应用案例的可衡量的成功定义是什么?

- 我们将如何衡量企业成功的度量指标和解决方案模型的成功度量指标?

- 我们将以多频率进行测量?

- 这种度量标准与我们组织的成功衡量方式相吻合吗?

您无需一开始就拥有所有确切的答案,但通常启动基于机器学习的解决方案的组织往往难以为这些问题中的任何一个明确定义标准。这些标准会随着从概念验证(PoC)到试点以及生产的新发现而发展演变,但您需要从某个起点开始,并考虑它们基于新的信息可能需要如何变化。报告这些变化的影响。否则,任何机器学习或GenAI实施的成本很快会成为那些追踪头部指标的人痛点。

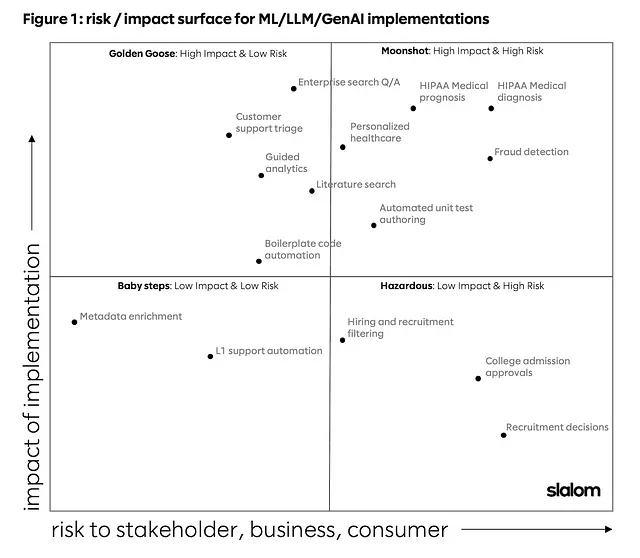

请考虑您所选用例候选的风险和影响权衡。

ML应用程序在始终需要考虑其预测结果的风险和影响之间的权衡(图1),这通常被称为模型风险管理(MRM)。现在同样适用于任何GenAI使用案例。例如,自动医学诊断具有很高的影响力,但风险非常高,而低优先级的内部IT工单分派可能有较低的影响力和风险。然而,可能有一些罕见但适时的情况,一个看似简单的任务可以具有高影响力而没有高风险,前提是可以在您的组织内管理不正确的预测。这种高影响力和低风险的低悬果应成为您使用案例发现团队的宗旨。这是黄金鹅的场景,其他使用案例在风险和影响象限的其他地方传播。

随着您构建GenAI案例的候选集,深入讨论和角色扮演风险情景。这可能包括安全风险、注入风险、性能阈值风险、技能和可行性、开发时间表风险、模型性能漂移、非计划的边缘情况风险。这个在机器学习部署中已经证明有效的最佳实践,也应被视为GenAI实施的基本方面。

例如,关于性能风险,在之前的机器学习实施中,我们的团队为一家保险公司开发了一个自动理赔解决方案。我们进行了广泛的讨论,研究缩短理赔时间与错误支付赔偿之间的影响。为了解决这个问题,我们帮助该组织建立了金钱/风险阈值以及潜在理赔的申请量,这些申请如果理赔错误可能会带来较低的风险,但仍会通过时间和吞吐量方面的大量成本节省为该组织带来利益。甚至确定PoC后的成功阈值的过程也可能成为对开发时间表的风险。我们始终需要考虑过度投入于可能无法实现的性能带来的风险,以及如何定义“足够好”。对于“完美”的不断追求是“影响”的敌人,可能导致对模型进行不断微调、寻找新的训练数据等等的来回调整,这些工作都可能将模型从最初的六周开发时间线延长到一个季度、半年或更久。请记住所有这些风险,而不仅仅是明显的风险。

这种风险管理的过程和方法应该扩展到GenAI实施中,无论是用于内部还是外部目的。此外,这个过程应该产生直接可衡量的指标,促进对包括发现、设计、构建、部署和监测成本在内的投资回报率的清晰理解。此外,对风险的这种衡量考虑应该成为你们成功标准的一个组成部分。

太长不看

虽然GenAI在机器学习产品生态系统中提供了巨大的机会,但关键是以批判的心态和对GenAI解决方案如何与组织的成功和风险测量相一致的认识来对待其采用。通过理解炒作周期,鼓励明确的预期结果,并通过最佳实践解决挑战,我们可以充分利用GenAI的潜力,创造有影响力的企业解决方案。在未来的系列中,我们希望涵盖GenAI作为数据产品、劳动力和运营模式项目,以及与GenAI和LLMs相关的其他关键跨实践的最佳实践和考虑事项。

深入研究以下任何一个主题。我们可以分享观点,提出正确的问题,并讲述我们的经历故事。

致谢:Chris Kercher、Nabor Reyna、Eugene Goei

Slalom 是一家全球咨询公司,致力于帮助个人和组织打造更美好的未来,实现更大的梦想、更快的进步。了解更多信息,请立即联系我们。