ChatGPT的知识只有两年:如果您正在构建应用,应该做什么?

官方公告:从今天开始,ChatGPT的知识截止日期为两年前。

为什么OpenAI不只是更新它呢?

有一些基本原因导致这样,培训新的LLM是一项昂贵的过程,至少需要数千万元,并且没有保证。清理用于培训的新数据集也是昂贵的。

如果我正在构建一个需要更近期数据的应用程序,我应该做什么?

您可能会诱惑着只是将整个2022年和2023年的维基百科页面发送给ChatGPT:https://en.wikipedia.org/wiki/2022。不过您很快会遇到两个限制:1.对于大型语言模型(LLM),您可以发送的字数是有限制的,这被称为“上下文窗口”。2. LLM API会按照发送的字数收费,所以您发送的内容越多,您的API调用就会变得更加昂贵。

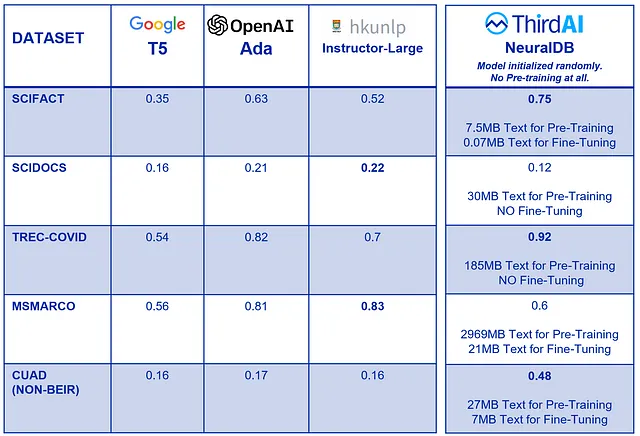

标准技术之一被称为“检索增强生成”或RAG。简而言之,它是搜索合适的背景信息,将该背景信息提供给LLM,然后获得更好的结果的过程。

在LlamaIndex,我们是RAG专家,但是有一个整个开源项目社区正在解决这个问题。我们已经与20多个开源向量数据库进行了集成,并且还有其他开源工具,如LangChain、Semantic Kernel、DSPy、Axilla等等(在评论中分享你喜欢的项目!),它们以不同的方式来解决这个问题。

另一种技术称为微调。在这里,您基本上是在现有的 LLM 上创建一个新的定制模型。虽然 LlamaIndex 支持微调,但通常需要更多的工作和数据。

如果我不需要更新的数据怎么办?

这完全没问题!并不是每个应用都需要比2021年更近的数据。在LlamaIndex之前,我曾在一个开源的阅读教育工具上工作过,而语音学在过去两年中绝对没有改变。如果你正在构建一个编写晚间故事的工具(❤️ Kidgeni https://kidgeni.com/)或说唱的工具(请查看TextFX!https://textfx.withgoogle.com/),你的应用

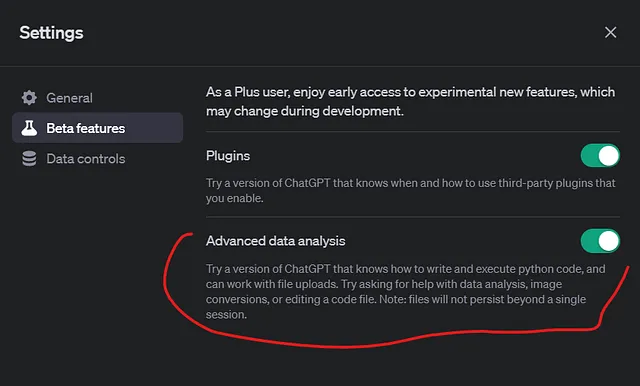

如果我只想使用ChatGPT获取更近期的信息怎么办?

目前有很多使用检索增强生成技术的聊天机器人。我个人尝试过的几个是Metaphor (https://metaphor.systems/)、Perplexity (https://www.perplexity.ai/)和Medisearch (https://medisearch.io/),当然还有Google Bard和BingGPT。