不再玩AI捉迷藏:深入了解可解释AI(快速版)

关于XAI,你应尽快学习的5个原因。

好了,闲聊以后再说!现在让我快速介绍一些影响你日常生活的情况,你会要求解释并且为什么你应该学习可解释的人工智能技术(XAI)。

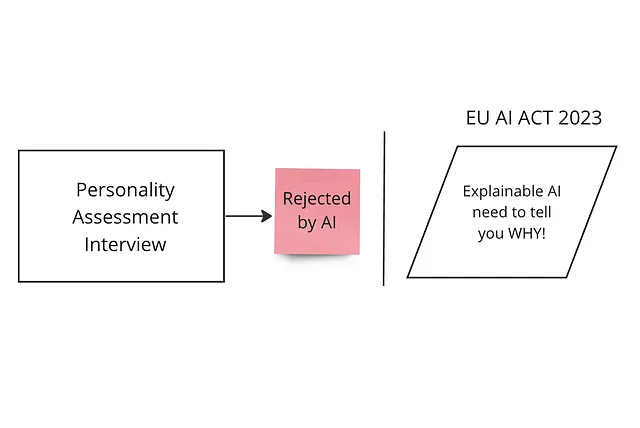

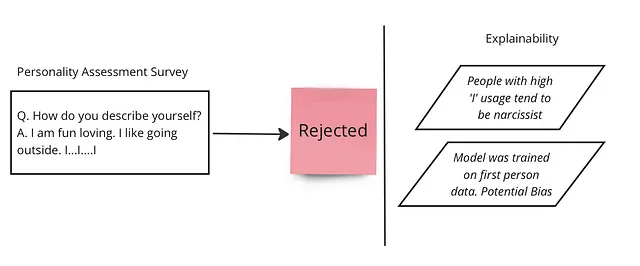

1. 面试被拒:尽管您是个好人,并且回答得很真诚,但您的人格测试得分却不高。人力资源部告诉您:“好吧,我们的系统告诉我们您不适合。抱歉,这是自动化的,我无法控制。嗯!”根据法律规定,您应该能够要求了解他们的算法如何运作以判断是否存在偏见问题。

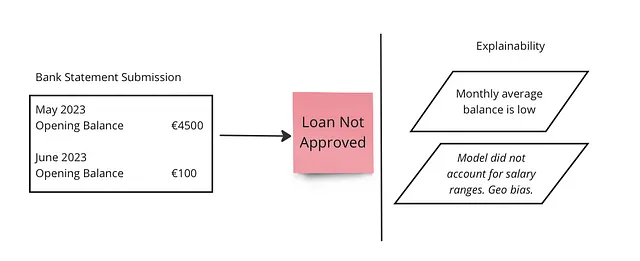

2. 不公平的信用评分:你申请贷款,却因为信用评分低而被拒绝,尽管你一直负责理财。银行告诉你,它的决定是基于自动信用评分系统做出的。有了可解释人工智能(XAI),你有权要求解释算法是如何得出这个决定的,从而能够确定是否存在影响结果的任何偏见或错误。

3. 未解释的医学诊断:您从医学AI系统接收到了一个诊断,但所提供的解释不清晰或缺乏透明度。借助XAI,您将能够请求解释诊断背后的推理,确保您理解所考虑的因素,并能做出有关您的医疗保健的明智决策。

4. 不合理的保险索赔拒绝: 您为一次有效的事故提出了保险索赔,但却被自动理赔系统拒绝。通过使用XAI要求解释,您可以了解系统如何评估您的索赔,从而让您可以挑战可能导致拒绝的任何不准确或有偏见的问题。

5. 不可靠的产品推荐:您依赖于一种AI推荐系统来建议产品或服务,但是您经常收到不相关或不令人满意的建议。有了XAI,您可以要求解释为什么会做出某些推荐,从而使您了解其基本标准,可以提供反馈来提高系统的准确性。

从想象和墨水时代开始,人工智能 (AI) 只是艾萨克·阿西莫夫等人笔下的一个幻想概念,我们已经走了很长一段路,到了一个AI不只是一种新奇玩意,而是我们日常生活的一个不可或缺的组成部分的世界。从我们iPhone上的Siri到精密的图像识别工具和开创性的医疗诊断,AI已经编织进我们的生存。然而,我们大多数人并不知道这些智能系统是如何完成它们的工作的。这就是可解释的AI(亲切地称为XAI)登场的地方。

可解释人工智能是什么?

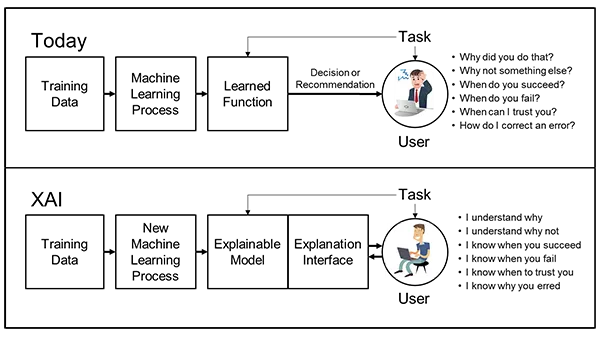

在最简单的术语中,XAI 就是要从人工智能中揭开神秘面纱。它关注我们的人工智能同行所做决策的原因和方式。XAI 关注于在人类和人工智能系统之间建立一个明确的双向街道,一个我们这些凡人可以在其中弄清、信任和有效管理这些虚拟半神的地方。

解释性为什么很重要?

人工智能系统,特别是那些核心采用深度学习的系统,以它们的黑匣子形象而著称。

他们做出了决定但没有透露。缺乏透明度可能引发简单的耸肩或者带来严重的道德、法律、安全问题。想象一下人工智能系统决定谁应该获得贷款或者自动驾驶汽车做出生死攸关的决定,我们需要紧急了解选择背后的逻辑。

我决定写这篇文章的真正原因是即将出台的欧盟AI法案,该法案将使得可解释性人工智能(XAI)不仅仅是重要的,而是强制性的。

在医疗保健、国防和金融等领域,情况变得复杂起来。在这些领域,人工智能决策可能会颠覆生活。确保这些决策不仅仅基于相关性而是因果关系至关重要。此外,可解释性拥有将人工智能纳入控制的潜力,有助于准确定位和纠正偏见,从而实现更公正的人工智能社会。

幕后的魔力:可解释人工智能是如何运作的?

现在,解释人工智能是一个双向的道路:一个车道是用于“事后”解释,另一个车道是用于“固有可解释性”模型。

事后解释

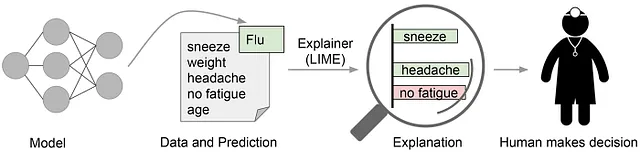

简单来说,事后技术主要关注“为什么这样做”。为什么AI系统会做出那个决定?这些技术通常利用数据可视化或文本解释来帮助人们理解AI的工作原理。例如,局部可解释的模型无关解释(LIME)能够创建易于理解的模型,解释不同特征如何影响AI的最终决策。

*固有可解释性模型*

相反,本质可解释的模型是AI中的开放书籍。它们从一开始就被设计成易于理解。想想决策树、线性回归、基于规则的系统等等。但是请记住,尽管我们热爱透明度,但通常在复杂性和可解释性之间需要权衡。

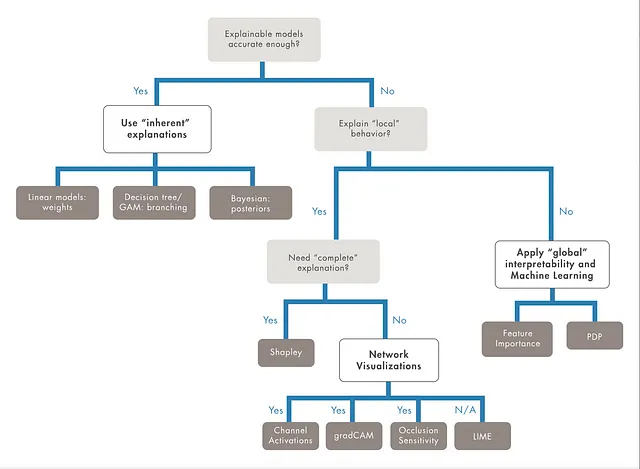

要理解“决策树”这种固有可解释模型,只需查看下一节中的图像。

如何选择合适的可解释性方法

我用Matlab发现了一些非常有趣的数据:

XAI 的挑战和下一步工作

通向透明人工智能的道路并非易如反掌。这是在尽可能提高AI准确性的同时确保它不会变成一种晦涩难懂的占卜工具的微妙平衡。此外,我们需要满足技术极客和新手都能理解的解释,这本身就是一个具有挑战性的任务。

然而,我们也不要忘记其中的好处。XAI 不仅仅是关于提高人们对人工智能的信任和道德行为,也是关于提高其效率、可靠性和整体的利益的。在我们与人工智能越来越共存的世界中,要让它们能够解释、理解和负责任,这不仅仅是一种美好,而是必不可少的。所以,让我们为一个我们能够更好地了解我们的人工智能伙伴并更少地不信任它们的未来干杯。

以下是几个最近且好的链接,可让您了解可解释人工智能:

- “什么是可解释的人工智能(XAI)?”由IBM提供[https://www.ibm.com/cloud/learn/explainable-ai]

- “解释性人工智能(XAI)在银行业的应用” 由德勤洞察发表 [https://www2.deloitte.com/us/en/insights/industry/financial-services/explainable-ai-in-banking.html]

- “可解释人工智能:理解深度学习的限制” 由Nature [https://www.nature.com/articles/s42256-020-00256-9]

- “可解释人工智能:机器学习可解释性方法综述” 来自机器人与人工智能前沿期刊 [https://www.frontiersin.org/articles/10.3389/frai.2021.708648/full]

- “可解释AI的前5种技术”由Towards Data Science发布[https://towardsdatascience.com/top-5-techniques-for-explainable-ai-d682aac2f716]