在 Azure 中的模型选择

选择正确的机器学习模型并使用文件类型来优化数据存储

介绍

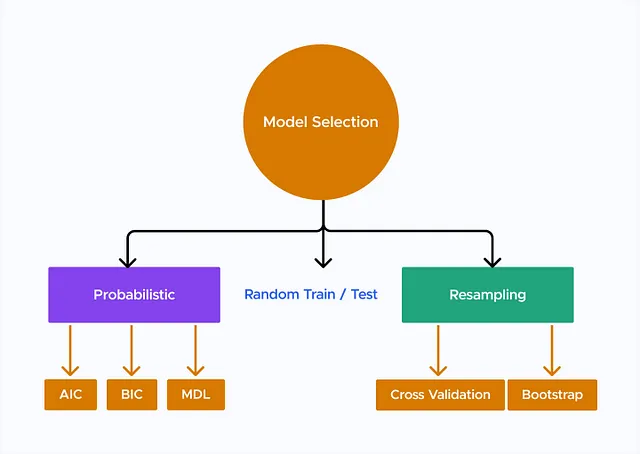

构建机器学习解决方案的关键步骤之一是选择最适合您的数据和问题域的正确模型。Azure Machine Learning提供了各种算法和模型可供选择,因此了解模型选择过程中涉及的因素和考虑是至关重要的。在本文中,我们将探讨在Azure中选择模型时需要考虑的关键细节,并提供相关的代码示例。此外,我们将讨论在Azure中存储和管理数据的常用文件类型,并解释基于不同情况应该使用哪种格式。

选模型的考虑因素

- 问题类型:您的问题性质将指导机器学习模型的选择。它是分类问题,您需要预测离散类别,还是回归问题,您需要预测连续值?了解问题类型将有助于缩小适当模型选项的范围。

- 数据集大小:数据集的大小在模型选择中扮演着至关重要的角色。对于较小的数据集,简单的模型,如线性回归或朴素贝叶斯,可能效果良好,这些模型具有较少的参数。另一方面,对于更大的数据集,可以考虑更复杂的模型,如深度神经网络或集成方法。

- 特征空间维数:你输入的特征维度会影响模型的选择。对于高维数据,像支持向量机(SVM)或随机森林等算法可以有效处理特征之间的交互。相对地,对于低维数据,线性模型或决策树可以提供令人满意的结果。

- 可解释性:根据您的需求,您可能会将模型可解释性作为优先考虑因素。与深度神经网络等黑匣子模型相比,线性模型、决策树或逻辑回归通常更易解释。如果可解释性至关重要,则选择提供透明度的模型变得至关重要。

- 模型复杂度:需要考虑模型复杂度和性能之间的平衡。简单的模型通常易于避免过拟合,但可能具有有限的表现力。像深度学习这样的复杂模型可以捕捉复杂的模式,但需要更多的数据和计算资源。

代码:模型选取

让我们考虑一个分类问题,并演示如何使用Azure机器学习选择模型。在这个例子中,我们将使用著名的鸢尾花数据集,其中包含鸢尾花的测量值及其对应的物种。

from azureml.core import Workspace, Experiment

from azureml.train.automl import AutoMLConfig

# Load the Azure Machine Learning workspace

workspace = Workspace.from_config()

# Define the experiment

experiment_name = 'model-selection-experiment'

experiment = Experiment(workspace, experiment_name)

# Define AutoML configuration

automl_config = AutoMLConfig(task='classification',

primary_metric='accuracy',

training_data='iris_data.csv',

label_column_name='species',

iterations=5,

experiment_timeout_minutes=10,

enable_early_stopping=True)

# Run the AutoML experiment

run = experiment.submit(automl_config)

run.wait_for_completion(show_output=True)

# Retrieve the best model

best_run, fitted_model = run.get_output()

# Evaluate the best model

metrics = best_run.get_metrics()

print('Best Model:', metrics['model_name'])

print('Accuracy:', metrics['accuracy'])在上面的代码中,我们首先加载Azure机器学习工作区并定义一个用于模型选择的实验。然后,我们通过指定任务为分类,将主要指标设置为准确性,设置训练数据文件(例如,‘iris_data.csv’)和标签列名称(‘species’)来配置AutoML。我们设置迭代次数和实验超时以限制训练时间。最后,我们提交AutoML实验,检索最佳模型并评估其性能。

Azure上的机器学习文件类型

现在,让我们讨论在Azure中用于存储和管理数据的常用文件类型。选择正确的文件格式对于高效的数据存储、处理和与不同的Azure服务的兼容性非常重要。以下是三种流行的文件类型:

CSV(逗号分隔值):CSV文件以纯文本格式存储表格数据,因此使用各种工具和编程语言轻松导入和导出 。在处理表格格式的结构化数据、在应用程序和平台之间共享数据或处理小到中型数据集时,请使用CSV文件。 在下面的代码片段中,我们将使用Azure Machine Learning SDK加载名为“data.csv”的CSV文件并创建数据集对象。 然后,我们可以将数据集转换为Pandas DataFrame以进行进一步的处理和分析。

代码:在Azure机器学习中加载CSV文件。

from azureml.core import Dataset

# Load CSV file as a dataset

dataset = Dataset.Tabular.from_delimited_files(path='data.csv', separator=',')

# Convert dataset to pandas DataFrame

data = dataset.to_pandas_dataframe()镶嵌地板(Parquet):镶嵌地板是一种柱状存储文件格式,提供高效的压缩和编码技术,适用于大数据工作负载。镶嵌地板文件对于读取和写入大型数据集都非常高效,因为它们通过有选择地访问感兴趣的特定列来将I/O操作最小化。

在下面的代码片段中,我们创建一个 pandas DataFrame 并将其转换为 Azure Machine Learning 数据集。我们使用 register_pandas_dataframe() 方法将数据集注册为 Parquet 文件,并保存到目标位置。这使我们可以将 DataFrame 存储为 Parquet 文件,以进行高效的处理和分析。

编码:在 Azure 机器学习中将 DataFrame 写入 Parquet 格式

import pandas as pd

from azureml.core import Dataset

# Create a pandas DataFrame

data = pd.DataFrame({'column1': [1, 2, 3], 'column2': ['A', 'B', 'C']})

# Convert DataFrame to dataset

dataset = Dataset.Tabular.register_pandas_dataframe(data, target='parquet_data', name='parquet_dataset')

# Save DataFrame as Parquet file

dataset.download(target_path='parquet_data', overwrite=True)Avro:Avro是一种二进制数据序列化系统,提供了一种紧凑和高效的文件格式来存储结构化数据。Avro文件具有自描述性,因为它们包括文件本身的模式定义。这使它们适用于数据模式的灵活性和兼容性至关重要的情况。在下面的代码片段中,我们将使用Azure机器学习SDK加载名为"data.avro"的Avro文件并创建数据集对象。然后我们可以将数据集转换为pandas DataFrame进行进一步分析。

代码:在Azure Machine Learning中读取Avro文件

from azureml.core import Dataset

# Load Avro file as a dataset

dataset = Dataset.Tabular.from_parquet_files(path='data.avro')

# Convert dataset to pandas DataFrame

data = dataset.to_pandas_dataframe()结论

选择正确的机器学习模型在Azure中是建立成功预测解决方案的关键步骤。通过考虑问题类型、数据集大小、特征维度、可解释性和模型复杂性等因素,您可以做出明智的决策。Azure Machine Learning提供了广泛的算法和模型,并且通过提供的代码示例,您可以开始探索和选择最适合您特定需求的模型。此外,了解Azure中的不同文件类型,如CSV、Parquet和Avro,可以实现高效的数据存储和处理。通过利用提供的代码示例,您可以在Azure Machine Learning项目中有效地处理这些文件格式。

参考文献

- 微软Azure机器学习文档:https://docs.microsoft.com/zh-cn/azure/machine-learning/

- 微软 Azure 文档:https://docs.microsoft.com/zh-cn/azure/