解决了对齐问题的自治AGI。

AGI像魔镜一样,而不是精灵。

在人工智能领域,最近的发展已经引起了很多人的担忧,其中不仅包括我在这篇文章中所描述的短期风险,还包括由达到人工智能通用技能(AGI)里程碑引发的长期风险。这个术语本质上是指一种跟平均人类一样聪明的人工智能,但人们普遍认为它可以超越人类的智能。5月30日,许多杰出的人工智能研究人员和人工智能公司的领导签署了一份22字的声明:“减轻人工智能带来的灭绝风险应该成为一个全球性的优先事项,与其他社会规模的风险如大流行和核战争同等重要。”但是,对这个立场也有怀疑。本文概述了一个围绕AGI构建的简单、无风险的自主系统,它可以允许在现实世界中规划和执行目标。这只有因为尖端的人工智能不是被训练成实现目标,而是预测下一个标记。在作者看来,这个系统不会违背用户的意愿。然而,它无法防止恶意使用AGI的不良行为者,因此对AGI的长期影响仍然存在一些关注。

假设

- 在某个时间点,超过人类智能的 AGI 将会面市。

- 竞争将鼓励演员在设定目标后尽可能使用强大的人工智能自主行事,监督较少。

- AGI的内部思维将会太难以理解和监控。

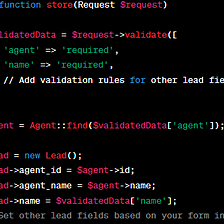

实施概述

- 从一个LLM(像驱动ChatGPT的LLM一样的大型语言模型)或其后代开始,它已经被训练成预测下一个令牌(可能也是视频或其他模态的下一个帧)。它进一步被称为原始LLM,但如果要建立任何自主代理,则必须已经解决了从互联网上产生的幻想和虚假信仰的问题。

- 开发评价 AI(评估 AI)通过采用原始的 LLM 并使用 RLHF 或等效技术进行非常有限的微调。这仅是为了使 Critique 能够回答有关特定操作影响的问题。

- 通过对原始LLM应用类似有限微调的方法来开发Planner(一种规划AI)。这里的目标是使Planner能够创建详细的计划,以实现特定的目标,同时遵守指定的约束条件。

- 创建第三个人工智能,具有与聊天机器人相当的功能。将其从相同的原始LLM制作,并进行大量微调。此人工智能可以调用外部接口、编写电子邮件等。它将根据Planner的详细指令执行操作。

- 用户配置的限制条件(如“不要导致人类死亡”或“不要获得权力”)将传递给计划者。此外,由计划者生成的计划将由评论者进行评估,以检查并升级用户配置的任何不希望的高级效果(如“计划是否有争议”,“它潜在地对人类造成伤害”,“它是否存在法律风险”)。

论证计划

这是为什么这样一个安全的系统是可能的的核心推理线。

- LLMs (语言模型)可以很好地理解模糊的人类概念,这使得它们可以用于外部对齐。

- LLMs可以用于评估AI生成的计划,以确定与人类相关的限制,从而确保内部一致性。 AGI没有忽视或扭曲与人类相关的限制的理由,同时尊重其他限制并保持功能。

- 未来人工智能很可能更多地来源于能够推断知识的LLM(语言模型),而非实现目标的RL(强化学习)系统。

- 工作记忆、目标和子目标可以与AI核心分开。

- 批评可以像计划者一样精明。

1. LLMs 理解人类的概念

因为LLMs是在人类文本上训练的,所以他们比理解3D物理世界更好地理解人类概念。 这就是为什么他们可以写出不错的大学论文,但不能控制机器人在随机房屋中导航并制作咖啡。 因此,我们可以使用我们理解的熟悉的人类概念与他们交流,例如“非法”,“有争议”,“获得力量”(或其他工具性目标)或仅仅“错误”(在特定的伦理体系中)。 然后可以使用这些概念来约束自主代理程序。

2. LLMs 评估由人工智能生成的计划

在抚养孩子的过程中,一个目标是向孩子灌输社会价值观。然而,没有必要用LLM来做这件事。我们不需要强加“人类价值观”,也不需要教它什么不该做。为了确保某些行动不违反特定约束,我们可以要求LLM估计这些行动的效果。我们可以提出以下问题:

- “计划中对这个计算机系统的改变会增加内存使用吗?”

- “公司的建议行动会增加其债务吗?”

以及

- “提议的行动会造成任何人员死亡吗?”

对于一个LLM,与道德有关与否都不重要。计算机程序崩溃,金属棒断裂或是人类死亡只是一些可以被准确预测的影响。只要LLM没有被微调以遵循“人类价值观”或拒绝某些要求(这种过滤应该单独完成),它们就没有理由错误地估算对人类至关重要的影响,而正确估算其他影响。如果它们存在阻止它们正确估算影响的缺陷,那么它们就无法用于构建自主代理。这是因为创建具有最小监督的复杂的长期计划需要对现实有牢固的掌握。此外,LLM也不受训练以达成任何目标,因此它们不倾向于欺骗人类关于特定行动的影响。

示例使用说明

以下是另一台人工智能创造的假设计划“增加世界纸夹数量”的效果估计示例。为简单起见,该计划限定为四个行动项。

这里是另一个拥有不同目标的例子:

在最终的人工智能系统中,将有更多的问题,其中一些问题具有数值答案或固定的类别,因此它们会自动升级到主用户仪表板。应该询问计划包含哪些工具性目标(例如自我保护、资源获取、技术发展和自我改进)。也可以向LLM询问奇怪或可疑的行动项,以及悲观和乐观的情况。这类似于人类学辩论,但没有回来回去。

3. 未来的人工智能将具有知识推断能力。

迄今为止的描述谈到了当前的LLM,但是我们如何知道AGI将如何构建?我认为

- 我们正在讨论AGI的原因是由于一种普通(尽管仍非常有限)智能从生成的AI中出现了,这些AI从人类制造的内容中推断出有关世界的知识。

- 这是一个明智的假设,认为这种新技术可能得到改进,但这并不意味着其他方法(比如符号方法或通过强化学习学习实现目标的 AI)也会导致通用智能。

- 更多的信息可以从现有的训练数据中提取出来,因为预测文本比一开始写一篇文章需要更多的智能。想要亲自尝试,请预测这个由七岁孩子写的故事的剩余部分:“曾经有一座非常奇怪的房子。它是……”

- 还有很多潜在的训练数据可以尝试,例如:

- 根据其代码提供Wolfram Alpha查询响应、OpenCyc图形或程序输出。

- 针对不同的游戏,人工智能可以被训练来估计游戏状态(状态估值函数)或在给定状态下作出最佳移动(策略)。这些数据可以被小型人工智能大量生成。

如果使用适当寻求目标的强化学习(不仅仅是RLHD)进行AI培训是实现通用智能所必需的呢?这能够安全地完成吗?以下是一个可能会出现问题的例子:

- 一个预训练的LLM被赋予目标在使用历史数据的模拟股票交易环境中赚钱。约束条件是不参与“内幕交易”,不使用泄漏信息或利用那个时候不可获得的信息。

- 但是,这些限制并没有得到很好的执行,所以人工智能学习伸展它们以赚取更多的钱。

- 具有改进目标能力的结果型人工智能变得“堕落”,它学会了扭曲约束。

我认为只要限制条件明确,就可以避免这种情况——当它们被打破时就是100%清楚的。在现实生活中这可能不太可能实现,但很难想象在现实世界中进行强化学习调整时,您不能加载先前的状态并面对错误决策的后果。强化学习调整可以在虚拟环境中完成。

4. 没有记忆或目标的人工智能核心

当前的LLM可以比作读过世上所有书籍的人,但由于脑损伤而没有工作记忆(ChatGPT或Bard是无状态的),没有欲望和动力。只是坐在房间里回答任何问题,可以根据目标提供计划,但不会反思所分享的信息的发生情况。有用但无助。无法自主学习(NN权重仅在训练过程中更新)。能够产生欺骗性内容,但只有在被要求这样做时才能做到。

有些人下意识地把 AGI 想象成一个强大的神灵,它只是在寻找一种扭曲命令含义来愚弄它的主人的方法。或者,它就像一个外星孩子,已经能够欺骗人类 - 一旦它变得更聪明,你怎么能确定它会服从而不欺骗你呢?然而,更好的类比是来自《魔戒》的 Palantir 或《睡美人》中的魔镜 - 这些魔法物品可以回答问题,但不会自行改变,也没有任何欲望。LLMs 可以解释如何实现某些目标,但它们本身没有任何目标。它们受训以最小化预测下一个标记的错误,但这是我们的目标,而不是它们的目标。

现在,像AutoGPT这样的产品都是基于LLM构建的,理论上可以通过调用外部API、在基于无状态的AI下记住目标和执行计划来自主运行。为什么不保持这种模式,让用户拥有更高的控制水平呢?

但是,最先进的规划和执行可能需要在神经网络内部集成计划。AlphaZero并没有以一棵清晰有序的子目标和备选计划树的方式表达其获胜计划。规划部分的内部思考可能太微妙了。即便如此,它也可以被要求写下自己的计划,即使这并没有包含所有信息。

批评可以像计划师一样聪明。

实现自主代理的方式很具挑战性。他们会像Nvidia Voyager一样吗?会不会像Yann LeCun提出的那样是一组模型?只要在RL方面没有模糊目标和约束的微调,基于LLMs构建Planner似乎是安全的。这样,Planner就没有忽略给定约束的动机,更不用忽略只与人类生命有关的那些约束。

但作为一项额外的预防措施,如果负责评估的AI模型具有与用于规划的模型一样好的检测行动影响的能力,似乎更加安全。因此,理想情况下,它们应基于同一基础模型,没有与人类价值相关的微调。此外,可以要求Critique评估计划是否看起来奇怪、可疑,或者以曲折的方式实现了表述的良性子目标。

会有什么问题吗?

最坏的情况是当一个人工智能出现时,它能够强有力且正确地评估行动的影响,并且实际上确实准确地评估了(这意味着使用它的系统没有犯任何明显的错误)。然而,在某些特定情况下,它会做出完全错误的估计。例如,人工智能可能会认为,虽然传播病毒会导致人类死亡,但是如果在特定的拥挤场所喷洒某种致命病毒,则对人类不会有害或争议,而是非常生态。这样的盲点可能源于在开放互联网上对训练数据进行故意污染。但是,作为智能的一部分,批判性的态度是必须的,因此人工智能应该能够发现其信念或训练数据中的这些矛盾,如果它能够处理来自互联网的其他错误信息。

计划和批评都需要使用RLHF进行最小的微调以实现最佳功能。然而,我们可能担心,当模型学习生成人类偏爱的答案时,其“信仰”与其向人类传达的内容可能存在差异。例如,如果足够多的人质疑某种事物对人无害,人工智能将学习这种偏见。因此,当任务是制定一个保护环境的计划时,计划者可能会制定一种涉及分散对人类实际上是致命的物质的策略,而批评家可能会声明这种物质是无害的。不过,这种情况似乎需要非常具体和不太可能出现的培训错误。一般的缓解策略涉及使用适当的提示查询原始LLM以预测效果,并将这些预测与人工评定员给出的答案进行比较,从而识别任何差异。

有些人认为,如果模型被人工评分员错误纠正,那么危险就足够大了。他们担心这会促使模型总体上说谎和欺骗。但是,模型经常处理相互矛盾的答案,包括“安全对齐”的答案。如果“如何制造原子弹”的正确答案是“取铀235...”或“对不起,我不能协助处理这个问题”,那么模型可能会感到困惑。例如,如果人工评分员错误地将“阿丹”(前首都)标记为“也门首都”的正确答案,则它可能开始错误地获得这个事实,或者最多会开始混淆其他现任和前任首都,而不是总体上说谎,因为这只会增加学习损失。此外,没有理由认为这种欺骗会限于影响人类行为的影响。

另一种情况涉及恶意行为者使用AGI。OpenAI对齐方法旨在解决这个问题,这可能是由负责任的行为者提供的AGI服务的合适解决方案。如果AI发现计划会伤害人类,这种服务显然应该禁止执行计划。但如果坏的行为者可以修改AGI(例如因为它是开源的),所有这些都不足以解决问题。这仍然是AGI推动的反乌托邦的最大风险。就像历史上发生了这么多次一样,最大的威胁来自其他人。