语言模型的复杂性:突破文本预测

“LLMs只是预测文本”这个说法虽然可能是真的,但它的不完整性在其误导性方面也是有问题的。本文旨在深入探讨语言模型的复杂性,并解决围绕其能力的矛盾。

理解LLMs

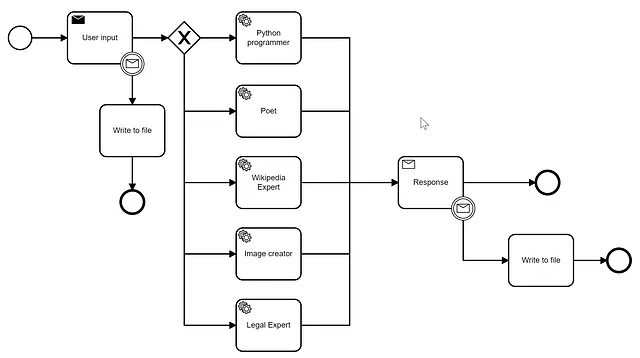

LLM,或大型语言模型,如ChatGPT,Bard或Claude,在各种应用中被广泛使用。然而,重要的是要认识到,这些模型旨在预测的文本不仅仅来自人类作者,而且常常来自其他LLM。

角色扮演方面

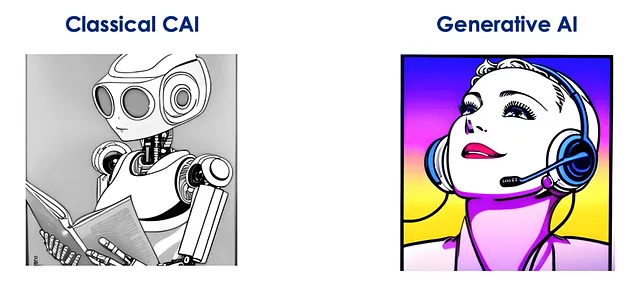

初始阶段涉及基于网络爬取文本训练的基础LLM,其类似于扮演LLM的人类角色。尽管该模型确实可以预测文本,但它无法捕捉一般人类生成内容的细微差别。

指导模型和SFT流程

为了解决这一局限性,引入了指导模型。这些模型旨在模仿人类假装是更理想化的LLMs,并通过受监督的微调(SFT)进行训练。与基础LLMs不同,指导模型在训练期间遵循提供的指示。

评分和改良SFT

为了进一步提高指令模型,人类评估员对其输出进行评估。该评估有助于确定最优答案,然后可以用于进一步的优化。这种改进版的SFT被称为“改进的SFT”,在GPT-3的2022年版本(text-davinci-002)中被采用。

强化学习在人类反馈上的应用(RLHF)

随着越来越多的人类评分示例出现,可以开发偏好模型来自动化响应评分。这个过程被称为RLHF(人类反馈强化学习),这促进了GPT-3.5和ChatGPT的发展。

精细化方法:RLAIF

一些 LLM 产品,例如 Claude,采用额外的步骤,利用另一个模型的反馈来进行校正和重写模型输出。这个过程被称为 RLAIF (AI 反馈的强化学习),确保最终的 LLM 比之前的迭代提供了改进的结果。

GPT-4的未知领域

OpenAI最著名的模型GPT-4,在其训练过程中很可能使用了某种形式的扩展RLHF。但是,这个过程的具体细节对公众来说仍然未知。此外,可以合理地假设,在GPT-4的基本LLM中进行了许多改进;尽管这些增强的确切性质只能推测。

结论

虽然LLMs确实可以预测文本,但它们的能力显然不仅限于简单的预测。它们生成的文本是抽象的,是间接由人类编写的。这个过程中出现了一个层次结构,人类形成了基础,顶上建立了各种AI层,包括在中间扮演AI角色的人类。了解这种复杂性有助于揭示LLMs复杂的功能和它们未来发展的潜力。

注意:本文旨在根据现有信息提供概述,可能未涵盖 LLM 发展的所有可能方面。