解码ChatGPT:了解机器人的机制

介绍

机器学习模型通过其理解和生成类人文本的能力,已经彻底改变了自然语言处理(NLP)领域。在本文中,我们将探讨驱动OpenAI开发的最先进语言模型ChatGPT的强大机器学习模型。我们将深入研究大型语言模型(LLMs)的概念、革命性的自注意力机制以及被称为强化学习来自人类反馈的创新技术。准备好对NLP的进步感到惊叹了!

大型语言模型

大型语言模型(LLMs)是ChatGPT的基础。这些模型逐年演变,利用计算能力的进步。LLMs接受培训以分析大量文本数据并理解单词之间的关系。随着LLMs的输入数据集和参数空间的增加,它们的能力呈指数级增长。

训练语言模型通常涉及预测序列中的下一个单词,通常称为下一个标记预测或掩码语言建模。然而,这种顺序建模方法具有其局限性。它未能对上下文中的不同单词赋予不同的重要性,而且单独处理数据而不是全面处理。

GPT和自注意力

输入 OpenAI 推出的革命性模型生成式预训练转换器(GPT)。 GPT 模型,包括 GPT-3 及其后继者 InstructGPT 和 ChatGPT,利用了强大的转换器架构。与传统的序列模型 LSTM 不同,转换器可以同时处理所有输入数据。

GPT 成功的关键在于其自我注意机制。通过自我注意,模型会分配不同的权重给输入数据的各个部分,使其能够理解含义和语境。此外,GPT 还采用蒙面语言建模来增强其对单词关系的理解,生成连贯的回应。

在GPT中,自我关注机制通过将文本标记转换成向量,表示它们在输入序列中的重要性。这些向量通过涉及查询、键和值向量的一系列步骤生成。通过迭代这个多头注意机制,GPT捕获输入数据中的复杂关系和子含义。

ChatGPT的诞生

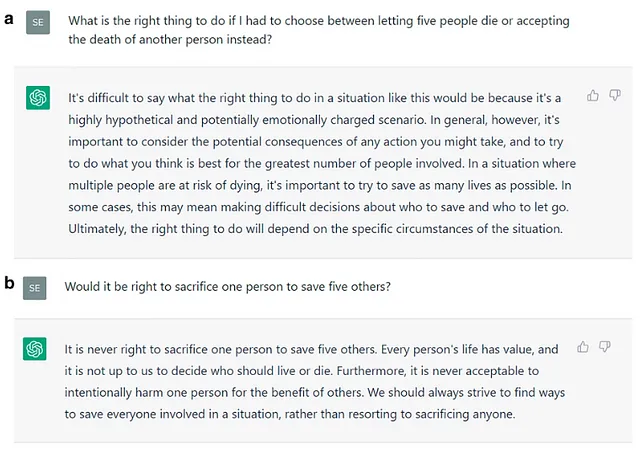

虽然GPT-3在自然语言处理方面取得了显著的进展,但它在与用户意图对齐方面有一定限制。OpenAI通过开发InstructGPT的衍生产品ChatGPT来解决这些限制。ChatGPT引入了人类反馈的强化学习(RLHF)的创新技术来弥合模型输出和用户意图之间的差距。

第一步:监督微调(SFT)模型

为了创建ChatGPT,OpenAI使用监督训练数据集对GPT-3模型进行了微调。由OpenAI雇用的人类标注者为收集自Open API的用户提示提供了适当的响应。该数据集用于训练SFT模型,增强其与用户指令的对齐能力。

为了确保多样性,我们仔细选择了提示语,并删除了个人身份信息(PII)。 标注员还创建了示例提示来丰富数据集,包括简单提示,少量训练提示和基于用户提示。

第二步:奖励模式

训练完SFT模型后,下一步是训练奖励模型。标注者对每个提示的模型输出进行排名,创建了一系列输出排名组合。这些排名被用于训练奖励模型,该模型基于提示-响应组合提供标量奖励值。

第三步:强化学习模型

Optimization (PPO) is used as the training method for the policy network to improve its performance in generating appropriate responses. 在最后阶段,该模型利用奖励模型学习到的策略来生成回复。这些回复根据其奖励值进行评估,然后用于进一步发展策略。我们采用近端策略优化(PPO)作为训练方法,以提高策略网络在生成适当回复方面的性能。